Índice del contenido

¿Qué rol debe jugar el liderazgo directivo en la evaluación del desempeño de los docentes?

La evaluación anual del desempeño docente no debe concebirse como un mero trámite administrativo, sino como una herramienta estratégica para la transformación institucional. En este escenario, el liderazgo directivo cumple una función esencial, pues no solo facilita el proceso, sino que le da sentido, dirección y propósito. Para entender con claridad este rol, es imprescindible descomponerlo en varias dimensiones que impactan directamente en la eficacia del proceso evaluativo.

1.1. Visionario y facilitador del cambio educativo

El líder directivo debe ser quien inspire una cultura de mejora continua, y eso solo se logra si se posiciona como facilitador del crecimiento docente, no como juez. En instituciones donde el liderazgo está alineado con una visión pedagógica sólida, la evaluación deja de ser punitiva y se convierte en un motor de transformación. El director debe proyectar el sentido de la evaluación como un proceso que contribuye al desarrollo profesional, alineado con los objetivos institucionales.

1.2. Diseñador del sistema de evaluación

No basta con aplicar un instrumento; el directivo debe liderar la construcción de un sistema de evaluación coherente, contextualizado y participativo. Esto implica seleccionar criterios adecuados, ajustar indicadores a las realidades locales, y garantizar que todos los actores comprendan el propósito y metodología del proceso evaluativo. Además, debe asegurar que la evaluación esté articulada con la planificación institucional y que permita la toma de decisiones basadas en evidencia.

1.3. Gestor de la cultura institucional

La actitud del cuerpo docente frente a la evaluación está directamente influenciada por la actitud del liderazgo. Un líder comprometido transmite confianza, apertura y transparencia. Promueve espacios de diálogo, estimula la autoevaluación y fomenta el acompañamiento pedagógico. No hay cultura evaluativa saludable sin una cultura institucional que la respalde, y esa cultura se construye desde la dirección.

1.4. Coordinador de recursos y medios

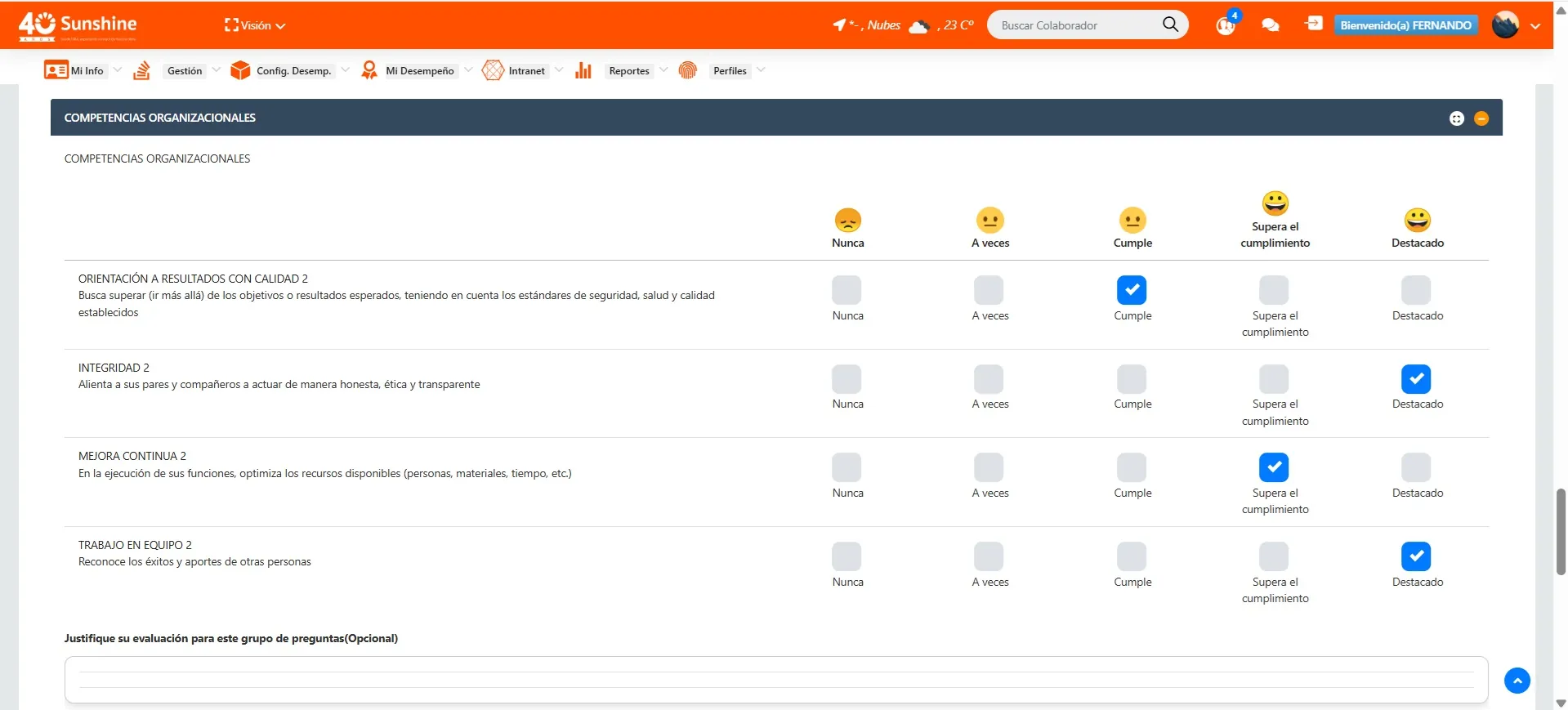

El proceso evaluativo exige recursos humanos, tecnológicos y formativos. El directivo debe garantizar la capacitación adecuada para los evaluadores, la disponibilidad de herramientas digitales, el acceso a rúbricas, evidencias y datos, y la asignación de tiempos institucionales para que el proceso sea riguroso y significativo. La evaluación no puede improvisarse ni resolverse entre jornadas; requiere planificación, y esa responsabilidad recae en la gestión directiva.

1.5. Evaluador del impacto y promotor de ajustes

Una vez realizada la evaluación, el liderazgo no finaliza su tarea. Al contrario, inicia el ciclo de mejora. El director debe liderar la lectura crítica de los resultados, diseñar estrategias de retroalimentación, y vincular los hallazgos a decisiones sobre formación continua, incentivos, movilidad interna o rediseño pedagógico. La evaluación es útil solo si tiene un efecto práctico; y ese efecto lo define, implementa y supervisa el líder institucional.

1.6. Ejemplo y coherencia

Un liderazgo que exige evaluación pero evita ser evaluado pierde legitimidad. Por eso, el directivo también debe ser parte del proceso, sometiéndose a evaluaciones de desempeño institucional, promoviendo la transparencia y demostrando apertura a la crítica. Esa coherencia fortalece el clima organizacional y convierte al directivo en modelo de aprendizaje permanente.

1.7. Constructores de puentes, no de murallas

Un liderazgo autoritario que impone evaluaciones de manera vertical rompe el diálogo. El rol del directivo debe ser el de mediador entre los intereses de la gestión educativa y las necesidades del cuerpo docente. Debe escuchar activamente, atender preocupaciones legítimas y construir consensos. La evaluación del desempeño solo será efectiva si es percibida como un proceso justo, claro y orientado a la mejora.

1.8. Conclusión: un liderazgo pedagógico transformacional

En síntesis, el liderazgo directivo en la evaluación del desempeño docente debe ser estratégico, inclusivo, formativo y transformacional. Debe asegurar la coherencia entre evaluación y mejora, entre datos y decisiones, entre procesos y propósitos. Un liderazgo que entiende la evaluación como herramienta de aprendizaje organizacional y desarrollo docente, convierte el proceso evaluativo en una de las piedras angulares de la excelencia institucional.

¿Qué beneficios de una rúbrica de evaluación transparente para docentes?

La implementación de una rúbrica de evaluación clara y transparente constituye uno de los pilares fundamentales para garantizar la efectividad, legitimidad y aceptación del proceso de evaluación del desempeño docente. No se trata simplemente de un instrumento técnico, sino de una herramienta estratégica que puede transformar profundamente la cultura institucional y profesionalizar la práctica docente. 2.1. Claridad en los criterios y expectativas Uno de los beneficios más inmediatos de una rúbrica transparente es que define con precisión lo que se espera del desempeño docente. Al establecer criterios observables, niveles de desempeño y descriptores detallados, la rúbrica elimina la ambigüedad. Esto no solo facilita la comprensión del proceso evaluativo, sino que proporciona a los docentes una hoja de ruta para orientar su trabajo diario. 2.2. Fortalecimiento del sentido de justicia y equidad La percepción de justicia es un componente crítico para la aceptación de cualquier sistema de evaluación. Una rúbrica transparente asegura que todos los docentes son evaluados bajo los mismos parámetros, reduciendo significativamente la posibilidad de arbitrariedad o subjetividad. Al aplicar los mismos estándares, se fortalece la equidad institucional y se minimizan los conflictos asociados a favoritismos o sesgos personales. 2.3. Fomento del desarrollo profesional autónomo Una buena rúbrica no es solo un instrumento de medición, sino también una guía para el crecimiento profesional. Permite que el docente se autoevalúe, identifique sus fortalezas y reconozca sus áreas de mejora. Esto promueve una cultura de autorreflexión continua, en la que el profesional no espera la evaluación como una instancia externa, sino que la convierte en un proceso interno permanente de mejora. 2.4. Mejora de la calidad del feedback La transparencia de una rúbrica también potencia la calidad de la retroalimentación que recibe el docente. Al estar basada en criterios definidos, el feedback se centra en aspectos concretos del desempeño y no en impresiones generales. Esto permite que la retroalimentación sea específica, accionable y orientada a metas claras, lo cual incrementa significativamente su valor formativo. 2.5. Optimización del proceso de toma de decisiones En contextos gerenciales, las decisiones sobre ascensos, incentivos, reconocimientos o programas de formación deben estar basadas en información objetiva y verificable. La rúbrica proporciona esa base sólida de datos. Al estandarizar el proceso evaluativo, facilita comparaciones válidas entre diferentes docentes y permite tomar decisiones institucionales más informadas y justas. 2.6. Fortalecimiento de la cultura institucional basada en el mérito Cuando una institución utiliza rúbricas claras y compartidas, comienza a consolidar una cultura organizacional que valora el esfuerzo, la mejora continua y la excelencia profesional. Esto envía un mensaje contundente a toda la comunidad educativa: el mérito es visible, evaluable y reconocido. A largo plazo, este principio fortalece la motivación y mejora el clima laboral. 2.7. Facilita el acompañamiento pedagógico Desde la perspectiva de los equipos de acompañamiento o coaching pedagógico, la rúbrica se convierte en una herramienta de diagnóstico y planificación. Permite observar patrones comunes, detectar necesidades formativas transversales y diseñar acciones personalizadas. A la vez, permite monitorear el progreso del docente con indicadores consistentes y medibles a lo largo del tiempo. 2.8. Disminuye la resistencia al proceso evaluativo Muchos de los temores que los docentes tienen frente a la evaluación provienen de la incertidumbre. Cuando se desconoce qué se evaluará, quién lo hará y cómo se interpretarán los resultados, es natural que surjan tensiones. La rúbrica transparente reduce esa ansiedad, dado que transforma el proceso en una instancia previsible, participativa y legítima. El docente se siente parte del proceso, no víctima de él. 2.9. Promueve la mejora en la práctica pedagógica Al mostrar con claridad niveles de desempeño, una rúbrica bien diseñada permite al docente visualizar qué implica pasar de un desempeño básico a uno destacado. Esta visión gradual, articulada con ejemplos concretos, se convierte en un estímulo para perfeccionar la práctica, innovar metodologías y asumir nuevos desafíos pedagógicos con mayor claridad. 2.10. Estimula la rendición de cuentas profesional En un entorno donde la calidad educativa es una responsabilidad compartida, la existencia de rúbricas transparentes fortalece la rendición de cuentas entre docentes y la institución. El profesional sabe que su labor será evaluada con base en criterios públicos, y esto genera un mayor compromiso ético con la mejora del aprendizaje de sus estudiantes y con su propio proceso de desarrollo. 2.11. Conclusión: una rúbrica como pacto institucional En suma, una rúbrica de evaluación transparente no es simplemente un cuadro con casillas; es un pacto entre la institución y sus docentes. Es una herramienta que profesionaliza, orienta, acompaña y transforma. Bien construida, se convierte en un instrumento de liderazgo pedagógico, capaz de alinear los esfuerzos individuales con los propósitos colectivos. En tiempos donde la educación requiere respuestas sólidas, la claridad evaluativa es un acto de justicia profesional.

¿Cómo asegurar la imparcialidad y objetividad en las evaluaciones anuales docentes?

La imparcialidad y la objetividad son condiciones innegociables para que una evaluación del desempeño docente sea aceptada como legítima y, sobre todo, útil. En ausencia de estos principios, cualquier intento de evaluar se vuelve cuestionable, pierde valor institucional y se convierte en fuente de conflictos internos. Garantizar un proceso justo requiere de una arquitectura robusta compuesta por normativas claras, procedimientos estandarizados, formación continua y transparencia comunicacional. 3.1. Establecer criterios públicos, explícitos y consensuados El primer paso hacia la objetividad es definir qué se va a evaluar, cómo y por qué. Los criterios deben estar alineados con los objetivos institucionales, reflejar buenas prácticas docentes y estar formulados en lenguaje comprensible. Además, deben ser conocidos por todos los actores desde el inicio del año escolar. No puede haber sorpresa en los instrumentos ni ambigüedad en las expectativas. 3.2. Diseñar rúbricas con descriptores observables y verificables La evaluación subjetiva nace donde el criterio no es claro o deja espacio a la interpretación personal. Por ello, es indispensable utilizar rúbricas estructuradas, con niveles de desempeño diferenciados y descripciones específicas de cada categoría. Cada descriptor debe ser verificable mediante evidencias concretas, como planificaciones, registros, resultados de aprendizajes o grabaciones de clase. 3.3. Incluir múltiples fuentes de información Confiar en una sola mirada o perspectiva introduce un alto riesgo de sesgo. Para contrarrestarlo, es recomendable incorporar diversas fuentes de datos: observaciones de clases, autoevaluaciones, evaluaciones entre pares, percepciones de estudiantes, análisis de productos pedagógicos y resultados académicos. La triangulación de información aumenta la objetividad y proporciona una visión más integral del desempeño. 3.4. Formar y certificar a los evaluadores La calidad del evaluador es determinante. Es fundamental que los encargados del proceso sean formados en evaluación objetiva, manejo de instrumentos, neutralidad en el juicio y análisis basado en evidencias. Incluso se recomienda implementar procesos de certificación interna o externa para quienes asumirán esta responsabilidad. La capacitación reduce los márgenes de error y mejora la coherencia entre evaluadores. 3.5. Separar la evaluación del juicio personal Uno de los grandes enemigos de la imparcialidad es el juicio subjetivo basado en relaciones personales, conflictos previos o afinidades. Por eso es vital establecer protocolos que reduzcan la influencia de factores emocionales. Por ejemplo, rotar a los evaluadores, mantener el anonimato en ciertos instrumentos y revisar evaluaciones sospechosas por un comité externo de control de calidad. 3.6. Usar tecnología para reducir el sesgo humano Plataformas digitales de evaluación pueden ayudar a estandarizar procesos, minimizar errores y registrar todas las decisiones con trazabilidad. Estas herramientas permiten aplicar instrumentos en línea, generar reportes automáticos y conservar las evidencias que respaldan cada evaluación. Además, disminuyen la posibilidad de manipulación de datos o ediciones posteriores sin autorización. 3.7. Fomentar la autoevaluación con guía metodológica La autoevaluación, bien aplicada, fortalece la transparencia. Si se entrega con una guía técnica que oriente al docente sobre cómo valorarse objetivamente, puede convertirse en una herramienta poderosa. Comparar los resultados de la autoevaluación con los del evaluador externo permite detectar discrepancias significativas que podrían revelar sesgos o percepciones erróneas, y da lugar a conversaciones pedagógicas más profundas. 3.8. Establecer mecanismos de apelación y revisión Todo sistema justo contempla la posibilidad de disenso. Es necesario que los docentes puedan apelar sus resultados cuando consideran que no reflejan fielmente su desempeño. Para ello, debe existir un comité imparcial, con capacidad técnica y credibilidad institucional, que revise las evidencias, escuche al evaluado y, si corresponde, rectifique el resultado. 3.9. Aplicar auditorías internas periódicas Un sistema de evaluación no es estático ni infalible. Se deben realizar auditorías internas para detectar patrones de inconsistencias, sesgos repetidos o criterios aplicados de manera desigual. Estas auditorías pueden incluir revisión aleatoria de expedientes, encuestas de percepción y análisis estadístico de los resultados. Su objetivo no es sancionar, sino mejorar el sistema. 3.10. Transparencia y comunicación institucional Cuando los docentes comprenden cómo se estructura el proceso, quién lo lidera, con qué herramientas se mide, y qué garantías de imparcialidad existen, disminuyen los niveles de desconfianza. Una comunicación institucional clara, oportuna y honesta es clave. La transparencia construye credibilidad, y la credibilidad es la base sobre la que se acepta la evaluación como herramienta de mejora. 3.11. Conclusión: imparcialidad como eje de legitimidad La objetividad no es una condición espontánea: se construye con planificación, técnica y ética. Las evaluaciones que cumplen estos principios se convierten en plataformas de transformación pedagógica, mejora institucional y desarrollo profesional. Aquellas que los ignoran, fracasan en su propósito y fracturan el clima organizacional. La imparcialidad no solo es deseable, es indispensable para cualquier institución educativa que aspire a la excelencia.

¿Qué rol tiene el coaching pedagógico tras la evaluación del desempeño?

En el contexto organizacional contemporáneo, las competencias técnicas ya no bastan para definir la efectividad de un líder o colaborador. Las habilidades blandas —comúnmente llamadas soft skills— como la comunicación, la empatía, la inteligencia emocional, la escucha activa o la capacidad de resolver conflictos, se han convertido en diferenciadores clave para el desempeño individual y colectivo. Sin embargo, su evaluación y desarrollo requieren de mecanismos que superen los modelos tradicionales centrados únicamente en indicadores cuantificables. Aquí es donde la evaluación 360 grados se posiciona como una herramienta esencial para catalizar el desarrollo de estas habilidades. 1. Las soft skills como elementos invisibles del desempeño Las habilidades blandas, por su naturaleza intangible, son difíciles de identificar a través de formatos de evaluación convencionales. Un sistema que se limita al cumplimiento de objetivos o a reportes individuales no puede capturar dimensiones como la forma en que un líder gestiona la emocionalidad de su equipo o cómo un colaborador influye en la moral colectiva con su actitud. La evaluación 360 grados, al recabar percepciones de diversas fuentes (subordinados, pares, supervisores y, en algunos casos, stakeholders externos), tiene la capacidad de mapear esas habilidades a través de patrones de comportamiento observados y relatados desde diferentes ángulos. Así, proporciona una base empírica desde la cual puede iniciarse un proceso auténtico de desarrollo personal y profesional. 2. Diseño del instrumento para el enfoque en habilidades blandas Para que el feedback 360 contribuya al desarrollo de soft skills, es fundamental que el diseño de las encuestas incluya dimensiones específicas como: Manejo de emociones en situaciones de presión Nivel de apertura y receptividad frente a ideas distintas Capacidad de escuchar y comprender al otro sin interrumpir Habilidad para influir sin imponer Claridad y asertividad en la comunicación Disposición para colaborar en lugar de competir Actitud ante el conflicto: evitación, confrontación o mediación Nivel de confianza que inspira en el entorno Incluir preguntas conductuales, contextualizadas y orientadas a ejemplos observables facilita que los evaluadores puedan dar respuestas útiles y que el evaluado comprenda con claridad qué habilidades necesita trabajar. 3. De la evaluación al aprendizaje: cómo interpretar el feedback Una evaluación 360 bien implementada no termina en la entrega de resultados. El verdadero valor está en la conversación posterior: el espacio donde el colaborador comprende el significado de los datos, se reconoce en ellos y empieza a tomar conciencia de los ajustes que debe realizar. En una empresa del sector salud, se detectó que muchos líderes técnicos obtenían puntuaciones bajas en indicadores como “comunica de forma inspiradora” y “responde con empatía ante dificultades personales de su equipo”. A partir de esos hallazgos, se diseñó un programa de desarrollo que combinaba sesiones de coaching emocional, entrenamiento en inteligencia relacional y dinámicas de escucha activa. El cambio fue tan tangible que en la siguiente ronda de 360, los líderes comenzaron a ser reconocidos no solo por su capacidad clínica, sino por su rol como referentes humanos en el equipo. 4. El feedback como espejo y motor de crecimiento personal Una de las mayores fortalezas del feedback multifuente es que actúa como un espejo colectivo. Cuando diferentes personas coinciden en señalar, por ejemplo, que alguien tiende a interrumpir, que evita conversaciones difíciles o que no escucha con atención, ese patrón adquiere un peso incontestable que difícilmente puede ser ignorado. Esta confrontación empática genera las condiciones para el desarrollo de conciencia y autocrítica, sin las cuales no hay evolución posible. Además, cuando el feedback se entrega con acompañamiento —por ejemplo, mediante un coach o un mentor— se transforma en una oportunidad de crecimiento emocional y profesional. El evaluado deja de ver el feedback como un juicio, y lo asume como una herramienta de desarrollo, incluso como un privilegio. 5. La madurez organizacional como facilitador del aprendizaje emocional Para que el feedback 360 impacte positivamente en las soft skills, es indispensable que la organización haya cultivado una cultura de apertura, aprendizaje y seguridad psicológica. En ambientes punitivos o excesivamente jerárquicos, el feedback tiende a ser defensivo, superficial o directamente falsificado. Por el contrario, cuando hay confianza, los evaluadores se atreven a decir lo que realmente observan y el evaluado se siente en condiciones de recibirlo sin temores. Esta madurez cultural se construye con liderazgo ejemplar, transparencia en la gestión de los procesos y coherencia entre lo que la empresa dice que valora y lo que realmente premia. Solo en ese contexto, el feedback se convierte en una herramienta de transformación y las soft skills pueden desarrollarse de forma sostenida. 6. Integración con programas de desarrollo individualizado Un error frecuente en muchas organizaciones es aplicar el 360 como una iniciativa aislada. El verdadero impacto ocurre cuando el feedback se convierte en la base de planes de acción individualizados. Esto puede incluir: Programas de coaching individual para líderes con brechas emocionales Talleres grupales de comunicación efectiva Simulaciones de conversaciones difíciles con retroalimentación inmediata Medición del progreso de las soft skills en evaluaciones periódicas Reconocimiento formal del desarrollo conductual junto al desempeño técnico Una organización que integra estas prácticas puede transformar completamente su modelo de liderazgo. El énfasis ya no estará en la autoridad jerárquica, sino en la influencia humana, en la capacidad de construir relaciones saludables y equipos resilientes. Conclusión El desarrollo de soft skills no puede dejarse al azar ni a la buena voluntad individual. Necesita sistemas, estructura y retroalimentación de calidad. La evaluación 360 grados, correctamente diseñada y aplicada, es una palanca formidable para acelerar este proceso. Al proporcionar una visión sistémica del comportamiento de los colaboradores, permite identificar, confrontar y trabajar aquellas dimensiones que hacen la diferencia entre un técnico competente y un líder verdaderamente transformador.

¿Cómo medir el impacto de la evaluación en los aprendizajes estudiantiles?

Uno de los desafíos más complejos y a la vez más trascendentales dentro del sistema educativo es demostrar que los procesos internos de evaluación docente efectivamente contribuyen a mejorar los aprendizajes de los estudiantes. Si bien la relación entre evaluación docente y resultados de aprendizaje no siempre es inmediata ni lineal, sí puede establecerse una correlación sólida cuando el proceso es bien diseñado, ejecutado y retroalimentado. Para abordar esta cuestión, se deben considerar múltiples dimensiones interconectadas.

5.1. Clarificar la hipótesis de impacto

Antes de medir cualquier resultado, es necesario establecer con claridad qué se espera lograr. En este caso, la hipótesis es que una evaluación docente bien implementada —con criterios claros, retroalimentación efectiva y acompañamiento— propicia cambios en la práctica pedagógica que, a su vez, elevan el nivel de aprendizaje de los estudiantes. Esta hipótesis debe guiar todo el diseño de monitoreo y evaluación posterior.

5.2. Articular los indicadores de desempeño con los indicadores de aprendizaje

Uno de los errores más comunes es evaluar al docente bajo unos criterios y luego esperar mejoras en el aprendizaje sin relación directa. Para establecer una cadena lógica de resultados, es imprescindible que los indicadores del desempeño docente estén alineados con los factores que más inciden en los aprendizajes: planificación coherente, estrategias activas, evaluación formativa, uso de retroalimentación, manejo del tiempo en aula, entre otros. Al establecer esta coherencia, se pueden comparar comportamientos docentes con resultados en aula.

5.3. Medir cambios en las prácticas pedagógicas

El impacto en el estudiante solo es posible si la evaluación induce cambios en el comportamiento del docente. Por eso, el primer nivel de análisis debe centrarse en medir si la evaluación realmente modifica la práctica docente. Esto puede hacerse a través de nuevas observaciones de clase, análisis de instrumentos de planificación posteriores a la evaluación, entrevistas al docente o encuestas al alumnado sobre nuevas metodologías implementadas. Si no hay evidencia de cambio, difícilmente habrá impacto.

5.4. Utilizar pruebas comparativas de rendimiento

Una vez verificado el cambio en la práctica, se puede pasar a medir resultados de aprendizaje. Esto se logra mediante la comparación de pruebas internas o estandarizadas aplicadas antes y después de la intervención evaluativa. Es importante que estas pruebas evalúen habilidades clave del currículo y que su aplicación sea rigurosa. Asimismo, debe contemplarse un análisis de progresión más que de niveles absolutos.

5.5. Incorporar la percepción de los estudiantes

El aprendizaje no es solo medible en notas. La percepción del estudiante sobre su propio progreso, la claridad con que el docente enseña, la relevancia de los contenidos o la retroalimentación que recibe también son indicadores valiosos. Encuestas estructuradas, grupos focales y entrevistas individuales pueden ofrecer información cualitativa profunda sobre cómo la mejora en el desempeño docente incide en la experiencia de aprendizaje del estudiante.

5.6. Establecer líneas base y mecanismos de seguimiento

Sin una línea base clara —es decir, sin información documentada del nivel inicial del docente y del grupo de estudiantes— es difícil establecer causalidad. Es fundamental diseñar sistemas de seguimiento que recojan información periódica, estructurada y comparable. Esto puede incluir bitácoras pedagógicas, grabaciones de clase, portafolios de evidencias y análisis de desempeño progresivo en estudiantes.

5.7. Considerar factores externos al aula

Si bien la mejora docente influye en los aprendizajes, también existen múltiples factores externos que pueden distorsionar o potenciar los resultados: condiciones socioeconómicas, asistencia escolar, infraestructura, apoyo familiar, entre otros. Por ello, la medición del impacto debe incorporar herramientas de análisis multivariable que permitan controlar estos elementos y aislar, en lo posible, el efecto específico de la intervención evaluativa.

5.8. Aplicar modelos de evaluación longitudinal

El verdadero impacto educativo se manifiesta en el tiempo. Resultados inmediatos pueden ser engañosos o poco sostenibles. Por ello, se recomienda diseñar modelos de evaluación longitudinal que sigan el progreso de los docentes evaluados y de sus estudiantes durante al menos dos o tres ciclos académicos. Esta estrategia permite verificar si los cambios implementados se mantienen y si su efecto en los aprendizajes se consolida.

5.9. Vincular los resultados al sistema de gestión institucional

Para que el impacto de la evaluación docente se traduzca en mejor aprendizaje, los resultados deben tener consecuencias en la gestión institucional: diseño de planes de mejora, ajustes curriculares, fortalecimiento de la formación continua y redirección de recursos. Es necesario que el liderazgo directivo interprete los resultados y los convierta en decisiones de política interna que favorezcan la calidad educativa.

5.10. Conclusión: del dato a la transformación pedagógica

Medir el impacto de la evaluación docente en los aprendizajes estudiantiles no es una tarea sencilla, pero sí imprescindible. Supone pasar del dato aislado a la construcción de evidencias sólidas que respalden la toma de decisiones. Cuando se logra demostrar que una evaluación profesional, objetiva y bien acompañada mejora las prácticas docentes, y que esas prácticas transforman los aprendizajes, entonces la evaluación deja de ser un acto administrativo para convertirse en una herramienta de mejora educativa estructural.

¿Qué desafíos legales y éticos están asociados a la evaluación del desempeño docente?

La evaluación del desempeño docente es una herramienta clave para garantizar la calidad educativa, pero su implementación conlleva una serie de desafíos legales y éticos que no pueden ser subestimados. Una evaluación mal conducida no solo afecta al profesional docente y a la credibilidad institucional, sino que también puede derivar en conflictos laborales, demandas jurídicas o afectaciones irreversibles a la cultura organizacional. Por ello, toda institución educativa que aspire a realizar evaluaciones con legitimidad y seguridad debe anticipar y gestionar estos desafíos con responsabilidad.

6.1. Garantizar el principio de debido proceso

Desde una perspectiva legal, la evaluación del desempeño debe regirse por los principios fundamentales del derecho administrativo: legalidad, imparcialidad, objetividad, contradicción y transparencia. Esto implica que todo docente debe conocer con antelación los criterios, métodos e instrumentos de evaluación; debe tener la posibilidad de revisar sus resultados; y debe contar con instancias formales para apelar decisiones que considere injustas. Omitir estos aspectos puede constituir una violación al debido proceso.

6.2. Protección de datos personales y confidencialidad

Los resultados de la evaluación del desempeño forman parte del historial profesional del docente y, por tanto, están protegidos por las leyes de protección de datos. Es responsabilidad de la institución garantizar que esta información no sea divulgada sin autorización, que esté resguardada de forma segura y que solo accedan a ella las personas autorizadas. La filtración o el uso indebido de estos datos puede derivar en sanciones administrativas y penales, además de daños reputacionales para la organización.

6.3. Prevención de conflictos de interés

En muchos entornos escolares, las relaciones entre evaluadores y evaluados pueden estar marcadas por cercanías personales, rivalidades, diferencias ideológicas o incluso jerarquías informales. Este contexto puede propiciar juicios sesgados, especialmente si no existen mecanismos de control externo. Éticamente, es indispensable que el proceso contemple la rotación de evaluadores, el uso de múltiples fuentes de evidencia y la supervisión por parte de comités imparciales.

6.4. Evitar la evaluación punitiva o coercitiva

Uno de los errores más frecuentes es utilizar la evaluación como un mecanismo para sancionar indirectamente, ejercer presión o controlar políticamente al cuerpo docente. Esta práctica, además de ser éticamente reprobable, atenta contra el principio de mejora continua que debe guiar todo proceso evaluativo. Una evaluación que genera temor o desgaste emocional masivo pierde toda su capacidad formativa y puede derivar en entornos tóxicos, litigios laborales o deserción del talento profesional.

6.5. Inclusión de enfoques diferenciados para contextos diversos

No todos los docentes enfrentan las mismas condiciones de trabajo. Aquellos que enseñan en zonas rurales, entornos vulnerables o en contextos de diversidad cultural y lingüística requieren una evaluación que contemple su realidad. Aplicar los mismos indicadores sin ajustes puede llevar a resultados injustos y discriminatorios. Desde la ética profesional, esto constituye un acto de invisibilización institucional que debe evitarse a través del diseño de rúbricas diferenciadas y modelos de evaluación contextualizados.

6.6. Responsabilidad institucional sobre el uso de los resultados

Una vez realizada la evaluación, la institución tiene la responsabilidad de actuar sobre los hallazgos. Ignorar los resultados o utilizarlos con fines ajenos a la mejora (por ejemplo, como base exclusiva para despidos o exclusión de beneficios) contraviene el propósito mismo del proceso. Éticamente, la evaluación debe generar acciones de acompañamiento, formación continua, reconocimiento y apoyo para que los docentes puedan mejorar sus competencias.

6.7. Respeto a la dignidad y bienestar del evaluado

La evaluación no puede poner en riesgo la estabilidad emocional o profesional del docente. Esto significa evitar prácticas humillantes, retroalimentaciones públicas, evaluaciones sorpresivas o informes escritos en tono peyorativo. Cada docente tiene derecho a un trato respetuoso, privado y humano. La ética profesional obliga a considerar no solo el contenido de la evaluación, sino la manera en que esta es aplicada y comunicada.

6.8. Compatibilidad con la normativa laboral vigente

Toda evaluación debe estar alineada con el marco legal que regula el ejercicio docente en cada país o región. Esto incluye convenios colectivos, estatutos del docente, reglamentos internos y demás normativas aplicables. La institución debe revisar cuidadosamente que los criterios e instrumentos utilizados no contradigan derechos adquiridos o condiciones contractuales. De lo contrario, el proceso podría ser impugnado legalmente.

6.9. Posibilidad de sesgos estructurales

Más allá del juicio personal, la evaluación docente puede incorporar sesgos institucionales o culturales si no es cuidadosamente diseñada. Por ejemplo, puede penalizar involuntariamente a docentes que utilizan metodologías innovadoras, a quienes trabajan con poblaciones con bajo rendimiento histórico o a quienes no se alinean con estilos de liderazgo dominantes. Reconocer estos sesgos y eliminarlos del proceso es una exigencia ética fundamental.

6.10. Conclusión: construir un marco ético-legal robusto

La evaluación del desempeño docente no puede ser improvisada ni aplicada mecánicamente. Requiere un marco ético y legal sólido, construido sobre el respeto a los derechos profesionales, la equidad de trato y la búsqueda de la excelencia educativa. La legitimidad del proceso no depende solo de sus instrumentos, sino del modo en que estos se aplican, del propósito que los guía y del impacto que generan. Toda evaluación sin ética es una amenaza; con ética, se convierte en una oportunidad para transformar la práctica docente y fortalecer el sistema educativo.

¿Cómo ajustar la evaluación a contextos educativos rurales o vulnerables?

Uno de los principios rectores de toda política educativa equitativa es su capacidad de adaptarse a la diversidad de contextos en los que opera. La evaluación del desempeño docente no es la excepción. Aplicar los mismos criterios y formatos de evaluación en entornos rurales, urbanos, privados, marginales o interculturales sin ajustes contextuales puede no solo arrojar resultados sesgados, sino profundizar las brechas estructurales existentes. Evaluar en contextos vulnerables exige una comprensión profunda del entorno, una lectura empática de las condiciones del docente y un rediseño técnico de los instrumentos y procedimientos.

7.1. Reconocimiento de las condiciones estructurales

Todo proceso de evaluación debe partir de una caracterización del contexto. En zonas rurales o vulnerables, los docentes pueden enfrentar dificultades que escapan a su control: falta de infraestructura, escasa conectividad, niveles de pobreza extrema, violencia, desnutrición infantil o ausencia de apoyo familiar. Estos factores deben ser considerados explícitamente en el diseño de la evaluación. No hacerlo genera juicios injustos y penaliza injustificadamente a docentes que, en muchos casos, hacen esfuerzos extraordinarios.

7.2. Adaptación de los instrumentos evaluativos

No basta con reducir la exigencia. Se trata de adecuar el enfoque. Las rúbricas de evaluación deben contener criterios flexibles y sensibles al entorno. Por ejemplo, en lugar de exigir tecnologías digitales que no están disponibles, puede evaluarse la capacidad del docente para crear materiales alternativos o gestionar recursos comunitarios. En lugar de aplicar pruebas estandarizadas, se pueden recoger portafolios de evidencia contextual, entrevistas con estudiantes y observaciones cualitativas de clase.

7.3. Formación de evaluadores con enfoque territorial

Los equipos evaluadores deben recibir formación específica sobre el contexto rural o vulnerable donde realizarán sus observaciones. Esto incluye aspectos culturales, sociales, lingüísticos y pedagógicos propios del territorio. La ignorancia o el prejuicio del evaluador puede contaminar el proceso. En algunos casos, se recomienda incluir evaluadores locales o representantes comunitarios que validen el proceso desde la legitimidad territorial.

7.4. Incorporación de criterios de resiliencia y gestión comunitaria

En contextos adversos, el rol del docente trasciende lo pedagógico. Muchas veces, actúa como mediador social, agente de salud, gestor comunitario o mentor emocional de sus estudiantes. Estos aspectos deben valorarse en la evaluación. Incluir indicadores de resiliencia, liderazgo comunitario, adaptabilidad y compromiso institucional permite captar una imagen más completa del desempeño en entornos difíciles.

7.5. Uso de métodos cualitativos y participativos

Los enfoques cuantitativos estándar pueden ser insuficientes o inadecuados en contextos de alta variabilidad. Se recomienda complementar la evaluación con metodologías cualitativas: entrevistas, grupos focales, historias de caso, estudios etnográficos, entre otros. Estos métodos permiten conocer las estrategias del docente frente a la adversidad, su vínculo con los estudiantes y su impacto más allá de los resultados académicos formales.

7.6. Redefinición de los resultados esperados

Evaluar el logro de aprendizajes en contextos de alta vulnerabilidad exige redefinir el éxito. A veces, mantener la asistencia escolar o lograr aprendizajes básicos representa un logro significativo. Los indicadores deben ser realistas, proporcionales al contexto y sensibles a procesos progresivos. Comparar el rendimiento de estos estudiantes con promedios nacionales o estándares urbanos puede generar juicios erróneos y deslegitimar el trabajo docente.

7.7. Acompañamiento formativo posterior a la evaluación

En lugar de utilizar la evaluación como mecanismo sancionador, debe convertirse en un insumo para el diseño de apoyos específicos. En zonas rurales o vulnerables, esto puede incluir tutorías pedagógicas, provisión de materiales, conexión a redes de práctica, asesoramiento emocional o mejora de las condiciones laborales. El enfoque debe ser de corresponsabilidad institucional, no de delegación exclusiva en el docente.

7.8. Participación comunitaria en el proceso evaluativo

Los actores comunitarios tienen una mirada profunda y legítima sobre el trabajo del docente. Incluir sus percepciones —padres, líderes locales, asociaciones comunales— aporta riqueza al proceso y fortalece el vínculo entre escuela y comunidad. Además, garantiza que la evaluación no se perciba como una imposición externa, sino como una instancia colaborativa.

7.9. Evaluación como acto de justicia territorial

Desde una perspectiva ética, la evaluación contextualizada es un acto de justicia. Reconoce que la excelencia docente no puede medirse con una sola vara. Valora el esfuerzo frente a la adversidad y legitima estrategias que, aunque distintas de las convencionales, son profundamente efectivas en su entorno. Las instituciones que aplican este principio fortalecen su legitimidad, aumentan la fidelización del talento docente y contribuyen a cerrar brechas históricas.

7.10. Conclusión: adaptar para valorar con justicia

La evaluación docente en contextos rurales o vulnerables no puede limitarse a aplicar instrumentos estándar con pequeñas modificaciones. Debe replantearse desde su diseño, operación e interpretación para garantizar que sea justa, formativa y transformadora. Evaluar desde el contexto no es reducir la exigencia, sino elevar la pertinencia. Solo así, la evaluación podrá convertirse en una verdadera herramienta de equidad educativa.

¿Qué sesgos pueden contaminar una evaluación docente y cómo evitarlos?

La confiabilidad de una evaluación del desempeño docente depende en gran medida de su capacidad para representar fielmente la realidad. Sin embargo, como todo proceso humano, la evaluación está expuesta a múltiples sesgos —conscientes o inconscientes— que pueden distorsionar los resultados, afectar la credibilidad del proceso y dañar la confianza institucional. Identificar estos sesgos, entender sus causas y establecer mecanismos concretos para prevenirlos debe ser una prioridad estratégica de todo sistema evaluativo.

8.1. Sesgo de halo o efecto de primacía

Este sesgo ocurre cuando un evaluador se deja influenciar por una característica positiva o negativa muy visible del docente (como carisma, fluidez verbal, puntualidad o informalidad) y a partir de ahí generaliza su juicio sobre todo el desempeño. Por ejemplo, un docente con buen manejo escénico puede recibir una evaluación alta incluso si sus estrategias pedagógicas son débiles.

Prevención: Capacitación específica en evaluación objetiva, uso de rúbricas con descriptores claros y registro de evidencias observables ayuda a neutralizar esta distorsión.

8.2. Sesgo de confirmación

Se manifiesta cuando el evaluador busca, de manera inconsciente, información que confirme una idea previa que ya tiene del docente, basada en experiencias anteriores, rumores o prejuicios. Esto puede conducir a una evaluación parcial, sin considerar todos los aspectos del desempeño real.

Prevención: Aplicación de protocolos que exijan triangulación de fuentes, observación estructurada y revisión cruzada de evaluaciones por parte de un comité técnico independiente.

8.3. Sesgo de severidad o indulgencia

Algunos evaluadores tienden a ser excesivamente estrictos o, por el contrario, excesivamente permisivos en sus calificaciones. Este sesgo contamina las comparaciones entre docentes y pone en duda la validez de los resultados.

Prevención: Estandarización de criterios, escalas bien definidas, uso de anclajes descriptivos en las rúbricas, y sesiones de calibración entre evaluadores antes de iniciar el proceso.

8.4. Sesgo de simpatía o afinidad personal

Cuando existe una relación cercana —amistad, familiaridad o afinidad ideológica— entre evaluador y evaluado, el juicio puede estar condicionado por factores afectivos y no por el desempeño profesional real.

Prevención: Asignación aleatoria de evaluadores, rotación periódica de equipos evaluadores y declaración explícita de conflictos de interés que descalifiquen al evaluador en ciertos casos.

8.5. Sesgo de contraste

Este sesgo ocurre cuando el evaluador juzga al docente no por su desempeño en sí mismo, sino en comparación con otros colegas. Por ejemplo, si previamente evaluó a un docente de alto nivel, puede calificar de manera injustamente baja al siguiente, por contraste.

Prevención: Entrenamiento en evaluación comparativa contra estándares, no contra personas. El uso de rúbricas bien calibradas disminuye el efecto del contraste.

8.6. Sesgo de expectativa institucional

A veces el evaluador ajusta sus juicios para que los resultados coincidan con lo que la institución espera encontrar: mejoras con respecto al año anterior, altos promedios para acceder a premios, o resultados bajos para justificar intervenciones externas.

Prevención: Blindaje técnico del proceso de evaluación, autonomía metodológica del equipo evaluador y auditorías internas o externas de control de calidad.

8.7. Sesgo de uniformidad

Algunos evaluadores asignan la misma calificación a todos los indicadores del docente, por comodidad o falta de profundidad en el análisis, lo que genera evaluaciones planas, sin matices ni especificidad.

Prevención: Diseño de rúbricas que obliguen a justificar cada nivel de logro, revisión posterior de las evaluaciones por parte de una instancia supervisora y espacios de feedback en doble vía.

8.8. Sesgos culturales o de contexto

Evaluadores que no conocen las condiciones particulares del contexto educativo pueden interpretar erróneamente ciertos comportamientos o estrategias del docente. Esto es especialmente frecuente en evaluaciones aplicadas en zonas rurales, comunidades indígenas o contextos de alta vulnerabilidad.

Prevención: Formación intercultural de los evaluadores, contextualización explícita de los instrumentos y, cuando sea posible, inclusión de evaluadores locales o mixtos.

8.9. Sesgo por presión del tiempo

Cuando el proceso evaluativo se realiza bajo presión, sin tiempo suficiente para observar, analizar y reflexionar, las decisiones tienden a ser más intuitivas y menos precisas. Esto afecta la objetividad del proceso.

Prevención: Planificación anticipada del calendario evaluativo, asignación de tiempos institucionales exclusivos para el proceso y supervisión del cumplimiento de los protocolos establecidos.

8.10. Conclusión: profesionalizar el juicio para garantizar justicia

Ningún sistema de evaluación está exento de sesgos, pero todos pueden ser diseñados para reducirlos sistemáticamente. La clave está en asumir que la objetividad no es una condición espontánea, sino el resultado de un proceso técnico, ético y profesional. Invertir en la formación de evaluadores, mejorar los instrumentos, diversificar las fuentes de información y auditar los resultados no son costos: son garantías. Porque cada sesgo que no se detecta contamina no solo una evaluación, sino la confianza de toda una comunidad educativa.

¿Qué errores deben evitarse al implementar una rúbrica de evaluación docente?

La rúbrica de evaluación docente es un instrumento técnico de alto impacto institucional. Cuando está bien diseñada y aplicada, permite medir el desempeño de manera estructurada, objetiva y útil para el desarrollo profesional. Sin embargo, en la práctica, muchas rúbricas fallan en cumplir su propósito debido a errores de diseño, uso o interpretación. Estos fallos no solo distorsionan los resultados, sino que afectan la percepción de legitimidad del proceso evaluativo y pueden desencadenar consecuencias negativas en la cultura organizacional. Identificar estos errores y anticiparlos es una responsabilidad directiva clave. 9.1. Utilizar descriptores ambiguos o poco observables Una de las fallas más comunes es redactar criterios que no son medibles en la práctica o que pueden prestarse a múltiples interpretaciones. Frases como “posee actitud positiva” o “es innovador en clase” carecen de claridad operacional. Corrección: Redactar descriptores con verbos observables, anclajes de evidencia concreta y niveles de desempeño claramente diferenciados. Cada descriptor debe responder a la pregunta: ¿qué tendría que ver o revisar el evaluador para afirmar esto? 9.2. No vincular la rúbrica con el perfil docente institucional Diseñar rúbricas genéricas sin conexión con el modelo pedagógico de la institución genera desconexión entre la práctica y la evaluación. Esto provoca que los docentes no comprendan la utilidad del instrumento. Corrección: Alinear la rúbrica con el perfil profesional docente definido por la institución, sus principios pedagógicos, el currículo y los objetivos de aprendizaje. La rúbrica debe reflejar lo que se espera del docente según el proyecto educativo institucional. 9.3. Aplicar la misma rúbrica en todos los niveles y modalidades Un error frecuente es usar un único formato de rúbrica para evaluar desde nivel inicial hasta educación media o desde áreas técnicas hasta artísticas. Esto desconoce la especificidad de cada etapa, materia o modalidad. Corrección: Diseñar versiones ajustadas por nivel educativo, área disciplinar y contexto institucional, manteniendo una estructura común, pero con descriptores contextualizados. 9.4. Exceso o escasez de indicadores Una rúbrica sobrecargada con decenas de indicadores puede generar fatiga en el evaluador y falta de profundidad en el análisis. Por el contrario, una rúbrica con muy pocos criterios puede simplificar en exceso la complejidad del desempeño docente. Corrección: Seleccionar entre 5 y 8 dimensiones clave del desempeño, y dentro de ellas, de 3 a 5 indicadores representativos por dimensión. Priorizar calidad sobre cantidad y asegurar equilibrio. 9.5. No capacitar adecuadamente a los evaluadores Una buena rúbrica pierde toda su potencia si quienes la aplican no están entrenados en su uso. Interpretaciones erróneas, juicios basados en opiniones y aplicación inconsistente son síntomas de este error. Corrección: Implementar procesos sistemáticos de formación y calibración de evaluadores. Asegurar que todos comprendan el sentido de cada descriptor, las evidencias esperadas y la forma correcta de puntuar. 9.6. No implicar a los docentes en la construcción o revisión de la rúbrica Cuando el instrumento es impuesto sin consulta, genera desconfianza y resistencia. La participación del cuerpo docente es clave para su validación contextual y legitimación. Corrección: Incluir representantes del profesorado en comités técnicos de revisión, realizar pilotos previos a su aplicación oficial y recoger retroalimentación para mejorarla. 9.7. Falta de correspondencia entre puntuaciones y retroalimentación En algunos casos, las rúbricas se aplican mecánicamente, asignando puntajes sin desarrollar retroalimentaciones útiles. Esto convierte la evaluación en un ejercicio vacío de sentido formativo. Corrección: Acompañar cada dimensión evaluada con comentarios cualitativos que expliquen el juicio asignado, propongan mejoras y reconozcan logros concretos. La rúbrica debe ser un medio, no un fin. 9.8. No considerar evidencias diversas en la aplicación de la rúbrica Reducir la evaluación a una sola observación de clase o al uso de un único instrumento puede limitar la visión del desempeño docente y sesgar los resultados. Corrección: Complementar la rúbrica con análisis de planificaciones, entrevistas, evidencias de trabajo estudiantil, autoevaluaciones y encuestas de percepción. La triangulación fortalece la validez del proceso. 9.9. Falta de claridad en los niveles de logro Cuando los niveles de desempeño (por ejemplo, básico, competente, destacado) no están bien definidos, los evaluadores pueden aplicar criterios arbitrarios y los docentes no sabrán cómo avanzar de un nivel a otro. Corrección: Definir los niveles con descriptores específicos, incrementales y diferenciados. Incluir ejemplos o anclajes para cada nivel que sirvan como referencia común. 9.10. Conclusión: una rúbrica no es un formulario, es un contrato pedagógico Una rúbrica mal diseñada puede dañar profundamente la cultura evaluativa de una institución. Una rúbrica bien diseñada, en cambio, se convierte en una herramienta de desarrollo profesional, justicia organizacional y mejora continua. No basta con tener el instrumento; se requiere un sistema técnico, ético y contextual que lo respalde. El liderazgo gerencial debe asumir con responsabilidad el diseño, la implementación y la revisión periódica de las rúbricas, entendiendo que cada descriptor no es una casilla, sino una declaración institucional sobre lo que se valora en la profesión docente.

¿Cómo articular la evaluación docente con la gestión estratégica institucional?

La evaluación del desempeño docente no puede operar como un proceso aislado, paralelo o desconectado de la planificación estratégica de una institución educativa. Muy por el contrario, cuando se articula correctamente con los objetivos organizacionales, se convierte en un recurso potente para la toma de decisiones, el desarrollo de talento, la mejora continua y la consolidación de una cultura institucional orientada al aprendizaje y a la calidad. Esta articulación no se da por sí sola; debe ser diseñada, sostenida y evaluada desde una lógica sistémica. 10.1. Definir la evaluación como parte de un sistema de mejora continua El primer paso para integrar la evaluación a la estrategia institucional es comprenderla no como un evento anual, sino como una herramienta sistémica dentro de un ciclo permanente de diagnóstico, planificación, implementación y retroalimentación. En este marco, los resultados de la evaluación docente se convierten en insumos clave para identificar brechas de desempeño, planificar acciones de desarrollo profesional y ajustar las metas pedagógicas institucionales. 10.2. Alinear los criterios de evaluación con los objetivos estratégicos del PEI El Proyecto Educativo Institucional (PEI) establece las metas de largo plazo de la organización. Si los indicadores de evaluación docente no reflejan esas metas, se corre el riesgo de evaluar en una dirección y gestionar en otra. Por ejemplo, si el PEI prioriza la innovación metodológica, el trabajo colaborativo o la inclusión, estos elementos deben estar claramente presentes y ponderados en las rúbricas e instrumentos de evaluación. 10.3. Utilizar los resultados como base para el desarrollo profesional docente La evaluación deja de ser punitiva cuando sus resultados se utilizan como punto de partida para la mejora. Esto exige que los planes de capacitación institucional respondan directamente a las áreas de mejora detectadas en las evaluaciones. De este modo, se genera una cadena coherente: el PEI orienta la evaluación, la evaluación diagnostica necesidades, y esas necesidades definen el plan de formación anual. 10.4. Vincular la evaluación al sistema de incentivos y reconocimiento La gestión estratégica moderna reconoce que el talento debe ser identificado, promovido y retenido. Incorporar los resultados de la evaluación docente a un sistema transparente de incentivos —ya sea en forma de reconocimientos, oportunidades de liderazgo, bonificaciones o acceso prioritario a formación— fortalece el compromiso institucional y da sentido al proceso evaluativo. Esta lógica meritocrática, bien aplicada, mejora la motivación y eleva el nivel de profesionalización docente. 10.5. Integrar la evaluación a los sistemas de información institucional Las instituciones educativas que operan con sistemas de gestión escolar (ERP, CRM, LMS) deben incluir los resultados de la evaluación docente como parte de sus tableros de control. Esto permite realizar análisis longitudinales, cruzar variables (por ejemplo, desempeño docente vs. resultados de aprendizaje estudiantil), detectar tendencias y tomar decisiones basadas en evidencia. La evaluación deja de ser un documento archivado y se convierte en un dato estratégico. 10.6. Promover la gobernanza participativa del sistema evaluativo Una gestión estratégica efectiva no impone, construye. Involucrar a los docentes en la definición, revisión y mejora del sistema de evaluación fortalece su legitimidad, aumenta la adherencia a las políticas institucionales y genera un sentido compartido de propósito. Esta participación puede articularse a través de comisiones técnicas, encuestas de satisfacción docente, reuniones de retroalimentación y espacios deliberativos. 10.7. Garantizar la coherencia entre evaluación, supervisión y acompañamiento Muchas veces, los equipos de gestión, supervisión y acompañamiento pedagógico operan de manera desarticulada. Mientras uno evalúa, otro observa y otro capacita, sin comunicación entre sí. Esto fragmenta el proceso. La articulación estratégica implica que todos los actores compartan un lenguaje común, utilicen herramientas alineadas y trabajen con metas compartidas derivadas del sistema evaluativo. 10.8. Medir el impacto institucional de las evaluaciones No basta con aplicar evaluaciones; es necesario demostrar que contribuyen al mejoramiento institucional. Esto implica establecer indicadores específicos de impacto (por ejemplo, mejoras en resultados de aprendizaje, disminución de rotación docente, aumento en la satisfacción laboral), monitorear su evolución en el tiempo y ajustar los procesos evaluativos en función de estos datos. 10.9. Convertir la evaluación en una herramienta de liderazgo pedagógico Cuando los líderes institucionales utilizan la evaluación docente como una herramienta para acompañar, orientar, inspirar y guiar al cuerpo docente, se fortalece el sentido pedagógico del proceso. No se trata de controlar, sino de liderar el cambio desde la evidencia. Un director que conoce el nivel de desempeño de sus equipos puede distribuir responsabilidades de forma más justa, liderar procesos de innovación más efectivos y construir una comunidad profesional más cohesionada. 10.10. Conclusión: integrar para transformar La evaluación docente alcanza su máximo potencial cuando se inserta de forma orgánica en la gestión estratégica de la institución. Evaluar no es medir por medir; es comprender para transformar. Esta articulación exige liderazgo técnico, visión organizacional y una convicción profunda de que el mejoramiento institucional comienza por el desarrollo de quienes enseñan. Al conectar evaluación, estrategia y acción, la institución no solo mejora su funcionamiento, sino que se convierte en una organización verdaderamente orientada al aprendizaje. 🧾 Resumen Ejecutivo La evaluación anual del desempeño docente, lejos de ser un mecanismo burocrático, constituye un componente central en la consolidación de una cultura institucional orientada a la excelencia educativa. Este artículo ha explorado en profundidad diez dimensiones críticas del proceso evaluativo, con especial atención a su relación con la gestión directiva, la equidad institucional y el mejoramiento de los aprendizajes. Uno de los principales hallazgos es el rol determinante del liderazgo directivo. El gestor educativo no solo debe diseñar y supervisar la evaluación, sino también encarnar una visión estratégica que la conecte con el desarrollo profesional docente y los objetivos pedagógicos institucionales. Su liderazgo transforma la evaluación de una herramienta de control a un dispositivo de aprendizaje organizacional. La incorporación de rúbricas de evaluación transparentes emerge como un estándar de calidad indispensable. Estas no solo aportan claridad metodológica y legitimidad al proceso, sino que empoderan al docente al brindarle referentes claros sobre qué se espera de su labor. El uso de descriptores observables, escalas coherentes y evidencias concretas reduce la subjetividad, fomenta la autorreflexión y profesionaliza la práctica docente. Garantizar la objetividad e imparcialidad en la evaluación es un imperativo técnico y ético. A través de la estandarización de procesos, formación de evaluadores, uso de fuentes múltiples de información y protocolos de apelación, las instituciones pueden blindar su sistema evaluativo contra sesgos, errores o arbitrariedades que afecten la confianza interna. El coaching pedagógico posterior a la evaluación destaca como un mecanismo clave para traducir los hallazgos en mejoras concretas. Su función es acompañar, contextualizar, personalizar y sostener el cambio en la práctica docente. Esto fortalece la percepción del proceso evaluativo como una oportunidad formativa y no como una amenaza. Asimismo, se demuestra que la evaluación puede —y debe— tener un impacto directo en los aprendizajes estudiantiles. Para ello, es necesario establecer líneas base, articular indicadores de desempeño con resultados de aula, usar datos comparativos, e incorporar la voz de los estudiantes. La evaluación, correctamente implementada, se convierte en una herramienta para elevar la calidad pedagógica. En paralelo, el artículo advierte sobre los desafíos legales y éticos que toda institución debe prever: debido proceso, confidencialidad de los resultados, respeto por la diversidad territorial y uso ético de la información. Estos elementos no son añadidos, sino fundamentos del sistema evaluativo moderno. Una de las recomendaciones clave es la necesidad de contextualizar la evaluación en entornos rurales o vulnerables. Aplicar criterios homogéneos en realidades desiguales refuerza las brechas. La evaluación debe ajustarse a las condiciones reales del territorio, valorar la resiliencia, e incorporar metodologías cualitativas para comprender en profundidad el impacto docente. Detectar y neutralizar sesgos en la evaluación —como el efecto halo, la simpatía, la severidad o el sesgo de contraste— requiere profesionalización, estandarización y auditoría. Cada sesgo no resuelto contamina el sistema y erosiona la confianza institucional. La implementación de rúbricas debe evitar errores comunes: ambigüedad de criterios, falta de contextualización, exceso de indicadores o desconexión con el proyecto educativo institucional. Corregir estos errores convierte a la rúbrica en un contrato pedagógico que alinea expectativas, prácticas y cultura organizacional. Finalmente, se destaca que la evaluación del desempeño debe articularse con la gestión estratégica de la institución. Desde la planificación de la formación docente, la asignación de recursos, los sistemas de incentivos y el monitoreo de impacto, la evaluación debe integrarse como una herramienta de liderazgo institucional y de toma de decisiones basada en evidencia. Beneficios para WORKI 360: Este conjunto de hallazgos y recomendaciones puede ser capitalizado por plataformas como WORKI 360, que ofrecen soluciones integrales de gestión del talento docente. Al incorporar funcionalidades específicas como diseño de rúbricas adaptativas, módulos de coaching post-evaluación, tableros de análisis comparativo, control de sesgos, trazabilidad de evidencias y generación automatizada de informes, WORKI 360 no solo digitaliza el proceso, sino que lo profesionaliza y lo convierte en un verdadero eje de transformación educativa. La transformación institucional comienza con datos confiables, análisis pertinente y decisiones estratégicas. En ese camino, una evaluación docente bien diseñada y bien gestionada es mucho más que un mecanismo técnico: es una declaración de principios sobre lo que la institución valora, espera y promueve en sus profesionales.