Índice del contenido

¿Qué ventajas competitivas ofrece desarrollar aplicaciones que se ejecutan en el servidor para una empresa?

Desarrollar aplicaciones que se ejecutan en el servidor ofrece una amplia gama de ventajas competitivas para cualquier empresa que busque optimizar sus procesos, aumentar su eficiencia operativa y fortalecer su posición en el mercado. A diferencia de las aplicaciones que dependen exclusivamente del dispositivo del usuario, las aplicaciones de servidor centralizan la lógica, los datos y los procesos en un entorno controlado, lo que permite un control más eficiente y seguro de la información crítica de la empresa. En primer lugar, la eficiencia operativa es una ventaja fundamental. Al centralizar la ejecución de la aplicación en servidores robustos y optimizados, las empresas pueden garantizar que todas las operaciones se realicen de manera consistente, independientemente del dispositivo o la ubicación del usuario final. Esto significa que los procesos internos, como la gestión de inventarios, la facturación o el análisis de datos, se realizan más rápido y con menor riesgo de errores humanos o inconsistencias de datos. Para un gerente de TI, esta centralización simplifica la administración de la infraestructura y reduce los costos operativos derivados de mantener múltiples sistemas distribuidos en distintos dispositivos. En segundo lugar, existe una mayor seguridad de la información. Las aplicaciones que se ejecutan en el servidor permiten implementar controles de acceso más estrictos, cifrado de datos y auditorías centralizadas, lo que reduce la exposición de la empresa a riesgos como filtraciones de información o accesos no autorizados. Para los directores de recursos humanos y tecnología, esto es especialmente relevante cuando se manejan datos sensibles de empleados, clientes o proveedores. Además, la centralización facilita la implementación de políticas de respaldo y recuperación ante desastres, asegurando que los datos críticos siempre estén protegidos y disponibles. Otro beneficio estratégico es la escalabilidad. Las aplicaciones de servidor permiten a las empresas crecer sin necesidad de rediseñar toda la arquitectura tecnológica. Por ejemplo, durante picos de demanda, como lanzamientos de productos o campañas de ventas, los servidores pueden escalar sus recursos (CPU, memoria, almacenamiento) para mantener un rendimiento óptimo. Esto ofrece a las organizaciones la flexibilidad de adaptarse rápidamente a cambios del mercado sin interrumpir la operación normal del negocio, lo que constituye una ventaja competitiva frente a empresas que dependen de aplicaciones locales menos flexibles. Asimismo, las aplicaciones de servidor facilitan la integración con otras soluciones empresariales. Desde sistemas ERP y CRM hasta plataformas de análisis de datos, la centralización en el servidor permite que distintas aplicaciones se comuniquen de manera eficiente, compartiendo información y generando insights valiosos para la toma de decisiones estratégicas. Esto es especialmente importante para la gerencia, ya que una integración fluida entre sistemas permite tomar decisiones basadas en datos confiables, incrementando la capacidad de respuesta frente a cambios del mercado o necesidades del cliente. La reducción de costos de mantenimiento es otro aspecto crucial. Al centralizar el desarrollo y la gestión de las aplicaciones en el servidor, las actualizaciones y mejoras se implementan una sola vez, sin necesidad de intervenir en cada dispositivo de los usuarios. Esto no solo disminuye los costos operativos sino que también minimiza la posibilidad de errores por versiones desactualizadas o incompatibles del software. Para los directores de TI, esto representa una optimización del tiempo y recursos destinados al soporte técnico. Además, las aplicaciones de servidor favorecen la coordinación y colaboración entre equipos. En entornos corporativos donde múltiples departamentos dependen de información compartida, tener una aplicación centralizada asegura que todos trabajen con los mismos datos y herramientas, evitando duplicaciones y errores. Esto se traduce en procesos más ágiles y un flujo de trabajo más eficiente, que son elementos clave para aumentar la productividad y la competitividad de la empresa. Finalmente, el desarrollo de aplicaciones que se ejecutan en el servidor permite innovar de manera más rápida. La arquitectura centralizada facilita la implementación de nuevas funcionalidades, inteligencia artificial, análisis de datos avanzado y automatización de procesos sin depender de las limitaciones de hardware o software de los usuarios finales. Esto significa que la empresa puede adaptarse más rápido a las tendencias del mercado, ofreciendo productos y servicios más competitivos y mejorando la experiencia del cliente. En conclusión, desarrollar aplicaciones que se ejecutan en el servidor otorga a las empresas ventajas competitivas significativas, que van desde la eficiencia operativa y la seguridad de datos hasta la escalabilidad, integración de sistemas y reducción de costos de mantenimiento. Para gerentes de TI y recursos humanos, estas ventajas se traducen en un control más sólido de los procesos, mayor productividad de los equipos y capacidad de innovar y adaptarse rápidamente a los desafíos del mercado. En un entorno empresarial donde la agilidad, la seguridad y la eficiencia son factores determinantes, las aplicaciones de servidor se convierten en una herramienta estratégica que impulsa el crecimiento sostenible y la diferenciación competitiva de la empresa.

¿Qué beneficios aporta el uso de microservicios frente a aplicaciones monolíticas?

El enfoque de microservicios ha revolucionado la manera en que las empresas desarrollan aplicaciones que se ejecutan en el servidor, ofreciendo una alternativa mucho más flexible, escalable y eficiente frente a las aplicaciones monolíticas tradicionales. Para los directores de tecnología y gerentes de recursos humanos, comprender los beneficios de esta arquitectura es crucial, ya que impacta directamente en la capacidad de la organización para adaptarse al cambio, mejorar la productividad de los equipos y optimizar los procesos empresariales. En primer lugar, uno de los beneficios más evidentes es la escalabilidad independiente de los componentes. Mientras que las aplicaciones monolíticas funcionan como un bloque único, los microservicios dividen la aplicación en múltiples servicios independientes que pueden desarrollarse, desplegarse y escalarse por separado. Esto significa que si una parte del sistema experimenta una demanda creciente, como un módulo de procesamiento de pagos o un servicio de análisis de datos, únicamente ese microservicio puede recibir recursos adicionales, sin necesidad de escalar toda la aplicación. Para la gerencia, esta característica se traduce en un uso más eficiente de los recursos, optimización de costos y mayor capacidad de respuesta ante picos de demanda. Otro beneficio fundamental es la agilidad en el desarrollo y la implementación. Los microservicios permiten a los equipos trabajar de manera autónoma en distintas partes de la aplicación, lo que acelera la entrega de nuevas funcionalidades y reduce los tiempos de desarrollo. A diferencia de los monolitos, donde una modificación puede requerir revisar y actualizar toda la base de código, los microservicios facilitan la integración continua y el despliegue continuo (CI/CD), garantizando que los cambios se implementen de manera rápida y segura. Esto es especialmente relevante para empresas que buscan innovar constantemente y ofrecer nuevas soluciones a sus clientes sin interrumpir la operación existente. La resiliencia y la tolerancia a fallos son otro punto crítico. En aplicaciones monolíticas, un fallo en un módulo puede afectar a toda la aplicación, provocando interrupciones significativas. En cambio, los microservicios aíslan los errores: si un servicio falla, los demás pueden continuar operando normalmente, lo que reduce el impacto en la operación general de la empresa. Para los gerentes de TI, esto significa una menor vulnerabilidad ante fallos críticos y una mayor continuidad del negocio, factores esenciales para mantener la confianza de clientes y socios estratégicos. Además, los microservicios facilitan la adopción de tecnologías heterogéneas. Cada microservicio puede desarrollarse utilizando el lenguaje o framework más adecuado para su función específica, sin estar limitado por la tecnología utilizada en otros servicios. Esto permite a la empresa incorporar innovaciones tecnológicas más rápidamente y aprovechar herramientas especializadas que mejoren la eficiencia de cada componente del sistema. Desde un punto de vista gerencial, esta flexibilidad tecnológica contribuye a mantener la competitividad y a atraer talento especializado, ya que los desarrolladores pueden trabajar con tecnologías modernas y relevantes para sus áreas de expertise. Otro beneficio relevante es la facilidad de mantenimiento y actualización. En un entorno de microservicios, los equipos pueden actualizar o reemplazar un servicio sin afectar a los demás. Esto reduce los riesgos asociados a los cambios, disminuye el tiempo de inactividad y permite a las organizaciones mantener sus aplicaciones siempre actualizadas y seguras. Para la dirección de recursos humanos, esto también significa que los equipos pueden organizarse en unidades más pequeñas y especializadas, fomentando un ambiente de trabajo colaborativo y eficiente que mejora la productividad y reduce la complejidad en la gestión de proyectos. La mejora en la integración con otros sistemas y servicios es otro beneficio estratégico. Los microservicios suelen comunicarse mediante APIs estandarizadas, lo que facilita la conexión con sistemas internos y externos, plataformas en la nube, servicios de terceros y herramientas analíticas. Esto abre la puerta a nuevas oportunidades de colaboración, análisis de datos más avanzados y creación de productos o servicios innovadores que aprovechen información de distintas fuentes, todo sin comprometer la estabilidad del sistema principal. Finalmente, los microservicios apoyan la cultura de innovación continua y la adaptabilidad al mercado. Las empresas que adoptan esta arquitectura pueden experimentar y lanzar nuevas funcionalidades de manera más ágil, medir su impacto y ajustar sus estrategias sin riesgo de afectar toda la operación. Esto representa un factor de diferenciación competitivo, ya que permite a la empresa adaptarse rápidamente a las demandas del mercado, implementar mejoras basadas en datos reales y ofrecer soluciones más personalizadas a clientes y colaboradores. En conclusión, los microservicios ofrecen beneficios significativos frente a las aplicaciones monolíticas, que incluyen escalabilidad independiente, mayor resiliencia, agilidad en el desarrollo, flexibilidad tecnológica, facilidad de mantenimiento, integración eficiente con otros sistemas y una capacidad superior para innovar y adaptarse al mercado. Para la gerencia de TI y recursos humanos, adoptar una arquitectura de microservicios no solo optimiza los recursos y reduce riesgos, sino que también mejora la colaboración, la productividad y la capacidad estratégica de la empresa, convirtiéndose en un componente esencial para mantener la competitividad y asegurar el crecimiento sostenible en un entorno empresarial dinámico y altamente tecnológico.

¿Cómo la nube ha transformado el desarrollo de aplicaciones de servidor?

La adopción de la nube ha revolucionado el desarrollo y la operación de aplicaciones que se ejecutan en el servidor, redefiniendo la manera en que las empresas gestionan su infraestructura tecnológica, optimizan procesos y responden a las demandas del mercado. Para los directores de tecnología y gerentes de recursos humanos, comprender esta transformación es fundamental, ya que impacta directamente en la eficiencia, escalabilidad y competitividad de la organización. Uno de los cambios más significativos es la eliminación de barreras físicas y la reducción de costos de infraestructura. Antes de la nube, las empresas debían invertir en servidores físicos, mantenimiento de hardware, energía y espacio físico, lo que implicaba costos elevados y rigidez en la capacidad de escalar. Con la nube, las organizaciones pueden acceder a servidores virtuales de alta capacidad bajo demanda, pagando solo por los recursos que utilizan. Esto permite a la empresa asignar su presupuesto de manera más eficiente, invertir en innovación y reducir los riesgos financieros asociados a la infraestructura tecnológica tradicional. La escalabilidad dinámica es otra ventaja clave. Las aplicaciones en la nube pueden ajustar automáticamente los recursos disponibles según la demanda, lo que significa que un aumento repentino de tráfico, como durante campañas de marketing o lanzamientos de productos, no afecta la experiencia del usuario. Para los gerentes de TI, esto representa una enorme ventaja estratégica, ya que elimina la necesidad de sobredimensionar servidores de manera preventiva y garantiza que los sistemas mantengan un rendimiento óptimo en cualquier circunstancia. Además, la nube ha permitido la implementación más rápida de aplicaciones y servicios. Los entornos de desarrollo en la nube proporcionan herramientas integradas, plataformas de despliegue continuo y entornos preconfigurados que aceleran el ciclo de desarrollo. Los equipos de desarrollo pueden crear, probar y desplegar aplicaciones sin la necesidad de configurar servidores físicos o instalar múltiples dependencias manualmente. Esto no solo mejora la eficiencia de los equipos, sino que también acorta el tiempo que transcurre desde la concepción de una idea hasta su implementación efectiva, favoreciendo la innovación constante. La flexibilidad tecnológica es otro factor transformador. La nube permite que cada aplicación utilice el conjunto de tecnologías más adecuado para sus necesidades, desde bases de datos relacionales hasta sistemas NoSQL, contenedores Docker, microservicios o inteligencia artificial. Para la gerencia, esto representa una ventaja competitiva, ya que facilita la adopción de tecnologías modernas y permite experimentar con soluciones innovadoras sin comprometer la estabilidad del sistema principal. La colaboración y accesibilidad también han mejorado significativamente gracias a la nube. Los equipos distribuidos geográficamente pueden acceder a los mismos entornos de desarrollo y recursos de servidor en tiempo real, lo que promueve la colaboración y reduce las barreras operativas. Esto es especialmente relevante para gerentes de recursos humanos que buscan fomentar equipos altamente productivos y coordinados, incluso en entornos híbridos o remotos, sin que la distancia afecte la eficiencia de los procesos. En términos de seguridad y cumplimiento, la nube ha proporcionado nuevas herramientas y protocolos para proteger los datos y garantizar la conformidad con normativas legales y estándares internacionales. Los proveedores de servicios en la nube suelen implementar cifrado avanzado, auditorías automáticas, monitoreo continuo y respaldo de datos, reduciendo la exposición a riesgos de seguridad que pueden afectar la reputación y operación de la empresa. Para los directores de TI, esto significa que gran parte de la responsabilidad de seguridad se comparte con el proveedor, lo que permite enfocar los recursos internos en la innovación y mejora de procesos. Otro cambio significativo es la agilidad en la integración y modernización de sistemas. La nube facilita la conexión con APIs externas, plataformas de análisis de datos, herramientas de inteligencia artificial y servicios de terceros. Esto permite que las empresas desarrollen aplicaciones más inteligentes y conectadas, que pueden evolucionar continuamente para satisfacer las demandas de clientes y mercados. Para los gerentes, esta capacidad de integración se traduce en mayor competitividad y en la posibilidad de ofrecer servicios más personalizados y eficientes. Finalmente, la nube ha impulsado una cultura de innovación continua y experimentación controlada. La facilidad para desplegar entornos de prueba y producción, junto con la posibilidad de escalar recursos según sea necesario, permite a las empresas probar nuevas ideas, analizar resultados y ajustar estrategias rápidamente. Esto se traduce en una ventaja estratégica significativa frente a competidores que aún dependen de infraestructura física tradicional y procesos de implementación más lentos. En conclusión, la nube ha transformado el desarrollo de aplicaciones de servidor al ofrecer escalabilidad dinámica, reducción de costos, agilidad en el desarrollo, flexibilidad tecnológica, mejora en la colaboración, seguridad avanzada, integración eficiente y una cultura de innovación continua. Para los directores de tecnología y gerentes de recursos humanos, estas ventajas representan oportunidades concretas para optimizar recursos, mejorar la productividad de los equipos, adaptarse rápidamente a cambios del mercado y mantener una posición competitiva sólida en un entorno empresarial cada vez más dinámico y digitalizado.

¿Cómo implementar sistemas de respaldo y recuperación eficientes?

La implementación de sistemas de respaldo y recuperación eficientes es un elemento crítico en el desarrollo de aplicaciones que se ejecutan en el servidor. Para las empresas, especialmente aquellas que manejan información sensible de clientes, datos financieros o registros de recursos humanos, un plan de respaldo bien estructurado no es solo una medida de seguridad, sino un componente estratégico que garantiza la continuidad del negocio y la resiliencia frente a incidentes. Los directores de tecnología y gerentes de recursos humanos deben comprender que una estrategia robusta de backup y recuperación puede marcar la diferencia entre una recuperación rápida ante fallos y pérdidas significativas de datos que afecten la operación y la reputación de la empresa. El primer paso para implementar un sistema eficiente es identificar y clasificar los datos críticos. No todos los datos tienen el mismo nivel de importancia para la empresa. Por ejemplo, la información de clientes, transacciones financieras, historiales médicos o registros de empleados requieren una protección más estricta que archivos temporales o registros de sistemas no críticos. Clasificar los datos permite establecer políticas de respaldo diferenciadas, asignando más frecuencia y seguridad a la información crítica y optimizando los recursos del sistema de backup. Una vez identificados los datos clave, es esencial definir la frecuencia de respaldo adecuada. Dependiendo del tipo de información y de la criticidad de los procesos, las copias de seguridad pueden ser diarias, semanales o incluso en tiempo real mediante técnicas de replicación continua. Por ejemplo, en un entorno financiero, perder incluso unas horas de transacciones podría tener un impacto económico y legal considerable. Para gerentes de TI, establecer la frecuencia correcta implica equilibrar la seguridad con la eficiencia de los recursos y garantizar que las operaciones del negocio no se vean afectadas por procesos de respaldo. Otro aspecto fundamental es elegir la estrategia de respaldo más apropiada. Entre las opciones más comunes se encuentran: respaldo completo, incremental y diferencial. Un respaldo completo copia todos los datos del sistema en cada ejecución, ofreciendo una recuperación más rápida pero consumiendo más espacio y recursos. El respaldo incremental solo guarda los cambios realizados desde la última copia, lo que optimiza el almacenamiento pero puede requerir más tiempo para la recuperación. El respaldo diferencial guarda los cambios desde el último respaldo completo, balanceando eficiencia y rapidez en la restauración. La elección de la estrategia depende de la naturaleza de la empresa, la criticidad de los datos y los recursos disponibles, y debe ser decidida por el equipo de TI en coordinación con la dirección estratégica. La selección de medios y ubicaciones de almacenamiento es otro factor determinante. Las empresas modernas suelen combinar almacenamiento local en servidores internos con almacenamiento en la nube, generando redundancia y minimizando riesgos. El almacenamiento en la nube ofrece ventajas significativas, como accesibilidad desde cualquier lugar, replicación automática y alta disponibilidad, mientras que el almacenamiento local permite una recuperación más rápida ante fallos menores. La combinación de ambos, conocida como estrategia híbrida, garantiza que la empresa pueda recuperarse de desastres graves sin comprometer la continuidad del negocio. La automatización de los procesos de respaldo es clave para minimizar errores humanos y asegurar la consistencia de las copias de seguridad. La configuración de tareas automáticas, alertas en caso de fallos y monitoreo continuo permite que los equipos de TI mantengan la integridad de los datos sin la necesidad de intervención constante. Esto libera recursos y tiempo para enfocarse en otros proyectos estratégicos, aumentando la eficiencia operativa y reduciendo riesgos asociados a errores manuales. Un sistema eficiente también requiere pruebas periódicas de recuperación. No basta con crear respaldos; es imprescindible verificar que los datos puedan restaurarse de manera completa y funcional. Las pruebas de recuperación simulan escenarios de pérdida de datos o fallos del servidor, permitiendo identificar posibles fallas en la estrategia de backup y corregirlas antes de que un incidente real ocurra. Para la gerencia, estas pruebas ofrecen confianza de que la empresa puede mantener sus operaciones incluso ante situaciones críticas. La seguridad de los respaldos es otro aspecto crítico. Los datos respaldados deben estar cifrados y protegidos contra accesos no autorizados. Esto es especialmente relevante para información sensible de empleados, clientes o transacciones financieras. La implementación de controles de acceso basados en roles, autenticación multifactor y monitoreo continuo asegura que la integridad y confidencialidad de la información se mantengan en todo momento, reduciendo riesgos legales y reputacionales. Finalmente, la implementación de sistemas de respaldo y recuperación eficientes permite a la empresa mantener la continuidad del negocio y la confianza de clientes y colaboradores. Un plan sólido garantiza que, ante fallos de hardware, ciberataques o desastres naturales, los datos críticos puedan restaurarse rápidamente, minimizando interrupciones operativas. Para los directores de TI y gerentes de recursos humanos, esto representa no solo un ahorro económico al evitar pérdidas de información, sino también un fortalecimiento de la imagen de la empresa como organización confiable y preparada para enfrentar contingencias. En conclusión, implementar sistemas de respaldo y recuperación eficientes requiere un enfoque estratégico que incluya la clasificación de datos, definición de frecuencia y estrategia de respaldo, selección de medios y ubicaciones, automatización de procesos, pruebas periódicas de recuperación y medidas de seguridad robustas. Para la gerencia, estos sistemas no solo protegen la información crítica, sino que aseguran la continuidad operativa, optimizan recursos y fortalecen la posición competitiva de la empresa en un entorno donde la resiliencia tecnológica es un factor determinante para el éxito y la sostenibilidad del negocio.

¿Qué métricas KPIs son clave para evaluar aplicaciones backend?

Evaluar el desempeño de aplicaciones que se ejecutan en el servidor es fundamental para garantizar la eficiencia, escalabilidad y confiabilidad de los sistemas empresariales. Para directores de tecnología y gerentes de recursos humanos, el seguimiento de métricas clave o KPIs (Key Performance Indicators) permite tomar decisiones estratégicas informadas, optimizar recursos, mejorar la experiencia del usuario y asegurar la continuidad de los procesos críticos. Conocer cuáles KPIs son más relevantes ayuda a priorizar acciones y a alinear los objetivos tecnológicos con los objetivos de negocio de la empresa. Uno de los KPIs más importantes es el tiempo de respuesta del servidor. Esta métrica mide cuánto tarda la aplicación en procesar una solicitud y devolver una respuesta al cliente o a otro sistema. Un tiempo de respuesta bajo es crucial para mantener la satisfacción del usuario final, ya que retrasos prolongados pueden afectar la productividad de los equipos internos o la percepción del cliente. Para un gerente de TI, monitorear esta métrica permite identificar cuellos de botella, optimizar consultas a la base de datos y ajustar la arquitectura del servidor para mejorar la eficiencia operativa. El número de solicitudes procesadas por segundo es otra métrica crítica. Este KPI refleja la capacidad de la aplicación backend para manejar cargas de trabajo y soportar picos de tráfico. En entornos empresariales donde el volumen de transacciones es alto, como en comercio electrónico, sistemas financieros o plataformas de servicios digitales, esta métrica ayuda a dimensionar correctamente los recursos del servidor y a planificar estrategias de escalabilidad horizontal o vertical. Además, permite a los directores de tecnología anticiparse a posibles sobrecargas y diseñar estrategias de balanceo de carga efectivas. La tasa de errores o fallos es también un indicador esencial. Esta métrica mide la cantidad de solicitudes que no se procesan correctamente debido a fallos en el servidor, errores de código o problemas de comunicación con otros sistemas. Una tasa de errores elevada puede indicar problemas de estabilidad, fallas en la infraestructura o deficiencias en el diseño de la aplicación. Para los gerentes, conocer esta métrica permite implementar planes de mejora continua, asignar recursos a la resolución de incidentes y reducir el impacto de fallos en la operación del negocio. El tiempo de actividad o uptime del servidor es otro KPI crucial. Este indicador refleja el porcentaje de tiempo en que la aplicación está disponible y funcionando correctamente. Un uptime cercano al 100% es fundamental para garantizar la continuidad de los procesos empresariales, especialmente en servicios críticos como sistemas de pagos, gestión de recursos humanos o plataformas de atención al cliente. Monitorear esta métrica permite a la gerencia evaluar la efectividad de la infraestructura, la resiliencia de los sistemas y la necesidad de implementar redundancia o mecanismos de recuperación ante fallos. El uso de recursos del servidor, que incluye CPU, memoria, almacenamiento y ancho de banda, es una métrica esencial para optimizar la eficiencia operativa. El seguimiento de estos indicadores permite detectar sobrecargas, identificar servicios que consumen recursos de manera excesiva y ajustar la arquitectura de la aplicación para mejorar el rendimiento. Para los directores de TI, esta información es valiosa para planificar la expansión de infraestructura, optimizar costos y garantizar que los servicios críticos funcionen sin interrupciones. La latencia de la base de datos también es un KPI clave. Dado que muchas aplicaciones backend dependen de consultas a bases de datos para procesar información, medir el tiempo que tardan estas consultas en completarse permite identificar problemas de diseño, optimizar índices o aplicar técnicas de caching. Un desempeño eficiente en la base de datos se traduce en tiempos de respuesta más rápidos y mayor capacidad de procesamiento, lo que impacta directamente en la productividad de los equipos internos y la experiencia del cliente. Otro KPI estratégico es el tiempo medio entre fallos (MTBF) y el tiempo medio de recuperación (MTTR). Estas métricas reflejan la confiabilidad de la aplicación y la rapidez con la que se puede restaurar la operación después de un fallo. Un MTBF alto y un MTTR bajo son indicadores de un sistema robusto, bien mantenido y con procedimientos efectivos de respaldo y recuperación. Para la gerencia, estos indicadores son fundamentales para evaluar riesgos operativos, planificar estrategias de mantenimiento preventivo y asegurar la resiliencia de los sistemas. La escabilidad y elasticidad de la aplicación también puede medirse mediante KPIs relacionados con la capacidad de adaptación ante cambios de carga. Indicadores como la capacidad máxima de usuarios concurrentes sin degradación de rendimiento permiten a los directores de TI evaluar si la infraestructura y la arquitectura de la aplicación pueden soportar crecimiento empresarial o picos estacionales de demanda. Finalmente, la satisfacción del usuario final puede considerarse un KPI indirecto pero esencial. Aunque no mide directamente el desempeño técnico del backend, la experiencia de los usuarios refleja la eficiencia de los sistemas, la rapidez de respuesta y la confiabilidad de la aplicación. Encuestas, tiempos de resolución de incidencias y métricas de interacción permiten a la gerencia correlacionar datos técnicos con la percepción del usuario, generando información estratégica para mejorar tanto la tecnología como los procesos internos. En conclusión, evaluar aplicaciones backend requiere un conjunto integral de KPIs que incluya tiempo de respuesta, solicitudes procesadas por segundo, tasa de errores, tiempo de actividad, uso de recursos, latencia de base de datos, MTBF, MTTR, escalabilidad y satisfacción del usuario. Para los directores de tecnología y gerentes de recursos humanos, monitorear estos indicadores no solo optimiza la operación y el rendimiento de los sistemas, sino que también permite una gestión proactiva, mejora la toma de decisiones estratégicas y asegura que la empresa mantenga su competitividad y capacidad de innovación en un entorno empresarial exigente y dinámico.

¿Qué ventajas ofrece la arquitectura sin servidor (serverless) frente a la tradicional?

La arquitectura sin servidor, o serverless, ha transformado la manera en que las empresas desarrollan y gestionan aplicaciones que se ejecutan en el servidor, ofreciendo ventajas estratégicas frente a los modelos tradicionales basados en servidores dedicados o virtualizados. Para directores de tecnología y gerentes de recursos humanos, comprender los beneficios de esta arquitectura es clave, ya que impacta en la eficiencia operativa, la reducción de costos y la capacidad de innovación de la organización. Uno de los beneficios más relevantes es la reducción significativa de costos operativos. En la arquitectura tradicional, las empresas deben invertir en servidores físicos o virtuales, su mantenimiento, consumo energético y personal especializado para gestionarlos. En un modelo serverless, la infraestructura es completamente gestionada por el proveedor de la nube, y la empresa solo paga por el tiempo de ejecución real de las funciones y por los recursos utilizados. Esto elimina gastos innecesarios y permite una asignación más eficiente del presupuesto hacia actividades estratégicas, como innovación, desarrollo de productos o mejora de servicios al cliente. Otro aspecto fundamental es la escalabilidad automática. La arquitectura serverless ajusta dinámicamente los recursos en función de la demanda de la aplicación, sin necesidad de intervención manual. Esto significa que durante picos de tráfico, como promociones de ventas o eventos especiales, las funciones pueden escalar instantáneamente para atender a todos los usuarios sin degradar el rendimiento. Para los gerentes de TI, esto representa una ventaja competitiva, ya que garantiza que la operación continúe de manera fluida y eficiente sin necesidad de planificar sobrecargas o ampliar infraestructura de forma anticipada. La agilidad en el desarrollo y despliegue es otro beneficio clave. Las funciones serverless permiten a los desarrolladores centrarse exclusivamente en la lógica de negocio y el código de la aplicación, sin preocuparse por la configuración, el mantenimiento o la disponibilidad de los servidores subyacentes. Esto acelera los ciclos de desarrollo, facilita la implementación continua y permite que los equipos entreguen nuevas funcionalidades al mercado en menor tiempo. Para la gerencia, esta agilidad se traduce en una capacidad superior de innovación y adaptación rápida frente a las demandas del mercado. La resiliencia y tolerancia a fallos es también un aspecto crítico. En modelos serverless, la responsabilidad de la disponibilidad y la redundancia recae en el proveedor de la nube, que asegura que las funciones se ejecuten de manera confiable y se distribuyan geográficamente para minimizar el riesgo de interrupciones. Esto reduce la necesidad de implementar costosas soluciones de alta disponibilidad y permite que los equipos de TI se concentren en optimizar la experiencia del usuario y los procesos internos de la empresa. Además, la arquitectura sin servidor permite una optimización de recursos y eficiencia energética. Al ejecutarse únicamente cuando se necesita, las funciones serverless evitan el consumo continuo de recursos que caracteriza a los servidores tradicionales, contribuyendo a una operación más eficiente y sostenible. Esto no solo tiene un impacto económico, sino que también alinea a la empresa con prácticas de sostenibilidad, un valor cada vez más importante en la reputación corporativa y en la gestión de recursos humanos. La facilidad de integración con servicios en la nube y APIs es otro beneficio estratégico. Las funciones serverless pueden conectarse fácilmente con bases de datos, sistemas de almacenamiento, servicios de mensajería, análisis de datos y otras aplicaciones, creando ecosistemas flexibles y adaptativos. Esto permite a las empresas construir aplicaciones más inteligentes, automatizar procesos y ofrecer servicios personalizados sin necesidad de gestionar complejas arquitecturas monolíticas. Otro aspecto a destacar es la mejora en la seguridad y el cumplimiento normativo. Dado que el proveedor de la nube gestiona la infraestructura subyacente, las responsabilidades de seguridad física y de mantenimiento del servidor se trasladan al proveedor, mientras que la empresa puede concentrarse en la seguridad de la lógica de negocio y los datos. Esto simplifica la gestión de riesgos, permite un cumplimiento más eficiente de regulaciones y normativas, y garantiza que la información crítica de clientes y empleados se mantenga protegida. Finalmente, la arquitectura serverless fomenta una cultura de innovación y experimentación. La facilidad de desplegar nuevas funciones sin invertir en infraestructura permite a las empresas probar ideas, iterar rápidamente y lanzar nuevos productos o servicios de manera ágil. Para los gerentes de recursos humanos y TI, esto significa que los equipos pueden trabajar de manera más creativa, eficiente y colaborativa, generando valor tangible para la empresa y fortaleciendo su ventaja competitiva. En conclusión, la arquitectura sin servidor ofrece ventajas significativas frente a los modelos tradicionales, incluyendo reducción de costos, escalabilidad automática, agilidad en desarrollo y despliegue, resiliencia, eficiencia de recursos, facilidad de integración, seguridad reforzada y fomento de la innovación. Para los directores de tecnología y gerentes de recursos humanos, adoptar un enfoque serverless no solo optimiza la operación de las aplicaciones backend, sino que también permite a la empresa responder rápidamente a cambios del mercado, mejorar la experiencia del usuario y consolidar una posición competitiva sólida y sostenible en el entorno empresarial digitalizado actual.

¿Qué estrategias de balanceo de carga mejoran la disponibilidad?

El balanceo de carga es un componente crítico en aplicaciones que se ejecutan en el servidor, especialmente en entornos empresariales donde la disponibilidad, la resiliencia y el rendimiento son factores estratégicos. Para directores de tecnología y gerentes de recursos humanos, entender y aplicar las estrategias de balanceo de carga correctas no solo asegura que los sistemas operen de manera continua, sino que también optimiza la experiencia del usuario, reduce riesgos operativos y fortalece la competitividad de la empresa. En primer lugar, una de las estrategias fundamentales es el balanceo de carga basado en round-robin. Esta técnica distribuye las solicitudes de manera secuencial entre los servidores disponibles, garantizando que todos los nodos compartan la carga de manera equitativa. Para entornos con tráfico relativamente uniforme y servidores homogéneos, el round-robin es simple de implementar y eficiente, asegurando que ningún servidor se sobrecargue mientras otros permanecen infrautilizados. Para la gerencia, esto se traduce en una mayor estabilidad operativa y en la capacidad de atender a todos los usuarios de manera consistente. Otra estrategia es el balanceo basado en el rendimiento o el uso de recursos. En este enfoque, las solicitudes se envían al servidor que actualmente tenga menor carga de CPU, memoria o ancho de banda, lo que optimiza el rendimiento general del sistema. Esta técnica es especialmente útil en aplicaciones críticas con variabilidad en la carga de trabajo, como sistemas financieros, plataformas de comercio electrónico o servicios de atención al cliente. Para los directores de TI, permite un uso más eficiente de los recursos y reduce el riesgo de que un servidor saturado afecte la disponibilidad de la aplicación. El balanceo de carga geográfico es otra estrategia estratégica, particularmente relevante para empresas con presencia global. Esta técnica distribuye las solicitudes según la ubicación geográfica del usuario, enviando la solicitud al servidor más cercano o al menos cargado. Esto no solo reduce la latencia y mejora la velocidad de respuesta, sino que también contribuye a una experiencia de usuario más consistente y satisfactoria. Para los gerentes de recursos humanos y tecnología, esto significa que los equipos pueden ofrecer servicios globales sin comprometer la calidad, optimizando la productividad y la percepción del cliente. El balanceo de carga con alta disponibilidad (HA) es esencial para garantizar la continuidad del negocio. Este enfoque combina múltiples estrategias de balanceo con redundancia y conmutación automática ante fallos. Si un servidor deja de estar disponible por mantenimiento o falla inesperada, el tráfico se redirige automáticamente a otros servidores activos, minimizando la interrupción del servicio. Para la gerencia, esto representa un respaldo estratégico que protege la reputación de la empresa y asegura que las operaciones críticas continúen sin interrupciones. Otra estrategia avanzada es el balanceo basado en contenido o en reglas inteligentes. Aquí, las solicitudes se distribuyen según el tipo de contenido, la prioridad del usuario o las políticas de negocio. Por ejemplo, un sistema puede priorizar transacciones financieras sobre consultas de información general o enviar solicitudes complejas a servidores especializados en procesamiento intensivo. Esta estrategia permite optimizar la eficiencia y garantizar que las funciones críticas reciban la atención adecuada. Para los directores de TI, esto significa un control más preciso sobre el comportamiento de la aplicación y la capacidad de alinear la operación tecnológica con los objetivos estratégicos de la empresa. El uso de balanceadores de carga en la nube es otra tendencia que ofrece ventajas significativas. Los proveedores de servicios en la nube permiten implementar balanceadores de carga elásticos que se adaptan automáticamente a los cambios en la demanda, integran mecanismos de seguridad como firewall y cifrado, y proporcionan monitoreo en tiempo real. Esto reduce la carga operativa interna, permite una escalabilidad dinámica y garantiza que los sistemas críticos mantengan un rendimiento óptimo, incluso durante picos de tráfico inesperados. Finalmente, las mejores prácticas de monitoreo y ajuste continuo complementan cualquier estrategia de balanceo de carga. Es vital medir constantemente métricas como la latencia, el tiempo de respuesta, el uso de recursos y la tasa de errores para ajustar la configuración de los balanceadores de manera proactiva. Esto asegura que el sistema continúe operando de manera óptima, previniendo saturaciones y optimizando la experiencia del usuario. Para la gerencia, esto representa un enfoque estratégico que combina tecnología y análisis de datos para mejorar la disponibilidad y confiabilidad de la empresa. En conclusión, implementar estrategias de balanceo de carga efectivas —incluyendo round-robin, balanceo basado en recursos, geográfico, alta disponibilidad, basado en reglas y en la nube— mejora significativamente la disponibilidad, la resiliencia y el rendimiento de las aplicaciones de servidor. Para los directores de tecnología y gerentes de recursos humanos, estas estrategias no solo optimizan la operación de los sistemas, sino que también fortalecen la competitividad de la empresa, protegen la continuidad del negocio y garantizan una experiencia de usuario consistente y de alta calidad en un entorno empresarial cada vez más digital y exigente.

¿Cómo integrar APIs externas de manera segura en aplicaciones de servidor?

La integración de APIs externas en aplicaciones que se ejecutan en el servidor se ha convertido en un componente estratégico para las empresas que buscan ampliar funcionalidades, automatizar procesos y ofrecer servicios más completos a clientes y colaboradores. Para directores de tecnología y gerentes de recursos humanos, entender cómo realizar estas integraciones de manera segura es fundamental, ya que impacta directamente en la protección de datos, la continuidad operativa y la eficiencia de los sistemas empresariales. El primer paso para una integración segura es evaluar la confiabilidad y reputación del proveedor de la API. No todas las APIs externas cumplen con estándares de seguridad o disponibilidad adecuados. Es esencial revisar la documentación, certificaciones de seguridad, historial de incidentes y políticas de privacidad del proveedor. Para la gerencia, esta evaluación es crucial, ya que integrar una API de un proveedor poco confiable podría exponer datos sensibles de clientes o empleados, afectando la reputación y la operación de la empresa. Una segunda medida clave es autenticación y autorización robusta. Las APIs externas deben estar protegidas mediante mecanismos como tokens de acceso, OAuth 2.0 o API keys, que controlan quién puede acceder a los datos y a qué recursos específicos. Esto garantiza que solo aplicaciones autorizadas puedan interactuar con la API, reduciendo riesgos de accesos no autorizados. Para los directores de TI, implementar controles de autenticación seguros protege la integridad de los sistemas y asegura el cumplimiento de normativas de privacidad y seguridad. El cifrado de datos en tránsito y en reposo es otro aspecto crítico. Toda comunicación entre la aplicación y la API debe realizarse mediante protocolos seguros, como HTTPS o TLS, para evitar interceptaciones y ataques de intermediarios (man-in-the-middle). Además, cualquier información sensible almacenada temporalmente durante la integración debe cifrarse para protegerla contra accesos indebidos. La gerencia debe comprender que estas medidas no solo previenen fugas de información, sino que también fortalecen la confianza de clientes y socios en la seguridad de los sistemas corporativos. El control de límites y políticas de uso es otra estrategia esencial. Muchas APIs externas tienen restricciones de tráfico, llamadas por minuto o volumen de datos. Implementar mecanismos de rate limiting y monitoreo asegura que la aplicación no exceda estos límites, evitando bloqueos, sobrecargas del sistema o costos inesperados. Para los gerentes, este control contribuye a la estabilidad de la operación, al cumplimiento de contratos con proveedores y a la previsibilidad de costos. La validación y filtrado de datos que se reciben de la API también es fundamental. No se puede asumir que todos los datos externos sean correctos o seguros. Las aplicaciones de servidor deben implementar validaciones para asegurar que los datos cumplan con el formato esperado y no contengan información maliciosa, como inyecciones de código o scripts dañinos. Esto protege tanto la integridad de la base de datos como la seguridad de los usuarios finales, asegurando que la aplicación funcione de manera confiable y sin interrupciones. El monitoreo y registro de transacciones es otro componente estratégico. Registrar todas las interacciones con APIs externas permite detectar anomalías, identificar fallos y analizar patrones de uso. Esta práctica es esencial para la prevención de incidentes y para la resolución rápida de problemas, proporcionando a la gerencia visibilidad completa del comportamiento de las integraciones y facilitando decisiones informadas sobre mejoras o ajustes necesarios. El uso de entornos de prueba y sandbox antes de la integración en producción es una práctica recomendada. Estos entornos permiten simular interacciones con la API sin afectar los sistemas reales, probando la compatibilidad, el rendimiento y la seguridad de la integración. Para los directores de TI, esto reduce riesgos y garantiza que la integración se realice de manera controlada, evitando interrupciones en los servicios críticos de la empresa. Finalmente, es importante establecer planes de contingencia y recuperación ante fallos de la API externa. Esto incluye mecanismos de retry, almacenamiento temporal de datos, fallback a servicios internos o notificaciones automáticas a los equipos de soporte. Para la gerencia, estos planes aseguran que la operación del negocio no se vea afectada por problemas externos y que los procesos críticos puedan continuar incluso ante fallos temporales. En conclusión, integrar APIs externas de manera segura en aplicaciones de servidor requiere un enfoque integral que incluya evaluación de proveedores, autenticación y autorización robustas, cifrado de datos, control de límites, validación de datos, monitoreo, pruebas en entornos de sandbox y planes de contingencia. Para directores de tecnología y gerentes de recursos humanos, estas prácticas no solo protegen los sistemas y datos críticos, sino que también permiten aprovechar el valor estratégico de las APIs externas, mejorando la eficiencia operativa, la innovación y la competitividad de la empresa en un entorno digital cada vez más conectado y exigente.

¿Qué herramientas de automatización ayudan a la implementación de servidores?

La automatización en la implementación de servidores se ha convertido en un pilar estratégico para empresas que buscan eficiencia, consistencia y escalabilidad en sus aplicaciones que se ejecutan en el servidor. Para directores de tecnología y gerentes de recursos humanos, la adopción de herramientas de automatización no solo optimiza los procesos de TI, sino que también fortalece la productividad de los equipos, reduce errores humanos y asegura la continuidad operativa, aspectos fundamentales en entornos empresariales competitivos y dinámicos. Uno de los beneficios principales de estas herramientas es la reducción de errores humanos y la mejora de la consistencia. La configuración manual de servidores es propensa a fallos, ya que incluso pequeños errores en comandos o parámetros pueden generar problemas de seguridad o interrupciones de servicio. Herramientas de automatización como Ansible, Chef o Puppet permiten definir la infraestructura como código, garantizando que cada servidor se configure de manera idéntica y cumpla con los estándares corporativos. Para la gerencia, esto se traduce en una mayor confiabilidad operativa y en la disminución de incidentes relacionados con configuraciones incorrectas. Otra ventaja clave es la agilidad en el despliegue de infraestructura. Con la automatización, la creación, configuración y despliegue de servidores puede realizarse en minutos, en lugar de días, lo que acelera el lanzamiento de nuevas aplicaciones o servicios. Plataformas como Terraform permiten diseñar y desplegar entornos completos en la nube de manera repetible y escalable. Para los directores de TI, esto significa poder responder rápidamente a cambios del mercado o necesidades internas, alineando la tecnología con los objetivos estratégicos de la empresa sin retrasos operativos. La escalabilidad y gestión de entornos complejos es otro punto fuerte. En empresas grandes, la infraestructura puede involucrar decenas o cientos de servidores que deben operar de manera coordinada. Herramientas de automatización permiten gestionar clústeres completos, balancear la carga, aplicar actualizaciones y mantener consistencia en todos los entornos, desde desarrollo y pruebas hasta producción. Esto garantiza que la infraestructura crezca de manera eficiente sin comprometer la estabilidad del sistema, un aspecto crucial para la gerencia al planificar expansión o proyectos estratégicos. El ahorro de tiempo y recursos es un beneficio tangible. Automatizar la implementación libera a los equipos de TI de tareas repetitivas y manuales, permitiéndoles enfocarse en proyectos de mayor valor, como optimización de procesos, innovación tecnológica y mejora de la experiencia del usuario. Para los gerentes de recursos humanos, esto también mejora la satisfacción laboral del equipo, reduce la rotación y promueve un enfoque más estratégico en la gestión tecnológica. La mejora en la seguridad y cumplimiento normativo es otro beneficio estratégico. Al automatizar la configuración de servidores, se asegura que todas las políticas de seguridad, controles de acceso, cifrado y auditorías se apliquen de manera consistente en todos los entornos. Esto reduce la exposición a vulnerabilidades y facilita el cumplimiento de regulaciones como GDPR, HIPAA o normas internas de seguridad de la información, aspectos críticos para proteger los datos de clientes y empleados. Además, la facilidad de integración con DevOps y CI/CD convierte la automatización de servidores en un componente esencial de la transformación digital. Herramientas de automatización permiten que la infraestructura se integre con pipelines de desarrollo continuo, pruebas automatizadas y despliegue continuo, creando un ecosistema ágil y eficiente. Para la gerencia, esto significa que la empresa puede innovar más rápido, lanzar nuevas funcionalidades y mantener un ciclo de vida de software más confiable y controlado. Entre las herramientas más utilizadas se destacan: Ansible: Permite la automatización de configuraciones y despliegues mediante playbooks sencillos y declarativos. Es ideal para mantener consistencia y reducir la complejidad en múltiples servidores. Terraform: Facilita la creación de infraestructura como código, especialmente en entornos de nube, permitiendo reproducir, modificar y versionar entornos de manera controlada. Puppet y Chef: Gestionan configuraciones complejas y mantienen el estado deseado de la infraestructura, aplicando políticas de seguridad y configuración de manera automática. Kubernetes: Aunque es más conocido para la orquestación de contenedores, permite automatizar el despliegue, escalado y gestión de aplicaciones distribuidas en múltiples servidores. Jenkins: Integrado con pipelines CI/CD, permite automatizar tareas de despliegue y pruebas, asegurando consistencia y eficiencia en la entrega de aplicaciones. En conclusión, las herramientas de automatización para la implementación de servidores aportan beneficios significativos que incluyen reducción de errores humanos, agilidad en despliegues, escalabilidad, ahorro de tiempo, seguridad y facilidad de integración con DevOps. Para directores de tecnología y gerentes de recursos humanos, estas herramientas permiten optimizar recursos, mejorar la productividad de los equipos, garantizar la confiabilidad de los sistemas y alinear la infraestructura tecnológica con los objetivos estratégicos de la empresa, fortaleciendo su competitividad y capacidad de innovación en un entorno empresarial cada vez más exigente y digitalizado.

¿Cómo aplicar políticas de seguridad basadas en roles en aplicaciones de servidor?

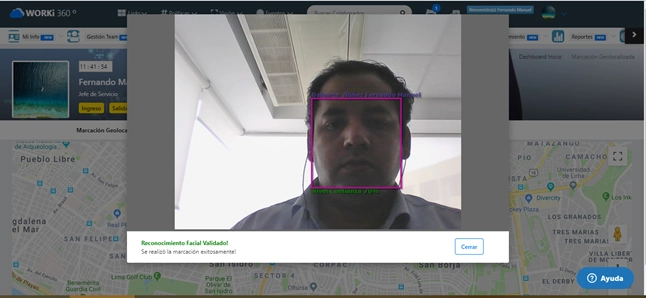

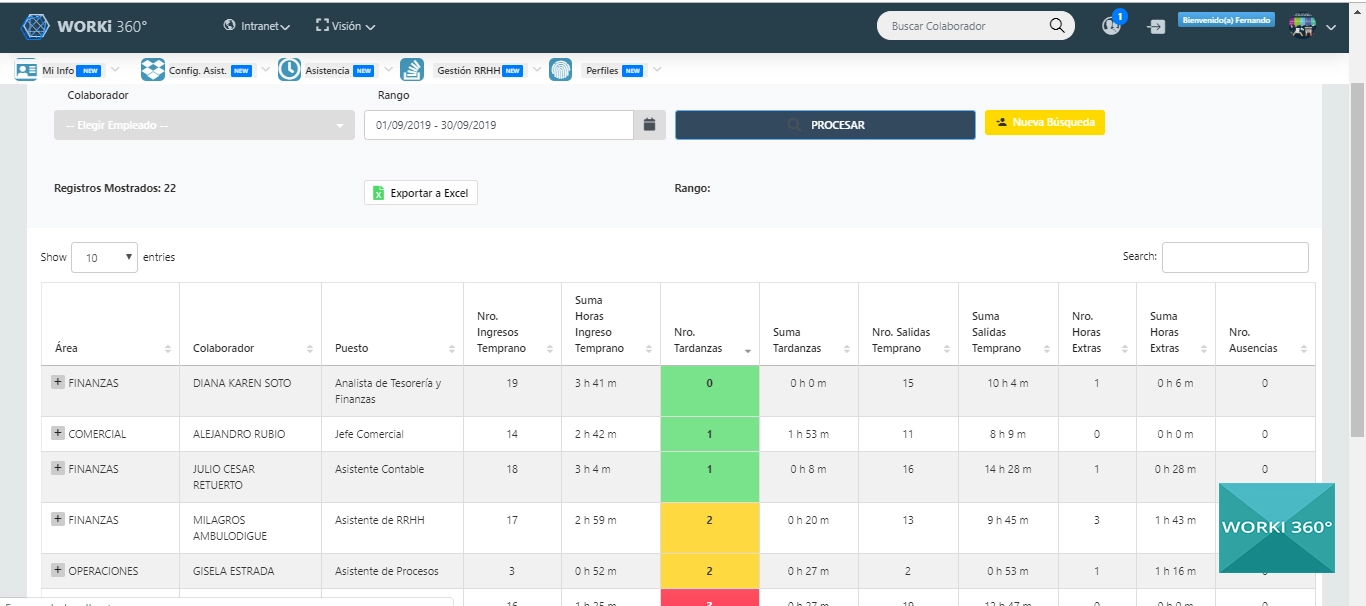

Aplicar políticas de seguridad basadas en roles (RBAC, Role-Based Access Control) es un componente fundamental para garantizar la protección de aplicaciones que se ejecutan en el servidor y los datos sensibles que manejan. Para directores de tecnología y gerentes de recursos humanos, implementar RBAC no solo protege la información crítica de clientes, empleados y procesos internos, sino que también mejora la eficiencia operativa, facilita el cumplimiento normativo y reduce riesgos legales y reputacionales. El primer paso para implementar RBAC de manera efectiva es definir claramente los roles dentro de la organización. Esto implica identificar los distintos niveles de responsabilidad y acceso que requieren los usuarios, desde administradores de sistemas hasta personal operativo o colaboradores temporales. Cada rol debe reflejar las necesidades reales de los usuarios y limitar el acceso solo a la información y funcionalidades estrictamente necesarias para sus tareas. Para la gerencia, esta definición asegura que se minimicen riesgos de acceso indebido y que los procesos de la empresa se mantengan seguros y eficientes. Una vez definidos los roles, es fundamental asignar permisos específicos de manera granular. Esto significa que cada rol debe tener permisos claramente delimitados sobre qué acciones puede realizar y qué datos puede visualizar o modificar. Por ejemplo, un administrador puede gestionar configuraciones de servidor y ver toda la información de la aplicación, mientras que un usuario operativo solo puede acceder a funcionalidades relacionadas con su área. Esta granularidad permite controlar con precisión el flujo de información y reduce la probabilidad de errores o filtraciones de datos sensibles. El principio de mínimo privilegio es un pilar en RBAC. Cada usuario o rol debe recibir solo los permisos estrictamente necesarios para cumplir su función, evitando otorgar accesos excesivos que puedan comprometer la seguridad del sistema. Implementar este principio reduce el riesgo de ataques internos o externos y protege los datos críticos de la empresa. Para los gerentes de TI y recursos humanos, aplicar este enfoque asegura que la información se maneje de manera responsable y que los riesgos de seguridad se mitiguen proactivamente. La auditoría y monitoreo constante es otro componente esencial. RBAC no solo implica definir roles y permisos, sino también registrar todas las actividades de los usuarios, generar reportes y analizar patrones de acceso. Esto permite detectar comportamientos inusuales, intentos de acceso no autorizados o brechas de seguridad, proporcionando a la gerencia información valiosa para tomar decisiones preventivas y garantizar el cumplimiento de políticas internas y normativas legales. La integración con sistemas de autenticación robustos mejora aún más la seguridad. Combinando RBAC con autenticación multifactor (MFA), Single Sign-On (SSO) o certificados digitales, se asegura que solo usuarios legítimos puedan acceder a los sistemas según los permisos de su rol. Esto refuerza la seguridad, evita accesos indebidos y facilita la administración centralizada de credenciales y políticas de acceso. Para los directores de TI, estas medidas simplifican la gestión de usuarios y fortalecen la protección de datos críticos. El mantenimiento y actualización periódica de roles y permisos es también esencial. La estructura organizativa, los equipos y las responsabilidades cambian con el tiempo, por lo que los roles definidos deben revisarse y ajustarse regularmente. Esto garantiza que los usuarios tengan siempre los permisos adecuados y que no existan accesos obsoletos que puedan generar vulnerabilidades. Para la gerencia, esta práctica asegura que la seguridad evolucione junto con la organización, manteniendo la integridad de los sistemas y la protección de datos. Finalmente, es importante capacitar a los equipos y fomentar la cultura de seguridad. Los usuarios deben comprender la importancia de los roles y permisos, respetar las políticas establecidas y reportar cualquier anomalía. La formación y la concienciación fortalecen la seguridad desde el factor humano, que es tan crítico como la tecnología misma. Para los gerentes de recursos humanos, esta capacitación mejora la responsabilidad de los equipos, reduce riesgos internos y fortalece la cultura corporativa orientada a la seguridad. En conclusión, aplicar políticas de seguridad basadas en roles en aplicaciones de servidor implica definir roles claros, asignar permisos granulares, aplicar el principio de mínimo privilegio, auditar y monitorear accesos, integrar sistemas de autenticación robustos, mantener roles actualizados y capacitar a los equipos. Para directores de tecnología y gerentes de recursos humanos, implementar RBAC no solo protege la información crítica y asegura el cumplimiento normativo, sino que también optimiza la operación de los sistemas, fortalece la productividad de los equipos y consolida la confianza en la infraestructura tecnológica de la empresa, ofreciendo una ventaja competitiva clave en un entorno empresarial cada vez más digital y exigente. 🧾 Resumen Ejecutivo El desarrollo de aplicaciones que se ejecutan en el servidor representa un pilar estratégico para empresas que buscan eficiencia, resiliencia y ventaja competitiva. Las 10 áreas analizadas en este artículo destacan cómo la tecnología backend, combinada con soluciones integrales como WORKI 360, permite a las organizaciones optimizar recursos, mejorar la seguridad, incrementar la productividad de los equipos y potenciar la innovación. 1. Ventajas competitivas de aplicaciones de servidor: La centralización de procesos y datos mejora la eficiencia operativa, reduce errores y garantiza consistencia en toda la organización. Con WORKI 360, esto se traduce en control de procesos críticos, seguridad reforzada y rapidez en la toma de decisiones, permitiendo a la empresa destacarse frente a la competencia. 2. Beneficios de los microservicios frente a aplicaciones monolíticas: La arquitectura basada en microservicios proporciona escalabilidad independiente, resiliencia ante fallos y agilidad en el desarrollo. WORKI 360 facilita la implementación de microservicios, permitiendo que los equipos trabajen de manera autónoma y eficiente, acelerando la entrega de nuevas funcionalidades y la innovación constante. 3. Transformación gracias a la nube: La nube ofrece escalabilidad dinámica, reducción de costos y acceso a tecnologías avanzadas. Con WORKI 360, las aplicaciones backend se despliegan rápidamente, integrando herramientas de análisis, automatización e inteligencia artificial, optimizando la operación y mejorando la experiencia de usuarios internos y externos. 4. Sistemas de respaldo y recuperación eficientes: La protección de datos críticos garantiza continuidad operativa y minimiza riesgos. WORKI 360 permite implementar respaldos automáticos, planes de recuperación ante desastres y auditorías periódicas, asegurando que la empresa pueda operar sin interrupciones incluso ante fallos inesperados. 5. KPIs clave para evaluar aplicaciones backend: Medir tiempo de respuesta, uso de recursos, tasa de errores y disponibilidad permite optimizar rendimiento y escalabilidad. Con WORKI 360, los directores de TI obtienen métricas detalladas y análisis estratégicos que facilitan la toma de decisiones informadas y proactivas. 6. Ventajas de la arquitectura serverless: El modelo sin servidor reduce costos, mejora la escalabilidad automática y acelera la innovación. WORKI 360 soporta la implementación de funciones serverless, permitiendo que las aplicaciones crezcan de manera eficiente y respondan rápidamente a demandas del mercado. 7. Estrategias de balanceo de carga: Técnicas como round-robin, balanceo por recursos, geográfico o con alta disponibilidad mejoran la disponibilidad y el rendimiento de las aplicaciones. Con WORKI 360, estas estrategias se implementan de manera automática, asegurando continuidad de negocio y experiencia consistente para usuarios y clientes. 8. Integración segura de APIs externas: Evaluar proveedores, autenticar usuarios, cifrar datos y monitorear transacciones garantiza integraciones confiables. WORKI 360 facilita conexiones seguras con servicios externos, optimizando procesos, ampliando funcionalidades y protegiendo datos críticos de clientes y colaboradores. 9. Herramientas de automatización para implementación de servidores: Ansible, Terraform, Puppet, Chef y Kubernetes permiten desplegar infraestructura de manera eficiente, repetible y segura. WORKI 360 integra estas herramientas para reducir errores humanos, acelerar despliegues y mantener entornos consistentes, liberando tiempo de los equipos de TI para proyectos estratégicos. 10. Políticas de seguridad basadas en roles (RBAC): Definir roles claros, aplicar permisos granulares y auditar accesos garantiza control sobre la información y cumplimiento normativo. Con WORKI 360, los administradores pueden gestionar roles y permisos de manera centralizada, fortaleciendo la seguridad, la productividad de los equipos y la confianza en la infraestructura tecnológica. Conclusión estratégica: La combinación de aplicaciones de servidor bien diseñadas, arquitecturas modernas como microservicios y serverless, y herramientas de gestión y automatización integradas en WORKI 360 proporciona a las empresas un ecosistema seguro, escalable y altamente eficiente. Esto permite a los directores de tecnología y gerentes de recursos humanos optimizar procesos, reducir riesgos, incrementar la innovación y garantizar la continuidad del negocio. En un entorno digital cada vez más competitivo, WORKI 360 se posiciona como una solución integral que transforma la operación tecnológica en un motor estratégico de crecimiento y diferenciación empresarial.