Índice del contenido

¿Qué tecnologías sustentan los sistemas de calificación automatizada más avanzados?

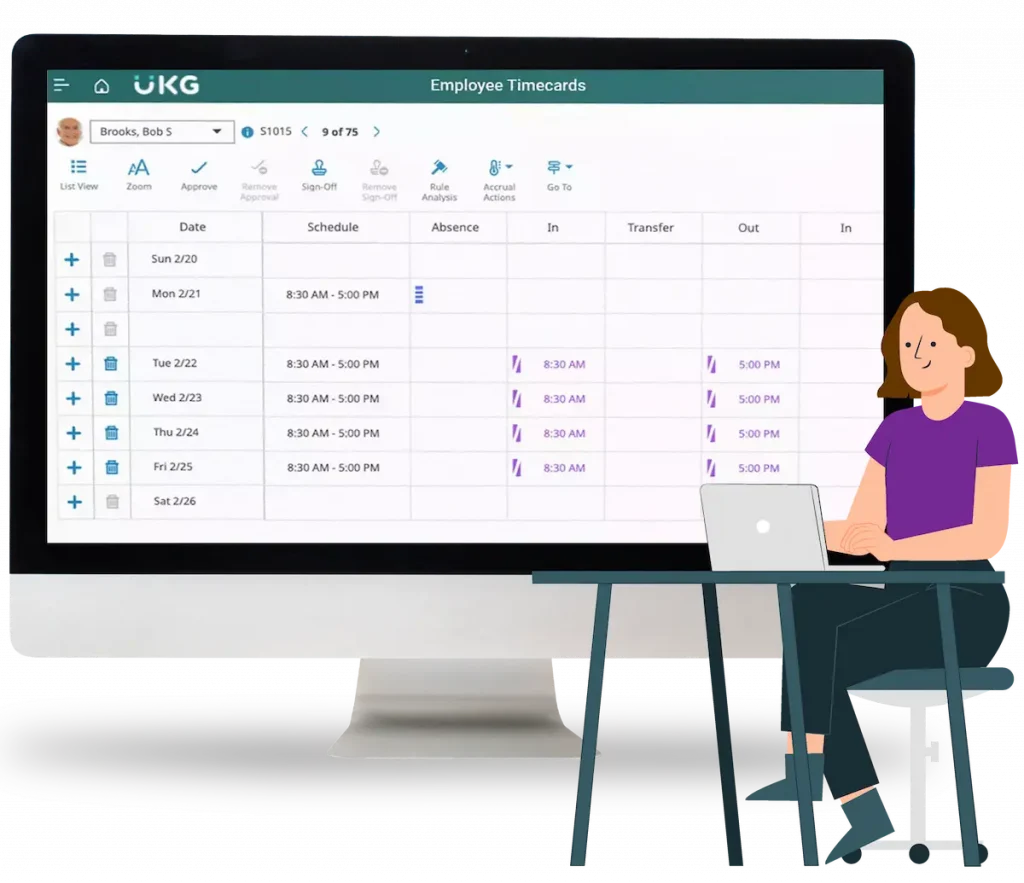

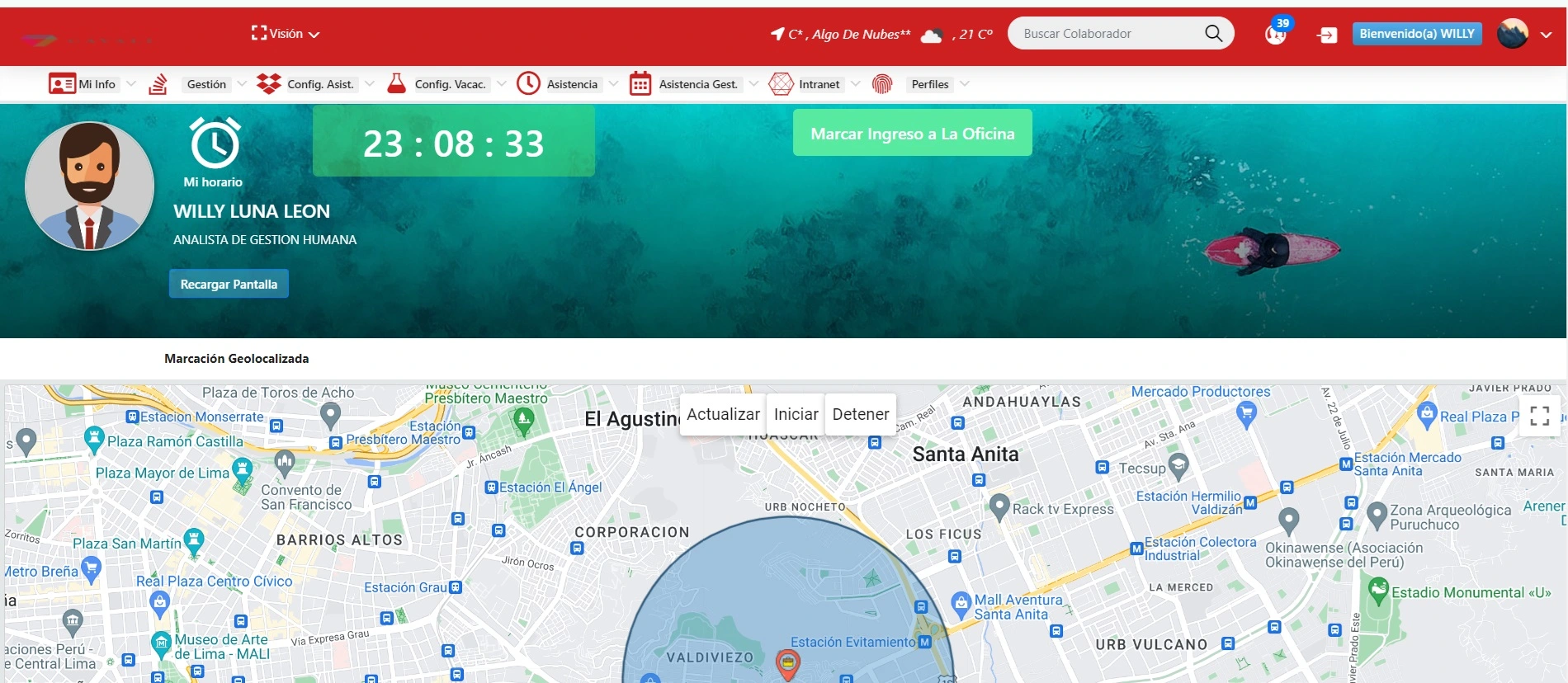

En un entorno corporativo donde la agilidad, precisión y escalabilidad se han convertido en mandatos estratégicos, los sistemas de calificación automatizada están emergiendo como una de las palancas más transformadoras en el ámbito del eLearning. Lejos de ser simples algoritmos que corrigen exámenes tipo test, estas tecnologías están evolucionando hacia plataformas sofisticadas capaces de evaluar habilidades complejas, entregar retroalimentación en tiempo real, y alimentar ecosistemas de datos que impulsan la toma de decisiones estratégicas en áreas como talento humano, desempeño, formación y liderazgo. Pero, ¿qué hay detrás de esta revolución silenciosa? ¿Qué tecnologías hacen posible que una máquina evalúe, entienda y mejore el conocimiento de un ser humano dentro de una organización? Para responder esta pregunta con propiedad, es fundamental realizar un recorrido profundo por las tecnologías que integran y potencian los sistemas de calificación automatizada más avanzados en la actualidad. 1.1 Inteligencia Artificial (IA) y Aprendizaje Automático (Machine Learning) La piedra angular de los sistemas modernos de calificación automatizada es la inteligencia artificial, en particular, el aprendizaje automático. Gracias a estas tecnologías, los sistemas pueden aprender del comportamiento de miles de usuarios, identificar patrones y ajustar sus criterios de evaluación con el tiempo. Por ejemplo, un sistema puede aprender a detectar cuándo un usuario ha comprendido un concepto, no solo por la respuesta correcta, sino por la forma en la que responde, el tiempo que dedica, y la lógica detrás de su elección. Esto permite que las evaluaciones sean mucho más personalizadas, predictivas y ajustadas a la realidad cognitiva del colaborador. 1.2 Procesamiento de Lenguaje Natural (NLP) La evaluación automática de respuestas abiertas es uno de los mayores desafíos en el ámbito del eLearning. Aquí entra en juego el Procesamiento de Lenguaje Natural, que permite a los sistemas comprender, analizar y calificar textos escritos por humanos. Esta tecnología ha evolucionado tanto que hoy se pueden evaluar ensayos, presentaciones, justificaciones y reflexiones con un nivel de precisión sorprendente. Por ejemplo, plataformas como Grammarly y Turnitin han demostrado cómo el NLP puede detectar estructura gramatical, coherencia lógica, argumentación e incluso plagio, todo en tiempo real. 1.3 Computer Vision (Visión por Computadora) En contextos donde la evaluación requiere interpretación visual, como el análisis de diagramas, planos, códigos escritos a mano o incluso presentaciones en video, la visión por computadora se convierte en una herramienta clave. A través de esta tecnología, un sistema puede comparar una respuesta visual contra modelos correctos, detectar elementos faltantes, e incluso analizar expresiones faciales o lenguaje corporal en pruebas prácticas grabadas. Esta capacidad es particularmente útil en evaluaciones técnicas, creativas o interactivas. 1.4 Algoritmos adaptativos y modelos psicométricos No todas las personas aprenden igual, ni a la misma velocidad. Los algoritmos adaptativos permiten que el sistema de evaluación se ajuste dinámicamente a las respuestas del usuario. Si un colaborador responde correctamente a una serie de preguntas, el sistema eleva la dificultad automáticamente. Si responde mal, adapta el tipo de pregunta o profundiza en contenidos fundamentales. Además, muchos de estos sistemas integran modelos psicométricos como el Item Response Theory (IRT) para asegurar que las evaluaciones sean válidas, confiables y justas en función del perfil del evaluado. 1.5 Big Data y analítica avanzada Cada interacción con una plataforma de eLearning genera datos: tiempo de respuesta, patrones de navegación, frecuencia de errores, niveles de confianza, etc. Los sistemas de calificación automatizada más avanzados recolectan y procesan estos datos para alimentar dashboards ejecutivos, informes de progreso y alertas personalizadas. Así, no solo califican, sino que generan conocimiento estratégico sobre el talento: quién necesita apoyo, quién puede asumir nuevos desafíos, y cómo se correlacionan los aprendizajes con los objetivos del negocio. 1.6 Blockchain y trazabilidad de datos En contextos donde la validez, integridad y trazabilidad de los resultados de evaluación son críticos —como en certificaciones internas, programas de compliance o rutas de sucesión— la integración de tecnología blockchain permite registrar de forma inviolable cada resultado de evaluación. Esto garantiza la transparencia del proceso, previene fraudes, y facilita auditorías tanto internas como externas. 1.7 Plataformas LMS con motores de evaluación embebidos Sistemas de gestión del aprendizaje como Moodle, Blackboard, SAP SuccessFactors o Docebo están incorporando motores de calificación automatizada cada vez más potentes. Estas plataformas permiten configurar rúbricas digitales, flujos de feedback automático, criterios personalizados por competencia, y seguimiento de progreso adaptativo. La clave aquí es la integración: mientras más integrado esté el sistema de evaluación con la plataforma de formación, más coherente y fluido será el recorrido del colaborador. 1.8 Integración con sistemas de Recursos Humanos (HCM y TMS) Finalmente, una tecnología crítica no es solo la que permite calificar, sino aquella que permite actuar en consecuencia. Los sistemas más avanzados de evaluación automatizada se integran con plataformas de gestión del talento, permitiendo que los resultados alimenten procesos de promoción, desarrollo, compensación, movilidad interna y planificación de la sucesión. Así, el aprendizaje no queda en una dimensión académica, sino que se convierte en una herramienta de gestión estratégica del capital humano.

¿Cómo influye la inteligencia artificial en la evolución del eLearning y la evaluación automatizada?

La inteligencia artificial (IA) ha dejado de ser una promesa futurista para convertirse en un eje transformador del presente organizacional. En el ámbito del eLearning y la evaluación automatizada, su impacto es tan profundo como diverso. Lo que antes eran entornos de formación genéricos, estandarizados y poco responsivos, hoy están dando paso a experiencias hiperpersonalizadas, adaptativas, predictivas y centradas en el usuario. Pero más allá de lo técnico, la IA está redefiniendo el rol de la formación dentro de las organizaciones, convirtiéndola en un proceso estratégico, integrado y medible. En este contexto, vale la pena explorar en profundidad cómo influye la inteligencia artificial en la evolución del eLearning y, de manera específica, en los sistemas de evaluación automatizada. 2.1 Aprendizaje adaptativo: personalización a escala Gracias a la IA, las plataformas de eLearning pueden adaptarse en tiempo real al nivel, ritmo y estilo de aprendizaje de cada colaborador. La inteligencia artificial analiza datos como respuestas correctas, tiempo de respuesta, nivel de confianza, repeticiones y progresión, para ofrecer contenidos ajustados a las necesidades individuales. Este aprendizaje adaptativo no solo mejora la eficacia del proceso formativo, sino que también permite detectar brechas tempranas, evitar frustraciones y aumentar la retención de conocimiento. 2.2 Evaluación predictiva y diagnóstica Una de las contribuciones más revolucionarias de la IA en evaluación es su capacidad para anticipar el desempeño. A través de algoritmos de machine learning entrenados con grandes volúmenes de datos históricos, es posible predecir con alta precisión si un colaborador aprobará un módulo, qué competencias tiene más desarrolladas, y qué factores inciden en su éxito. Esto permite diseñar rutas formativas preventivas, asignar recursos de forma eficiente y reducir el fracaso formativo. 2.3 Automatización del feedback La inteligencia artificial permite entregar retroalimentación automatizada, específica y en tiempo real. Ya no se trata de un simple “correcto/incorrecto”, sino de explicaciones detalladas, sugerencias de mejora, referencias cruzadas y contenidos complementarios. Esta capacidad amplifica la autonomía del colaborador, fomenta el autoaprendizaje y reduce significativamente la carga de los formadores humanos. 2.4 Análisis semántico en evaluaciones abiertas Las evaluaciones de tipo ensayo, reflexión o respuesta corta tradicionalmente requerían una revisión humana intensiva. Hoy, gracias al análisis semántico impulsado por IA, es posible calificar estas respuestas de manera automatizada, considerando coherencia, argumentación, ortografía, calidad crítica y pertinencia. Esto democratiza el acceso a evaluaciones de nivel alto, sin importar el tamaño de la audiencia, y reduce los sesgos humanos. 2.5 Inteligencia conversacional y tutores virtuales Los asistentes virtuales basados en IA pueden acompañar a los colaboradores durante todo su proceso formativo. Pueden responder preguntas frecuentes, explicar conceptos complejos, sugerir contenidos, recordar fechas clave y hasta realizar sesiones de práctica interactivas. Estos tutores virtuales crean una sensación de acompañamiento constante, eliminando una de las grandes barreras del eLearning tradicional: la soledad del aprendiz. 2.6 Evaluaciones automatizadas en tiempo real durante simulaciones En formaciones prácticas, la IA permite evaluar en tiempo real el desempeño de un colaborador en entornos simulados. Por ejemplo, en una simulación de negociación, la IA puede analizar el tono, el vocabulario, la estructura de argumentos y los resultados obtenidos, para entregar una calificación inmediata y retroalimentación precisa. Esta capacidad es especialmente útil en formación de habilidades blandas y competencias críticas. 2.7 Mejora continua del contenido y las evaluaciones La IA no solo aprende de los colaboradores, también aprende de sí misma. A través del análisis continuo de resultados, feedback y patrones de uso, puede identificar preguntas mal formuladas, contenidos que generan confusión, rutas de aprendizaje ineficientes y puntos de abandono. Así, el sistema se convierte en un organismo vivo que mejora de forma continua sin intervención humana directa. 2.8 Integración con modelos de gestión del talento La IA permite conectar los datos de formación y evaluación con modelos predictivos de desempeño, engagement y rotación. De este modo, la formación deja de ser un silo operativo para convertirse en una herramienta estratégica alineada con los objetivos del negocio. Los responsables de RRHH pueden tomar decisiones basadas en evidencia sobre promociones, movilidad interna, programas de liderazgo y más. 2.9 Evaluación ética y reducción de sesgos Bien diseñada, la inteligencia artificial puede contribuir a una evaluación más justa y objetiva. Al eliminar variables humanas como prejuicios inconscientes, fatiga o interpretaciones subjetivas, la IA puede ofrecer evaluaciones más consistentes. Sin embargo, esto requiere un diseño ético y transparente del algoritmo, así como auditorías periódicas para garantizar la equidad del sistema. 2.10 El desafío de la confianza A pesar de todas sus ventajas, uno de los mayores retos en la aplicación de la IA en evaluación automatizada es la confianza del usuario. Si los colaboradores no comprenden cómo se les evalúa, o si perciben el sistema como opaco, su compromiso se verá afectado. Por eso, la implementación debe ir acompañada de una estrategia de comunicación clara, formación interna y mecanismos de apelación o revisión.

¿Cómo asegurar la alineación entre los objetivos del curso y los criterios de evaluación automatizada?

En el diseño instruccional corporativo, uno de los desafíos más críticos y, al mismo tiempo, más invisibles es garantizar que los criterios de evaluación realmente midan lo que se supone que el colaborador debe aprender. Esta alineación —entre objetivos del curso y mecanismos de evaluación— es el corazón de un proceso formativo efectivo. Cuando se implementa calificación automatizada, el desafío se amplifica: ¿cómo lograr que la lógica del algoritmo y los modelos de evaluación automáticos estén íntimamente ligados a los resultados esperados del aprendizaje? Una evaluación automatizada mal alineada no solo es ineficiente, sino que puede ser contraproducente. Puede premiar el conocimiento superficial, desalentar la reflexión crítica o generar una percepción de injusticia. Por ello, para los líderes de Recursos Humanos, Tecnología y Formación, asegurar esta alineación no es un detalle técnico, sino un factor clave de éxito organizacional. A continuación, exploraremos en profundidad cómo garantizar esta coherencia entre objetivos y evaluación en entornos de calificación automatizada. 3.1 Comenzar por la definición clara y medible de objetivos de aprendizaje La base de toda alineación comienza con una correcta formulación de objetivos. Estos deben ser específicos, medibles, alcanzables, relevantes y acotados en el tiempo (modelo SMART). Pero más allá de la teoría, es vital que estén redactados con verbos de acción claros y vinculados directamente a competencias laborales. Por ejemplo, no basta con decir “El colaborador conocerá los principios de ciberseguridad”, sino que debe establecerse algo como: “El colaborador será capaz de identificar y aplicar protocolos básicos de protección de datos en el entorno de trabajo digital”. Una redacción ambigua genera ambigüedad en la evaluación. Si el objetivo no puede ser observado ni medido, ninguna evaluación —ni automática ni humana— podrá hacerlo adecuadamente. 3.2 Diseñar evaluaciones desde el principio, no al final En muchas ocasiones, las evaluaciones se diseñan al final del proceso, como un complemento. Sin embargo, en contextos de calificación automatizada, lo ideal es aplicar el enfoque conocido como backward design o “diseño inverso”, donde el punto de partida son los resultados de aprendizaje y la evidencia esperada del desempeño del alumno. Una vez definidos estos, se diseña la forma de evaluarlos y, finalmente, se crean los contenidos y actividades del curso. Este modelo garantiza que lo que se evalúa esté verdaderamente alineado con lo que se enseña y con lo que se espera lograr en términos de competencias. 3.3 Elegir tipos de preguntas compatibles con los niveles cognitivos del objetivo No todos los tipos de preguntas sirven para todos los objetivos. Si el objetivo es que el colaborador comprenda un concepto, una pregunta de opción múltiple bien diseñada puede ser suficiente. Pero si el objetivo es que aplique, analice o cree soluciones, entonces se requerirán casos, simulaciones o ejercicios prácticos. Los sistemas de calificación automatizada más robustos permiten integrar múltiples formatos: desde preguntas cerradas hasta respuestas abiertas analizadas con IA, pasando por análisis de comportamiento en simulaciones. La elección del tipo de evaluación debe hacerse en función del nivel de Bloom que el objetivo representa: recordar, comprender, aplicar, analizar, evaluar o crear. Asegurar que el tipo de pregunta esté alineado con ese nivel es esencial para validar el proceso formativo. 3.4 Utilizar rúbricas automatizables Uno de los grandes retos de la automatización es mantener criterios claros y consistentes, especialmente en preguntas que involucran interpretación (respuestas abiertas, análisis de casos, proyectos). Para ello, las rúbricas digitales son herramientas clave. Una rúbrica bien diseñada traduce el juicio humano en reglas automatizables. Define qué se espera en cada nivel de desempeño, y cómo se califica. Las plataformas actuales permiten incorporar estas rúbricas al sistema de calificación automática, de modo que el algoritmo “evalúe” según los mismos criterios que lo haría un formador humano. Esto permite mantener la alineación con los objetivos y garantizar transparencia. 3.5 Integrar expertos de contenido con diseñadores instruccionales y tecnólogos Asegurar la alineación no es tarea de un solo actor. Requiere la colaboración sinérgica entre quienes conocen el contenido, quienes diseñan la experiencia de aprendizaje y quienes implementan la tecnología. Es clave que trabajen de forma conjunta desde la etapa de diseño, discutiendo preguntas como: ¿Qué evidencia demostraría que un colaborador ha alcanzado este objetivo? ¿Qué tipos de errores comunes se esperan? ¿Cómo se puede calificar esto automáticamente sin perder riqueza evaluativa? Esta conversación interdisciplinaria es la base para un diseño de calidad, donde la evaluación es tan sólida como el contenido. 3.6 Realizar pruebas piloto y calibración de preguntas Antes de escalar cualquier evaluación automatizada, es vital realizar pruebas piloto. Estas permiten detectar incongruencias entre lo que se enseña y lo que se evalúa. Además, se puede aplicar análisis psicométrico para validar la confiabilidad y validez de las preguntas, así como su dificultad y poder de discriminación. Esto ayuda a ajustar criterios, reformular enunciados y garantizar que las preguntas estén verdaderamente alineadas con los objetivos. 3.7 Feedback constructivo vinculado al objetivo Otro elemento clave para asegurar la alineación es el tipo de retroalimentación que el sistema ofrece. Si un colaborador responde incorrectamente, el feedback debe hacer referencia explícita al objetivo no alcanzado y ofrecer orientaciones para mejorar. Esto no solo refuerza el aprendizaje, sino que mantiene coherencia en la experiencia formativa: el colaborador entiende por qué esa pregunta existía y cómo se relaciona con lo que debe saber o hacer. 3.8 Monitoreo continuo y mejora iterativa La alineación no es un logro estático. Los objetivos del negocio cambian, las competencias evolucionan, y los sistemas de evaluación deben acompañar esa dinámica. Por ello, es clave establecer mecanismos de revisión periódica: análisis de datos de desempeño, encuestas de satisfacción, revisión por expertos, entre otros. Estos insumos permiten mantener actualizado el vínculo entre lo que se enseña, lo que se evalúa y lo que se necesita estratégicamente.

¿Qué impacto tiene la automatización en la motivación de los empleados durante su formación?

En la evolución de los modelos de formación corporativa, uno de los elementos más delicados —y muchas veces ignorado— es la motivación del colaborador. Por más tecnología que se integre, contenidos de calidad que se diseñen o sistemas que se optimicen, si el colaborador no está motivado a participar activamente en su proceso formativo, todo esfuerzo se ve comprometido. Es aquí donde la automatización de la evaluación despierta una discusión estratégica: ¿esta automatización motiva o desmotiva? ¿Genera compromiso o lo reduce a una rutina mecánica? La respuesta no es binaria. La automatización de evaluaciones puede tener impactos profundamente positivos o negativos en la motivación, dependiendo de cómo se diseñe, comunique e implemente. Analicemos en profundidad estos impactos y cómo gestionarlos para que la automatización se convierta en una aliada del engagement. 4.1 La promesa de inmediatez: feedback motivador en tiempo real Una de las formas más efectivas de motivar a un adulto en procesos formativos es ofrecerle retroalimentación inmediata. La calificación automatizada permite que el colaborador no tenga que esperar días o semanas para saber si va por buen camino. Puede ver al instante sus logros, detectar errores y entender por qué falló. Esta capacidad de cerrar el ciclo de aprendizaje rápidamente genera una sensación de avance, competencia y control, lo que motiva a continuar aprendiendo. 4.2 Percepción de justicia y objetividad Muchos colaboradores sienten desconfianza en evaluaciones sujetas a interpretación humana, especialmente si se perciben sesgos o arbitrariedad. La automatización, bien implementada, puede generar una percepción de mayor objetividad: todos son evaluados por los mismos criterios, sin favoritismos ni juicios personales. Esta sensación de equidad puede ser altamente motivadora, en especial en culturas organizacionales que valoran la meritocracia. 4.3 Gamificación y dinámicas de juego automatizadas Una de las grandes ventajas de automatizar procesos de evaluación es que se habilita la posibilidad de integrar mecánicas de gamificación: puntos, niveles, insignias, desafíos, tablas de clasificación. Estas dinámicas convierten el proceso en una experiencia lúdica, competitiva (de forma saludable) y emocionalmente atractiva. Cuando el colaborador “juega” a aprender y ve sus avances representados gráficamente, se involucra con más pasión. 4.4 Riesgo de deshumanización del proceso El principal riesgo de una automatización mal diseñada es que el colaborador se sienta evaluado por una “máquina sin alma”, sin entender el propósito de la evaluación ni sentir un acompañamiento humano. Si la retroalimentación es genérica, si el sistema es percibido como rígido o punitivo, o si no hay un formador disponible para discutir resultados, la motivación puede desplomarse. Por eso, la automatización no debe reemplazar lo humano, sino amplificarlo. Los mejores sistemas combinan evaluaciones automáticas con espacios de mentoría, coaching o reflexión personal. 4.5 Estímulo del aprendizaje autónomo y autogestión Al ofrecer claridad sobre lo que se espera, mostrar progresos y permitir repetir evaluaciones sin penalización, los sistemas automatizados bien diseñados promueven el aprendizaje autodirigido. El colaborador no depende de un instructor; puede gestionar su tiempo, avanzar a su ritmo y asumir responsabilidad por su desarrollo. Esta autonomía es un poderoso motivador, especialmente en perfiles adultos, técnicos o ejecutivos. 4.6 Repetibilidad sin sanción: una motivación para mejorar Uno de los grandes beneficios de la automatización es que permite realizar múltiples intentos, recibir retroalimentación y volver a intentar sin sanciones. Esto refuerza una mentalidad de crecimiento: el error no es penalizado, sino considerado parte del proceso. Este enfoque reduce la ansiedad, aumenta la persistencia y estimula la mejora continua. 4.7 Riesgo de mecanización del aprendizaje Por otro lado, si la evaluación automatizada se basa exclusivamente en preguntas tipo test, sin contexto ni conexión con la práctica real, puede percibirse como una actividad mecánica y poco significativa. Esto genera desmotivación, especialmente en colaboradores que necesitan entender el “para qué” de lo que están aprendiendo. Para evitarlo, es clave diseñar evaluaciones contextualizadas, relevantes y desafiantes, que conecten con la realidad del puesto de trabajo. 4.8 Visualización del progreso como motor motivacional Los sistemas automatizados permiten construir dashboards donde el colaborador ve gráficamente su progreso: porcentaje de avance, competencias adquiridas, comparativa con su equipo, metas alcanzadas. Esta visualización constante del camino recorrido y lo que falta por recorrer es un motivador potente. Transforma el aprendizaje en una experiencia tangible, medible y orientada a logros.

¿Cómo detectar y corregir errores en una evaluación automática?

En el entorno corporativo, donde la eficiencia, precisión y escalabilidad son vitales, los sistemas de evaluación automática representan una promesa de modernización y optimización de los procesos formativos. Sin embargo, esa promesa puede verse rápidamente comprometida si no se asegura un aspecto fundamental: la confiabilidad y validez de los resultados. Como toda tecnología, la calificación automatizada no está exenta de errores. Puede fallar en su lógica interna, en la calidad de las preguntas, en la interpretación de las respuestas o incluso en sus criterios de retroalimentación. Lo que está en juego no es menor: decisiones sobre el talento, promoción, formación adicional o incluso retención pueden estar basadas en evaluaciones defectuosas. Para los responsables de Recursos Humanos, Formación Corporativa y Tecnología, detectar y corregir errores en las evaluaciones automatizadas no es un detalle operativo, sino una prioridad estratégica y ética. A continuación, se desarrollan de manera exhaustiva las estrategias, herramientas y buenas prácticas que deben considerarse para garantizar evaluaciones automáticas sólidas, justas y alineadas con los objetivos del negocio. 5.1 Identificación proactiva: la clave está en la revisión previa y la validación técnica Antes de hablar de corrección, el primer paso es asegurar la detección temprana. Esto implica un proceso riguroso de revisión previa al despliegue masivo de cualquier instrumento de evaluación automatizada. Para ello se recomiendan: Validaciones cruzadas por expertos de contenido, que aseguren la pertinencia y coherencia de las preguntas. Revisión de las rutas lógicas (en especial en preguntas adaptativas o condicionales). Análisis psicométrico previo: confiabilidad, dificultad, discriminación y consistencia interna. Simulaciones de evaluaciones, usando perfiles ficticios para comprobar el comportamiento del sistema. Este trabajo preventivo permite detectar errores como: ambigüedad en los enunciados, respuestas correctas marcadas incorrectamente, desajustes en el puntaje asignado, fallos de navegación o feedback no relacionado con el error. 5.2 Monitoreo en tiempo real: detectando errores operativos o sistémicos durante la aplicación Incluso si la evaluación ha pasado por pruebas rigurosas, pueden emerger errores al momento de ser aplicada a gran escala. Para detectarlos, es clave implementar sistemas de monitoreo en tiempo real que permitan: Identificar preguntas con tasas de error anormalmente altas. Detectar patrones inusuales de respuesta (como muchas respuestas incorrectas a una misma opción en distintos grupos). Analizar comentarios de usuarios que reporten errores o confusión durante la evaluación. Muchos LMS y plataformas de evaluación permiten activar estas métricas y alertas, las cuales deben ser supervisadas activamente por un equipo técnico-pedagógico. 5.3 Auditoría de resultados y patrones de calificación Después de aplicar la evaluación, se debe realizar una auditoría sistemática de los resultados. Esta auditoría puede revelar errores que no son evidentes a simple vista, como: Sesgo sistemático contra ciertos grupos (por ejemplo, usuarios de una sede, un cargo o idioma específico). Desviaciones estadísticas en la distribución de calificaciones que indiquen errores de diseño. Incongruencias entre desempeño real en el trabajo y resultados obtenidos en la evaluación automatizada. Comparar estos datos contra información de desempeño real, encuestas de satisfacción y observaciones cualitativas puede enriquecer la comprensión del error. 5.4 Uso de retroalimentación de usuarios como fuente crítica de mejora Los usuarios que enfrentan una evaluación son, en muchos casos, los primeros en notar fallas. Implementar mecanismos de retroalimentación posterior a la evaluación es vital: Encuestas de satisfacción focalizadas. Comentarios abiertos sobre preguntas específicas. Botón de “reportar error” en cada ítem. Este canal de comunicación permite detectar errores de forma directa, entender la experiencia de usuario y recuperar la confianza cuando se corrige oportunamente. 5.5 Revisión y ajuste de algoritmos de calificación automática En evaluaciones más complejas —especialmente aquellas basadas en procesamiento de lenguaje natural o visión por computadora— el riesgo de error en la interpretación es mayor. En estos casos, se deben realizar pruebas de consistencia entre evaluaciones humanas y automáticas: Cotejo de resultados: una muestra de respuestas es evaluada por expertos humanos y comparada con el algoritmo. Entrenamiento continuo del modelo: ajustar los parámetros del sistema según los casos identificados como erróneos. Revisión de sesgos algorítmicos: asegurar que no haya patrones discriminatorios no intencionados en los datos con los que fue entrenado el sistema. Este proceso exige colaboración estrecha entre expertos en IA, diseñadores instruccionales y responsables de formación. 5.6 Implementación de rúbricas digitales claras y actualizables Uno de los errores más frecuentes es que las evaluaciones no sigan criterios claros o estén basadas en juicios implícitos del programador o diseñador. Las rúbricas digitales permiten convertir los criterios subjetivos en parámetros objetivos y automatizables. Sin embargo, estas rúbricas deben ser: Claramente alineadas con los objetivos del curso. Capaces de adaptarse a nuevos aprendizajes de los usuarios. Revisadas periódicamente por expertos y por datos reales de aplicación. Una rúbrica mal diseñada o desactualizada puede ser la causa principal de errores persistentes en evaluaciones. 5.7 Estrategias de corrección: ¿Qué hacer cuando se detecta un error? La forma de corregir un error depende de su naturaleza y momento de detección. Algunas posibles acciones incluyen: Corrección retroactiva del puntaje, si el error afectó la calificación general. Revisión manual de ciertos ítems, en casos de respuestas abiertas o casos de interpretación ambigua. Comunicación directa con los evaluados, explicando el error y cómo se resolverá. Reaplicación de la evaluación si el error fue sistémico y afecta la validez total del instrumento. Ajustes en el motor de evaluación o en los modelos de IA involucrados. La clave está en actuar con rapidez, transparencia y equidad. Los colaboradores deben sentir que su esfuerzo no fue en vano y que el sistema responde con responsabilidad. 5.8 Prevención como política: cultura de mejora continua Más allá de la detección y corrección, las organizaciones deben establecer una cultura de mejora continua basada en: Revisión post-mortem de cada evaluación. Lecciones aprendidas compartidas entre equipos. Protocolos de revisión cruzada y control de calidad. Capacitación permanente de los equipos responsables del diseño y validación de las evaluaciones automatizadas. Este enfoque preventivo transforma los errores en oportunidades de aprendizaje institucional.

¿Qué herramientas de autor permiten incluir evaluaciones automáticas avanzadas?

En el corazón de cualquier sistema de eLearning eficaz se encuentra una herramienta que, aunque muchas veces pasa desapercibida, es crítica para el éxito del programa: la herramienta de autor. Estas plataformas permiten crear contenidos educativos interactivos, visualmente atractivos, funcionales y, sobre todo, evaluables de manera automatizada. En un contexto corporativo donde se busca escalar la formación, personalizarla y medir su impacto con precisión, contar con herramientas de autor que integren evaluaciones automatizadas avanzadas no es solo deseable: es imprescindible. A continuación, se presenta un análisis profundo sobre las herramientas de autor más relevantes, sus capacidades evaluativas y las claves para seleccionar la adecuada según las necesidades organizacionales. 6.1 ¿Qué entendemos por “evaluaciones automáticas avanzadas”? Antes de entrar en nombres, es clave definir qué se espera de una evaluación automatizada “avanzada” en el entorno corporativo. Estas deberían permitir: Evaluar múltiples niveles cognitivos (recordar, aplicar, analizar, crear). Incluir rúbricas automáticas para respuestas abiertas. Ofrecer retroalimentación inmediata, adaptativa y contextualizada. Integrarse con sistemas LMS y HCM para trazabilidad y reportes. Incorporar elementos multimedia y simulaciones evaluables. Permitir análisis de datos avanzados (dashboard de desempeño, tasas de error, etc.). Solo algunas herramientas en el mercado logran cumplir estos criterios en su máxima expresión. 6.2 Articulate Storyline / Rise 360 Una de las herramientas más potentes y populares del mercado corporativo. Storyline permite crear evaluaciones interactivas personalizadas, con lógica condicional, variables y retroalimentación específica. Se pueden construir evaluaciones ramificadas, juegos de preguntas, simulaciones de software, y se integra perfectamente con SCORM. Rise 360, su versión web más ágil, permite integrar quizzes dentro de cursos responsive. Ofrece integración con LMS estándar y generación de reportes detallados. Ideal para organizaciones que desean un control creativo total sobre la experiencia. 6.3 Adobe Captivate Otra herramienta robusta, especialmente en entornos donde el contenido debe ser altamente interactivo. Permite crear simulaciones de sistemas, escenarios de decisión, evaluaciones con feedback adaptativo. Integra preguntas con variables, pesos diferenciados, temporizadores y lógica avanzada. Tiene opciones de integración con IA para análisis predictivo. Requiere curva de aprendizaje técnica, pero ofrece gran control sobre el diseño instruccional. 6.4 iSpring Suite Ideal para organizaciones que ya trabajan con PowerPoint y desean dar el salto al eLearning sin perder esa familiaridad. Convierte presentaciones en cursos interactivos SCORM, incluyendo cuestionarios automáticos avanzados. Permite crear diferentes tipos de preguntas (selección múltiple, arrastrar y soltar, emparejamiento, etc.). Incluye funciones de gamificación y banco de preguntas aleatorias. Muy útil para capacitaciones rápidas, compliance y entrenamientos técnicos básicos. 6.5 H5P (HTML5 Package) Plataforma de código abierto muy usada en Moodle y otros LMS. Permite incluir actividades como drag-and-drop, quizzes, videos interactivos y más. Ideal para organizaciones con bajo presupuesto que requieren evaluaciones interactivas básicas pero funcionales. Requiere ciertos conocimientos técnicos para su implementación y personalización. Su comunidad activa genera constantes actualizaciones y plugins nuevos. 6.6 Easygenerator Una herramienta basada en la nube que permite a expertos de contenido crear cursos con mínima intervención de diseñadores instruccionales. Permite incluir evaluaciones con feedback inmediato, lógica adaptativa y rutas personalizadas. Muy enfocada en el usuario final, con dashboards claros y UX moderna. Ideal para organizaciones con equipos reducidos y necesidad de agilidad. 6.7 Adapt Learning Herramienta open source que permite construir cursos altamente responsivos. Sus evaluaciones pueden ser configuradas con lógica condicional y puntuación personalizada. Muy útil en entornos multilingües y corporativos con diseño responsive obligatorio. Requiere cierta curva técnica, pero otorga gran flexibilidad. 6.8 Consideraciones clave para elegir una herramienta de autor A la hora de seleccionar la herramienta más adecuada, es importante considerar: Nivel de control deseado: ¿Necesitas control total del diseño o rapidez en la producción? Perfil del equipo interno: ¿Tienes diseñadores instruccionales técnicos o usuarios sin formación pedagógica? Integración con LMS y sistemas de talento: ¿Puede exportar a SCORM, xAPI, LTI? ¿Se conecta con tus sistemas internos? Escalabilidad: ¿Soporta grandes volúmenes de usuarios y carga evaluativa simultánea? Coste y licenciamiento: ¿Modelo SaaS, licencias perpetuas o open source?

¿Cómo se mide la eficacia de una calificación automatizada?

En la era del aprendizaje digital corporativo, donde los sistemas de calificación automatizada ganan cada vez más terreno, surge una pregunta crítica y estratégica para cualquier directivo de RRHH, Formación o Tecnología: ¿cómo saber si este sistema realmente funciona? La eficacia de una evaluación automatizada no puede basarse simplemente en que “funcione” técnicamente o que “califique” respuestas. Eso es apenas el punto de partida. Lo verdaderamente importante es que el sistema contribuya a los objetivos organizacionales de aprendizaje, desarrollo del talento y toma de decisiones basadas en datos confiables. Medir la eficacia de una calificación automatizada exige una mirada amplia, multidimensional y basada en indicadores tangibles. No se trata solo de revisar estadísticas de aprobación o tiempo de respuesta, sino de analizar a fondo cómo esta evaluación está impactando la formación, la experiencia del colaborador y la estrategia organizacional. A continuación, se detallan los enfoques clave, métricas y métodos para medir, validar y mejorar la eficacia de una calificación automatizada dentro del entorno corporativo. 7.1 Validación técnica: precisión, confiabilidad y consistencia El primer nivel de medición de eficacia es técnico. Un sistema de evaluación automatizada debe ser capaz de calificar de forma consistente, precisa y justa. Las métricas clave aquí incluyen: Confiabilidad: ¿El sistema otorga los mismos resultados ante respuestas iguales o similares? La confiabilidad se mide evaluando si el sistema responde de forma uniforme ante diferentes usuarios o en distintos momentos. Exactitud: ¿Califica correctamente según los criterios establecidos? Aquí se recomienda realizar un análisis comparativo entre evaluadores humanos y el algoritmo automático, especialmente en respuestas abiertas. Tasa de error: Porcentaje de ítems que presentan errores de calificación, ya sea por lógica fallida, configuración inadecuada o interpretación incorrecta. Tasa de reintentos necesarios: Si muchos usuarios deben repetir la evaluación varias veces sin justificación pedagógica, puede ser indicio de errores o desalineación entre contenidos y preguntas. Una evaluación automatizada técnicamente errática, por sofisticada que parezca, será ineficaz si no cumple estos mínimos de calidad técnica. 7.2 Alineación con objetivos de aprendizaje y desempeño La eficacia de una evaluación también debe medirse por su capacidad de validar si los objetivos de aprendizaje fueron alcanzados. Esto implica revisar: Concordancia entre preguntas y objetivos de curso: ¿Evalúan lo que realmente se enseñó y se pretendía desarrollar? Cobertura de competencias clave: ¿El sistema califica aspectos críticos como análisis, toma de decisiones, pensamiento estratégico o aplicación práctica, y no solo memorización? Impacto en el desempeño post-evaluación: ¿Los colaboradores que obtienen buenos resultados aplican efectivamente ese conocimiento en su trabajo? Esta medición puede incluir observaciones, entrevistas con supervisores, o comparación de indicadores de productividad antes y después de la formación. Un sistema eficaz no solo mide conocimientos, sino que predice y fortalece el comportamiento en el puesto de trabajo. 7.3 Experiencia del usuario: percepción, claridad y compromiso Una evaluación automatizada no será eficaz si el colaborador no la percibe como útil, clara, justa y alineada con su contexto laboral. La experiencia del usuario impacta directamente en su motivación, compromiso y confianza hacia todo el sistema de formación. Algunas formas de medir este aspecto son: Encuestas de satisfacción post-evaluación: ¿El usuario entendió las preguntas? ¿Sintió que el sistema fue justo? ¿Considera útil el feedback recibido? Tasa de abandono de evaluaciones: Si muchos usuarios interrumpen la evaluación, puede indicar confusión, desmotivación o percepción de irrelevancia. Tiempo promedio por evaluación vs. expectativas de carga cognitiva: Un desfase importante entre ambos indicadores puede señalar problemas de diseño o sobrecarga. Medir la experiencia del usuario es clave para ajustar tanto el diseño técnico como la narrativa pedagógica de las evaluaciones. 7.4 Métricas de aprendizaje y mejora individual Un sistema eficaz no solo califica, sino que genera aprendizaje y promueve la mejora continua. Para ello, se pueden monitorear indicadores como: Progreso entre intentos: ¿Los usuarios que repiten una evaluación mejoran su rendimiento gracias al feedback recibido? Tiempo entre intentos y profundidad de mejora: Un progreso rápido y sostenido entre intentos indica que el sistema promueve el aprendizaje, no la memorización mecánica. Indicadores de retención de conocimiento: Aplicar evaluaciones posteriores o tests de seguimiento para verificar si lo aprendido perdura en el tiempo. La eficacia se mide en qué tan bien la evaluación promueve el aprendizaje, más allá de medirlo. 7.5 Utilidad estratégica: toma de decisiones basada en datos Un sistema de calificación automatizada bien diseñado se convierte en una fuente de inteligencia organizacional, alimentando decisiones sobre talento, formación, promociones, movilidad interna o necesidades de mejora. Para evaluar su utilidad estratégica se debe analizar: Nivel de granularidad de los reportes generados: ¿El sistema permite ver datos por área, sede, cargo, competencia, etc.? Integración con otros sistemas (LMS, TMS, HCM): ¿Los resultados son accionables desde el punto de vista de gestión del talento? Indicadores de impacto organizacional: ¿Los datos de calificación están correlacionados con KPIs de desempeño, retención, satisfacción del cliente o productividad? Si el sistema automatizado entrega información útil, confiable y estratégica, su eficacia trasciende la formación para convertirse en un activo de gestión. 7.6 Retroalimentación inmediata y contextualizada Una característica fundamental de los sistemas automatizados eficaces es su capacidad para entregar feedback de calidad. La eficacia se puede medir también por: Relevancia del feedback: ¿Está personalizado según el error del usuario? Aplicabilidad del feedback: ¿El usuario puede aprender algo nuevo o corregir un error real gracias a la retroalimentación? Accesibilidad del feedback: ¿Puede revisarse después, es claro y está disponible en varios dispositivos o idiomas? El feedback es uno de los principales vectores de aprendizaje. Evaluar su calidad es clave para valorar la eficacia general del sistema. 7.7 Benchmarking interno y externo Comparar el desempeño del sistema con otros similares puede brindar perspectivas valiosas. Esto puede hacerse a través de: Comparación con cohortes anteriores: ¿Ha mejorado el rendimiento global desde que se implementó la calificación automatizada? Benchmarks interempresariales: ¿Cómo se compara la tasa de éxito, eficiencia o retención con otras compañías del sector que usan tecnologías similares? Benchmarking interno entre áreas: ¿Qué unidades obtienen mejores resultados y por qué? ¿Se puede replicar ese modelo? Estos análisis no solo permiten medir eficacia, sino también aprender de buenas prácticas y estandarizarlas.

¿Qué tipo de feedback inmediato puede ofrecer un sistema automatizado?

En la formación corporativa moderna, el feedback ya no es un lujo o un valor agregado: es una expectativa clave del colaborador adulto. Y cuando hablamos de evaluaciones automatizadas, el tipo, calidad y oportunidad del feedback se vuelve uno de los diferenciales más potentes entre una experiencia de aprendizaje mediocre y una experiencia memorable. A diferencia del modelo tradicional, donde un formador entregaba la retroalimentación días después, hoy se espera que el sistema responda en tiempo real, de manera personalizada, accionable y respetuosa. Pero, ¿qué tipo de feedback puede (y debe) ofrecer un sistema automatizado para ser verdaderamente eficaz y valioso en el entorno corporativo? A continuación, se exploran las distintas capas, modalidades y aplicaciones del feedback inmediato automatizado y su impacto directo en la experiencia de aprendizaje y el desarrollo del talento. 8.1 Feedback correctivo básico: inmediato y binario Este es el nivel más básico de feedback automatizado. Se activa justo después de que el usuario responde una pregunta, y le indica si su respuesta fue correcta o incorrecta. Aunque sencillo, es útil cuando: Se está reforzando conocimiento factual o técnico. El usuario requiere certeza rápida sobre su comprensión. Se combina con sistemas que permiten intentos múltiples. Sin embargo, su utilidad se ve limitada si no se acompaña de información explicativa o enriquecida. 8.2 Feedback explicativo o instruccional Aquí, el sistema no solo dice si la respuesta fue correcta o incorrecta, sino que explica por qué, brindando información pedagógica que ayuda al usuario a aprender. Este tipo de feedback puede incluir: Una justificación detallada. Reglas o conceptos relacionados. Ejemplos adicionales que ilustran el error o la respuesta correcta. Este tipo de retroalimentación es especialmente poderoso para reforzar conceptos clave, evitar errores futuros y promover una comprensión profunda. 8.3 Feedback adaptativo según desempeño Uno de los mayores avances en calificación automatizada es la capacidad de adaptar el feedback según el perfil del usuario o su historial. Esto puede incluir: Sugerencias diferentes según el número de errores cometidos. Rutas de contenido personalizado sugeridas con base en la respuesta. Enlaces a recursos complementarios específicos según el tipo de error cometido. Esta adaptabilidad convierte al sistema en un mentor digital, y no solo en un calificador automático. 8.4 Feedback formativo acumulativo En lugar de ofrecer retroalimentación solo ítem por ítem, algunos sistemas entregan un feedback global al final de la evaluación, incluyendo: Un resumen de fortalezas y áreas de mejora. Gráficas comparativas con cohortes o estándares. Rutas recomendadas de aprendizaje adicionales. Este tipo de feedback transforma la evaluación en un punto de partida para el desarrollo, más que en una simple medición. 8.5 Feedback basado en competencias Los sistemas avanzados permiten mapear cada pregunta con una o varias competencias clave. Al finalizar, el sistema puede generar un perfil de competencias del usuario, indicando: Nivel de dominio por competencia. Competencias no alcanzadas y nivel de brecha. Recomendaciones específicas por eje competencial. Esto es particularmente útil para planes de desarrollo individuales, rutas de upskilling y decisiones de talento. 8.6 Feedback visual e interactivo No todo el feedback debe ser textual. Las plataformas actuales permiten representar la retroalimentación mediante: Dashboards con progreso visual. Indicadores por colores (verde: dominado; amarillo: en desarrollo; rojo: por trabajar). Animaciones, badges, barras de progreso y logros. Este tipo de feedback mejora la comprensión, motiva al usuario y refuerza el engagement con el proceso de formación. 8.7 Feedback con gamificación En contextos de formación lúdica, el feedback puede integrarse a mecánicas de juego, ofreciendo: Puntos ganados o perdidos. Niveles desbloqueados. Feedback humorístico o motivacional contextualizado. Esta modalidad es altamente motivadora y convierte el error en parte natural del juego, reduciendo la ansiedad y aumentando la persistencia. 8.8 Feedback ético y constructivo Aunque automatizado, el feedback debe cuidar el tono y el lenguaje utilizado. Un error común en sistemas automatizados es ofrecer respuestas robóticas, impersonales o incluso desalentadoras. Los mejores sistemas están diseñados para: Utilizar lenguaje positivo y constructivo. Evitar juicios de valor. Reconocer el esfuerzo, no solo el resultado. Esto fortalece la motivación intrínseca del usuario y mejora su experiencia emocional.

¿Qué plataformas líderes ofrecen herramientas de calificación automatizada?

En el entorno empresarial actual, la digitalización de la formación y la evaluación ya no es una opción, sino una obligación estratégica para organizaciones que desean mantenerse competitivas, ágiles y centradas en el desarrollo del talento. Una pieza clave en este ecosistema son las plataformas que integran sistemas de calificación automatizada, capaces de evaluar a gran escala, ofrecer feedback inmediato, y generar datos accionables para la toma de decisiones. Pero con la proliferación de plataformas LMS (Learning Management Systems), LXP (Learning Experience Platforms) y plataformas híbridas, la pregunta que enfrentan los líderes de RRHH y Tecnología es cada vez más compleja: ¿cuáles son las plataformas líderes que ofrecen herramientas de evaluación automatizada robustas, confiables y alineadas con las necesidades corporativas? A continuación, se presenta un análisis detallado de las principales plataformas del mercado, sus capacidades de evaluación automatizada y sus ventajas diferenciales para el entorno corporativo. 9.1 Moodle (con plugins avanzados) Moodle, siendo una plataforma de código abierto, es una de las opciones más versátiles y robustas para la calificación automatizada, especialmente cuando se le potencia con plugins. Características destacadas: Evaluaciones objetivas: cuestionarios con más de 15 tipos de preguntas (múltiple opción, respuesta corta, emparejamiento, etc.). Feedback inmediato y condicional. Rúbricas automatizadas y guías de evaluación integradas. Plugins como STACK (para matemáticas), Essay (con IA), y H5P (para evaluaciones interactivas). Exportación de resultados y analíticas detalladas. Escalabilidad y personalización casi ilimitadas. Ideal para organizaciones con equipos técnicos internos o partners especializados en Moodle. 9.2 SAP SuccessFactors Learning Parte de la suite SAP, esta plataforma está diseñada para grandes empresas que requieren integración total entre formación, gestión del desempeño y desarrollo del talento. Características destacadas: Evaluaciones automáticas con lógica condicional. Vinculación directa con objetivos de desempeño y competencias. Feedback automatizado y configurable. Analítica de aprendizaje en tiempo real, integrada con SAP Analytics Cloud. Posibilidad de integrarse con herramientas de autor como Articulate o Captivate. Ventaja estratégica: permite vincular el aprendizaje con métricas organizacionales, ofreciendo una visión holística del desarrollo de cada colaborador. 9.3 Docebo Plataforma de eLearning basada en inteligencia artificial, diseñada para ofrecer experiencias de aprendizaje personalizadas y centradas en el usuario. Características destacadas: Evaluaciones automáticas y adaptativas. Uso de IA para personalizar contenido y rutas formativas. Feedback inteligente y sistema de scoring automatizado. Integración con plataformas de autor y CRM. Dashboards personalizables y analítica avanzada. Ideal para organizaciones que buscan una experiencia moderna, escalable y con fuerte foco en personalización. 9.4 Cornerstone OnDemand Uno de los LMS corporativos más consolidados del mercado global. Su fortaleza radica en la integración entre formación, desempeño y sucesión. Características destacadas: Evaluaciones automáticas configurables por rol, nivel o ubicación. Rúbricas digitales personalizables. Feedback inmediato, rutas de mejora sugeridas y conexión con metas individuales. Reportes detallados por competencias, habilidades y gaps organizacionales. Ventaja competitiva: la evaluación forma parte de un ecosistema completo de talento, con visión 360° del colaborador. 9.5 TalentLMS Una de las plataformas más utilizadas en empresas pequeñas y medianas por su usabilidad, rapidez de implementación y escalabilidad. Características destacadas: Evaluaciones automáticas integradas en los cursos. Tipos variados de preguntas, feedback en tiempo real y control de intentos. Banco de preguntas y aleatorización. Integración con SCORM, xAPI y sistemas de autor externos. Es ideal para organizaciones con recursos limitados que buscan una solución eficaz y accesible. 9.6 Blackboard Learn Aunque inicialmente orientada al ámbito educativo, muchas corporaciones utilizan Blackboard por su robustez técnica y posibilidades evaluativas. Características destacadas: Evaluaciones con lógica avanzada, condiciones de acceso y retroalimentación inteligente. Rúbricas digitales detalladas y reporting por resultados. Evaluaciones por competencias. Integración con plataformas de autor y herramientas externas. Atractiva para organizaciones con fuerte enfoque en formación académica interna o programas de certificación complejos. 9.7 EdApp (by SafetyCulture) Una plataforma LXP móvil-first con enfoque en microlearning y evaluación rápida. Características destacadas: Cuestionarios automáticos altamente visuales. Feedback gamificado e instantáneo. Análisis de datos de aprendizaje granular. Ideal para operativos, frontlines y equipos con poco tiempo de formación. Su diferencial radica en accesibilidad, experiencia de usuario móvil y facilidad de creación de contenidos. 9.8 LearnUpon Plataforma robusta, especialmente orientada a empresas que capacitan tanto a empleados como a clientes y partners. Características destacadas: Evaluaciones automatizadas con feedback inmediato. Compatibilidad con SCORM, AICC, xAPI. Reportes comparativos por grupos, roles o departamentos. API abierta para integración con CRM o ERP. Es ideal para ecosistemas empresariales amplios que necesitan escalar la formación hacia audiencias internas y externas. 9.9 Google Classroom + Formularios (entornos híbridos) Aunque no es una plataforma LMS corporativa tradicional, muchas organizaciones pequeñas utilizan esta combinación para evaluaciones automatizadas. Características destacadas: Formularios con calificación automática y retroalimentación instantánea. Dashboards integrados con Google Sheets. Facilidad de uso, cero costo, y disponibilidad multiplataforma. Útil para capacitaciones internas, rápidas o de bajo presupuesto. 9.10 Clasificación y selección según necesidad organizacional No existe una “plataforma ideal” universal. La elección depende de variables clave: Tamaño de la organización. Nivel de madurez digital del equipo formativo. Necesidad de integración con sistemas de gestión del talento. Tipo de contenido y nivel de personalización requerido. Presupuesto disponible y costo de mantenimiento. Una organización con alta rotación y foco en cumplimiento normativo necesitará una plataforma distinta a otra enfocada en desarrollo de liderazgo o programas de innovación.

¿Cómo puede evolucionar el perfil del evaluador con la automatización?

La automatización de la calificación, lejos de reemplazar al evaluador humano, está catalizando una profunda transformación en su rol, competencias, responsabilidades y valor estratégico dentro de la organización. Si antes el evaluador era visto como una figura técnica centrada en la corrección de pruebas y la aplicación de instrumentos, hoy está llamado a convertirse en un diseñador de experiencias de aprendizaje, un curador de calidad evaluativa y un analista estratégico del talento. Esta evolución, acelerada por la irrupción de plataformas de eLearning, IA, big data y modelos de evaluación automatizada, redefine completamente qué significa evaluar en el siglo XXI. Para los líderes de RRHH, Formación y Tecnología, comprender esta evolución no es solo un ejercicio conceptual, sino una guía práctica para rediseñar perfiles, formar equipos e incorporar talento adecuado para una nueva era del aprendizaje organizacional. A continuación, se detalla cómo cambia el perfil del evaluador y qué habilidades debe adquirir para mantenerse relevante y valioso. 10.1 De calificador a diseñador de instrumentos automatizables El nuevo evaluador ya no se limita a aplicar una prueba. Ahora debe diseñar evaluaciones que puedan ser entendidas y ejecutadas por una máquina, lo que implica: Redactar preguntas claras, objetivas y alineadas con objetivos de aprendizaje. Crear rúbricas digitales que traduzcan criterios cualitativos en parámetros cuantificables. Anticipar errores comunes y estructurar feedback automatizado pertinente. Esta tarea requiere pensamiento sistémico, conocimiento instruccional y dominio de las herramientas tecnológicas que permitirán la automatización. 10.2 De corrector a estratega de competencias En lugar de evaluar si alguien “aprueba o no”, el nuevo evaluador analiza en qué competencias destaca el colaborador y cuáles debe desarrollar. La evaluación automatizada genera grandes volúmenes de datos, y el evaluador debe: Interpretar dashboards y analíticas. Detectar patrones, brechas y oportunidades de mejora. Construir rutas formativas personalizadas a partir de los resultados. Este nuevo enfoque convierte al evaluador en un aliado estratégico para áreas como desarrollo organizacional, movilidad interna y gestión del talento. 10.3 De ejecutor a integrador tecnológico-pedagógico Con la automatización, el evaluador debe actuar como puente entre los equipos técnicos (TI, data, IA) y los equipos de formación. Esto implica: Comprender los principios básicos de la tecnología que sustenta la evaluación (algoritmos, procesamiento de lenguaje natural, analítica). Comunicar necesidades pedagógicas en lenguaje técnico y viceversa. Participar activamente en la selección, configuración y optimización de plataformas evaluativas. Este rol híbrido exige pensamiento colaborativo, adaptabilidad y visión transversal. 10.4 De revisor a facilitador del aprendizaje El evaluador ya no es un “policía del error”, sino un facilitador del desarrollo. Utiliza la evaluación como punto de partida para acompañar al colaborador en su ruta de aprendizaje. Esto incluye: Interpretar resultados con el colaborador. Co-construir planes de mejora. Generar espacios de reflexión sobre el desempeño. Este enfoque humaniza el proceso y fortalece el compromiso del talento con su crecimiento. 10.5 Nuevas competencias clave del evaluador moderno La evolución del perfil del evaluador requiere el desarrollo de nuevas competencias: Pensamiento analítico y uso de datos. Alfabetización digital y dominio de herramientas de autor. Conocimiento de modelos de competencias y taxonomías cognitivas. Capacidad de diseño instruccional basado en evidencia. Comunicación clara y empática, tanto en entornos presenciales como virtuales. Estas habilidades deben ser parte de los procesos de formación y selección de quienes asuman esta nueva función. 10.6 Nuevos roles emergentes relacionados En este nuevo paradigma, surgen también roles especializados derivados del antiguo perfil de evaluador: Arquitecto de evaluación digital: enfocado en diseño técnico y pedagógico de sistemas automatizados. Analista de datos formativos: especializado en interpretar datos de evaluación para la toma de decisiones. Curador de calidad evaluativa: responsable de garantizar la validez, confiabilidad y alineación de las evaluaciones. Estas nuevas funciones requieren una combinación de expertise educativo, tecnológico y estratégico. 🧾 Resumen Ejecutivo En un contexto empresarial marcado por la transformación digital, la automatización de procesos no es una moda, sino una necesidad para escalar operaciones, optimizar tiempos y garantizar calidad. En el ámbito del eLearning corporativo, la calificación automatizada emerge como una herramienta crítica no solo para evaluar conocimientos, sino para impulsar la productividad, personalizar el aprendizaje y tomar decisiones basadas en datos confiables. Este artículo ha explorado en profundidad diez aspectos fundamentales de la calificación automatizada, con un enfoque en su impacto en la estrategia de talento. A continuación, se resumen los hallazgos más relevantes y cómo estos se traducen en oportunidades para organizaciones que utilizan soluciones como WORKI 360. ✅ 1. Infraestructura tecnológica potente Los sistemas de calificación automatizada más avanzados se apoyan en tecnologías de vanguardia como inteligencia artificial, machine learning, procesamiento de lenguaje natural, algoritmos adaptativos y visión computacional. Plataformas modernas permiten no solo calificar, sino también interpretar el desempeño, detectar patrones y adaptar rutas formativas en tiempo real. WORKI 360 puede integrar estas tecnologías de forma modular, adaptándose al nivel de madurez digital de cada organización y ofreciendo escalabilidad progresiva sin comprometer calidad evaluativa. ✅ 2. Evaluación alineada con objetivos del negocio La eficacia de una evaluación automatizada no radica en calificar rápido, sino en calificar lo que realmente importa. La alineación entre objetivos de aprendizaje y criterios de evaluación es esencial. Solo así se garantiza que los resultados obtenidos sean útiles para la toma de decisiones en desarrollo, promoción o formación adicional. WORKI 360 permite mapear cada evaluación a competencias organizacionales, garantizando trazabilidad y coherencia pedagógica con los objetivos estratégicos de talento. ✅ 3. Retroalimentación inmediata que impulsa la mejora El feedback inmediato, adaptativo y contextualizado transforma la evaluación en un proceso formativo y motivador. Los sistemas más eficaces no solo califican, sino que enseñan, guían y empoderan al colaborador. Las funcionalidades de feedback de WORKI 360, basadas en IA, permiten entregar sugerencias personalizadas, activar rutas de mejora automática y mantener al colaborador comprometido con su desarrollo. ✅ 4. Reducción de sesgos y aumento de la objetividad Cuando está bien diseñada, la calificación automatizada reduce los sesgos humanos, mejora la equidad en la evaluación y aumenta la percepción de justicia organizacional. Esto es clave para fortalecer culturas meritocráticas. WORKI 360 puede operar con rúbricas digitales auditables, asegurando transparencia, consistencia y cumplimiento normativo, especialmente útil en contextos de certificaciones o cumplimiento interno. ✅ 5. Eficiencia operativa y ahorro de tiempo Automatizar la calificación libera recursos humanos valiosos, reduce los tiempos de respuesta y permite evaluar a grandes volúmenes de colaboradores simultáneamente sin comprometer la calidad. Con WORKI 360, es posible configurar evaluaciones escalables que se replican en toda la organización, con generación automática de reportes y dashboards para la toma de decisiones ejecutivas. ✅ 6. Ecosistema de plataformas líderes e integrables Las plataformas más destacadas —como Moodle, Docebo, SAP SuccessFactors, Cornerstone, TalentLMS o Blackboard— ofrecen robustas herramientas de evaluación automatizada. Sin embargo, su verdadero potencial se libera al integrarse con sistemas de talento, BI y plataformas de formación internas. WORKI 360 actúa como hub de integración, conectando evaluaciones automatizadas con sistemas de desempeño, planes de carrera, sucesión y learning analytics, permitiendo una gestión 360 del talento. ✅ 7. Nuevos perfiles profesionales y evolución del evaluador Con la automatización, el rol del evaluador evoluciona hacia un diseñador instruccional estratégico, un curador de datos de aprendizaje y un facilitador del desarrollo humano. Ya no corrige pruebas, sino que diseña experiencias de evaluación automatizables y acciona mejoras. WORKI 360 proporciona las herramientas necesarias para empoderar a estos nuevos perfiles, facilitando el diseño de evaluaciones inteligentes, alineadas y estratégicas. ✅ 8. Métricas claras para medir la eficacia de la evaluación Desde la precisión técnica hasta el impacto en el desempeño, existen múltiples indicadores para medir la eficacia de una evaluación automatizada: confiabilidad, alineación, engagement del usuario, mejora entre intentos, utilidad para la toma de decisiones, entre otros. Los dashboards de WORKI 360 ofrecen visualizaciones en tiempo real sobre la eficacia evaluativa, ayudando a líderes a identificar qué funciona, qué debe ajustarse y cómo mejorar continuamente los procesos formativos. ✅ 9. Cultura de mejora continua y auditoría permanente El verdadero valor de la automatización no está solo en la primera implementación, sino en su capacidad de evolucionar. Requiere monitoreo constante, detección de errores, feedback de usuarios y ajustes pedagógicos periódicos. WORKI 360 incluye flujos de validación, revisión y actualización de ítems, garantizando un sistema vivo, que aprende de sus usuarios y mejora con el tiempo. ✅ 10. Motivación del colaborador y experiencia personalizada Una evaluación bien automatizada no es fría ni impersonal. Cuando se diseña con enfoque humano, aumenta la motivación, refuerza el compromiso, y transforma al colaborador en protagonista de su aprendizaje. WORKI 360 ha sido diseñado con foco en experiencia de usuario, utilizando gamificación, personalización y feedback constructivo para garantizar una experiencia formativa positiva, autónoma y centrada en el crecimiento.