Índice del contenido

¿Qué impacto tiene el streaming de video en las pruebas de carga LMS?

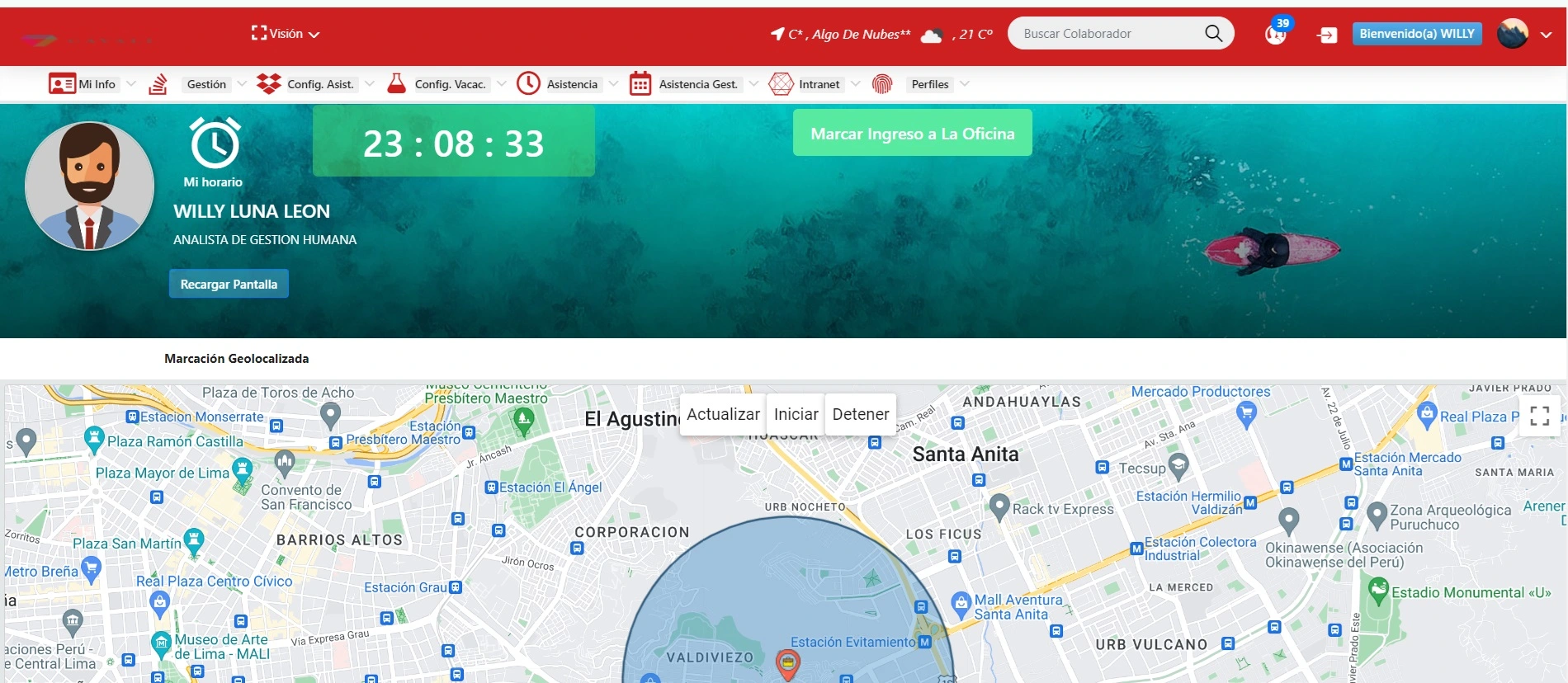

El streaming de video representa uno de los elementos más desafiantes para cualquier plataforma de gestión del aprendizaje (LMS), especialmente cuando hablamos de pruebas de carga. Para un director de tecnología o un gerente de formación, comprender su impacto no solo es esencial para asegurar la continuidad del aprendizaje, sino para garantizar que las decisiones de infraestructura, licenciamiento, escalabilidad y experiencia del usuario estén alineadas con los objetivos estratégicos de la organización. La razón es simple: el contenido audiovisual es uno de los recursos más demandados en cualquier experiencia eLearning moderna. Instrucciones grabadas, webinars, simulaciones interactivas, tutoriales paso a paso, todos estos formatos se han convertido en el corazón de la capacitación digital. Sin embargo, el costo técnico que implican es alto. A diferencia de otros recursos como PDFs, SCORM o cuestionarios, el streaming requiere un ancho de banda constante, baja latencia y una infraestructura robusta que soporte múltiples conexiones simultáneas. Uno de los principales impactos que se observa en pruebas de carga LMS cuando se incorpora video streaming es el incremento abrupto en el uso del ancho de banda. Si una organización planea lanzar una jornada de capacitación con 500 colaboradores viendo simultáneamente un video de alta definición, el tráfico en la red puede multiplicarse exponencialmente. Esta demanda puede colapsar la infraestructura del LMS si no ha sido diseñada, probada y optimizada para escenarios de este tipo. Por eso, durante las pruebas de carga, el streaming debe considerarse como una de las variables más críticas. Las pruebas deben simular cientos o miles de usuarios accediendo al contenido audiovisual al mismo tiempo, desde distintas ubicaciones geográficas, con diferentes niveles de conectividad. Esto permitirá medir el verdadero rendimiento de la plataforma, identificar cuellos de botella y, lo más importante, anticiparse a interrupciones durante jornadas clave de formación. Otro impacto relevante es el aumento del consumo de recursos del servidor. Si el video es alojado directamente en el LMS (en lugar de utilizar un CDN o una plataforma externa como Vimeo, YouTube o Brightcove), el servidor debe encargarse de procesar cada solicitud, lo cual implica un alto consumo de CPU, RAM y espacio de almacenamiento. Esto hace que las pruebas de carga revelen caídas en el rendimiento general del LMS, especialmente en escenarios de concurrencia alta. A menudo, los picos de uso coinciden con horas laborales clave o capacitaciones obligatorias, por lo que un fallo en este momento puede traducirse en pérdida de productividad, frustración del usuario e incluso riesgos legales si el contenido tiene carácter obligatorio. El impacto también se extiende a la experiencia del usuario. Un LMS que no gestiona correctamente el streaming bajo carga puede generar buffering, errores de reproducción, caídas de sesión y tiempos de espera excesivos. Estos factores afectan la percepción del usuario sobre la calidad del sistema y disminuyen el compromiso con los procesos de aprendizaje. Para un gerente de recursos humanos o de formación, esto significa tener que lidiar con reportes de usuarios insatisfechos, bajas tasas de finalización de cursos, e incluso disminución en los resultados de aprendizaje esperados. Ahora bien, no todo son problemas: también hay oportunidades que emergen si se gestiona adecuadamente el impacto del streaming en las pruebas de carga. Una de ellas es la posibilidad de optimizar la arquitectura del LMS integrando servicios especializados de distribución de video mediante CDNs (Content Delivery Networks). Esto permite que los videos se sirvan desde servidores ubicados estratégicamente alrededor del mundo, disminuyendo la carga sobre el LMS central y mejorando los tiempos de respuesta en regiones alejadas del servidor principal. Otro aspecto estratégico que se puede descubrir durante las pruebas de carga es el momento óptimo de entrega de los contenidos. Es decir, si se observa que los mayores cuellos de botella ocurren en horas específicas, se pueden tomar decisiones como escalonar los accesos, distribuir el contenido en diferentes horarios o implementar mecanismos de caching para mitigar el impacto en la infraestructura. Por último, es importante resaltar que el impacto del streaming en las pruebas de carga también puede ser una fuente de innovación. Muchas organizaciones, a partir de estos ejercicios, descubren que pueden evolucionar hacia modelos de microlearning, en donde los videos son más cortos, están mejor segmentados y se cargan con menor peso, lo cual no solo mejora el rendimiento técnico del LMS, sino que también potencia la efectividad del aprendizaje.

¿Qué consideraciones técnicas deben evaluarse antes de implementar un LMS a gran escala?

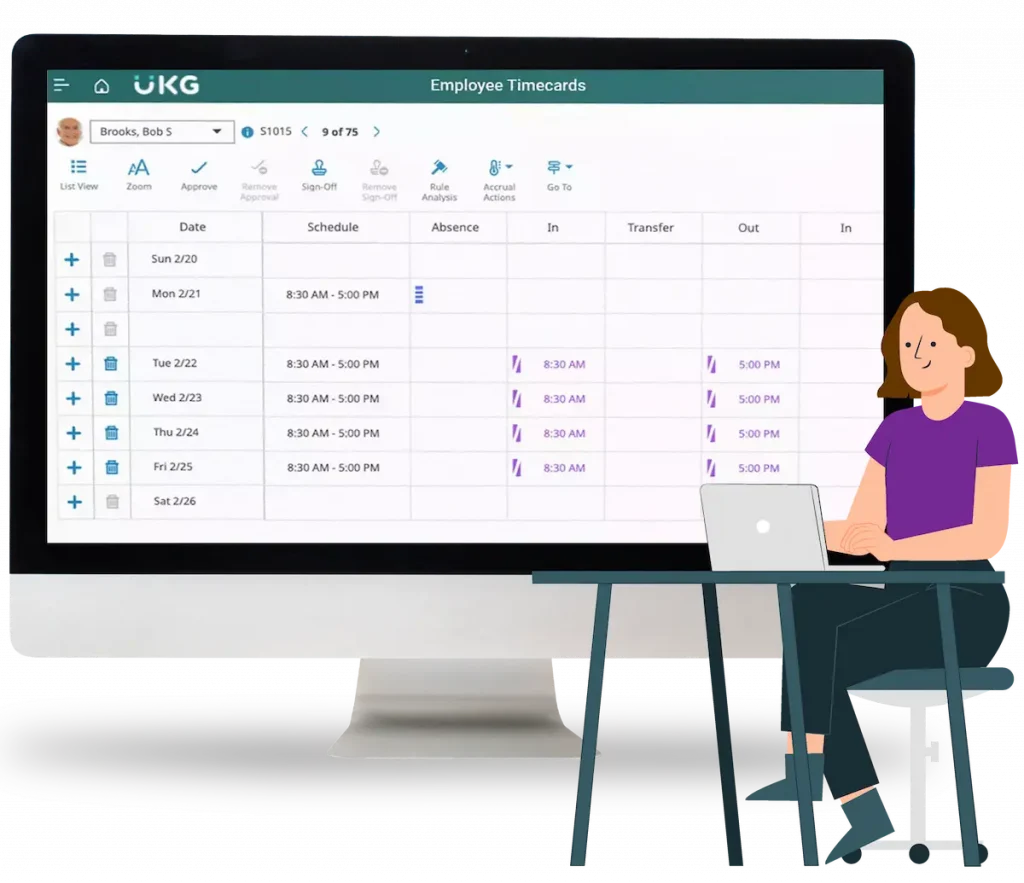

Implementar un LMS (Learning Management System) a gran escala no es simplemente una cuestión de instalar un software y cargar algunos cursos. Implica una profunda planificación técnica, estratégica y operativa que asegure la escalabilidad, seguridad, rendimiento y sostenibilidad del sistema. Para líderes de TI y ejecutivos de formación corporativa, esto representa una de las decisiones tecnológicas más significativas, pues de ello depende la experiencia de aprendizaje de miles de usuarios, la productividad de equipos y la eficacia del desarrollo del talento en toda la organización. Antes de tomar cualquier decisión de implementación masiva, se deben evaluar al menos diez dimensiones técnicas fundamentales que determinarán el éxito del proyecto. 1. Capacidad de Escalabilidad del LMS: Una plataforma que funciona correctamente con 50 usuarios puede colapsar con 500 o 5000 si no fue diseñada para escalar. Es vital entender cómo responde el LMS al crecimiento. ¿Permite balanceo de carga? ¿Puede adaptarse automáticamente al aumento de tráfico mediante escalamiento horizontal o vertical? ¿Es modular? Estas preguntas son esenciales para evitar que el sistema se vuelva obsoleto o ineficiente conforme la organización crece. 2. Arquitectura Tecnológica y Tipo de Implementación (SaaS vs. On-Premise): La elección entre un LMS SaaS (Software as a Service) y uno On-Premise tendrá repercusiones profundas en costos, mantenimiento, seguridad y flexibilidad. SaaS ofrece simplicidad y velocidad, pero puede tener limitaciones en personalización. On-Premise otorga mayor control, pero requiere inversión en infraestructura y equipos de soporte. Evaluar la madurez tecnológica interna, las políticas de compliance y las necesidades de integración es crucial. 3. Integración con Sistemas Existentes: Una implementación a gran escala no puede vivir en una burbuja. El LMS debe integrarse con el ERP, sistema de recursos humanos, directorios activos (LDAP, Azure AD), plataformas de videoconferencia, BI, CRM y otros sistemas corporativos. Las APIs disponibles, la calidad de la documentación técnica, los estándares de interoperabilidad (como SCORM, xAPI, LTI) y la experiencia del equipo técnico del proveedor juegan un papel clave aquí. 4. Seguridad y Cumplimiento Normativo: ¿El LMS cumple con normativas como GDPR, ISO 27001, SOC 2 o leyes locales de protección de datos? ¿Ofrece autenticación multifactor? ¿Auditoría de accesos? A gran escala, un solo incidente de seguridad puede representar una crisis reputacional, financiera y legal. Por tanto, antes de implementar, se debe realizar una auditoría de ciberseguridad y establecer políticas claras de protección de datos. 5. Rendimiento y Pruebas de Carga: Antes de la implementación definitiva, es necesario realizar simulaciones de alto tráfico que permitan medir el rendimiento real del sistema. Estas pruebas deben considerar acceso simultáneo, ejecución de cursos, subida de tareas, reproducción de video, emisión de certificados, entre otros. El objetivo es identificar puntos débiles antes del despliegue final. 6. Experiencia de Usuario y Usabilidad Multidispositivo: La interfaz del LMS debe ser intuitiva, adaptativa y compatible con dispositivos móviles. La accesibilidad (WCAG) también debe ser considerada, especialmente en organizaciones con políticas inclusivas. Un LMS complejo o difícil de usar puede generar rechazo y baja adopción, incluso si su back-end es tecnológicamente sólido. 7. Disponibilidad, Redundancia y Tolerancia a Fallos: ¿El LMS garantiza uptime del 99.9%? ¿Qué sucede si cae el servidor principal? ¿Existe redundancia geográfica? A nivel corporativo, no hay margen para interrupciones prolongadas, especialmente si el LMS está ligado a cumplimiento normativo o formación crítica para operaciones. 8. Analítica y Reporting en Tiempo Real: Un LMS debe ofrecer dashboards ejecutivos, métricas clave (KPIs), trazabilidad del aprendizaje y posibilidad de exportar datos para análisis avanzado. Los reportes no son solo para ver quién terminó un curso, sino para tomar decisiones de talento basadas en datos. Esto exige motores de analítica robustos y personalizables. 9. Costos Totales de Propiedad (TCO) y Licenciamiento: Más allá del precio inicial, se deben considerar los costos ocultos: mantenimiento, soporte, actualizaciones, capacitaciones, consultoría, integraciones personalizadas. Un LMS con bajo costo inicial puede convertirse en un pozo de gastos si no se evalúa bien el modelo de negocio del proveedor. 10. Soporte Técnico y Evolutividad del Proveedor: ¿El proveedor tiene experiencia en implementaciones de tamaño similar? ¿Ofrece soporte 24/7? ¿Publica roadmaps de evolución tecnológica? Implementar un LMS es una relación a largo plazo, no un proyecto puntual. Es fundamental evaluar la madurez, solvencia y visión futura del proveedor.

¿Cómo deben reaccionar los equipos de TI ante los resultados negativos de una prueba de carga?

Los resultados negativos en una prueba de carga de un sistema LMS no son una señal de fracaso, sino una poderosa llamada de atención. Para un equipo de TI con visión estratégica, estos resultados representan una valiosa oportunidad para ajustar, reforzar y optimizar la arquitectura del sistema antes de que ocurra un colapso real. Pero la reacción del equipo ante estos resultados marca la diferencia entre una organización resiliente y una que reacciona tarde, enfrentando interrupciones críticas en sus procesos de aprendizaje. El primer paso que debe asumir un equipo de TI es la interpretación técnica y contextual de los datos. Una prueba de carga no solo muestra si el sistema falló, sino dónde, cuándo, cómo y bajo qué condiciones específicas. El equipo debe desglosar los resultados: ¿el problema fue de latencia?, ¿hubo errores de base de datos?, ¿se alcanzaron los límites del servidor?, ¿hubo cuellos de botella en la red?, ¿qué módulos del LMS se vieron más afectados? Este diagnóstico técnico es clave para convertir un resultado negativo en un plan de acción concreto. Una mala práctica común es caer en el pánico o el alarmismo sin un análisis sistemático. El liderazgo de TI debe evitar la tentación de atribuir los resultados a factores externos o asumir que se trata de un falso positivo. Si la prueba estuvo bien diseñada, representa el comportamiento potencial del sistema en situaciones reales. Negar la validez del test o minimizar sus resultados puede ser catastrófico si se lanza una campaña de formación masiva y el LMS colapsa bajo la carga. El segundo paso es establecer prioridades basadas en impacto y urgencia. No todos los fallos son iguales. Algunos afectan la experiencia del usuario (como tiempos de carga lentos), otros comprometen la operación (como fallos en el acceso), y otros afectan la seguridad (como caídas que exponen vulnerabilidades). El equipo debe clasificar cada hallazgo según su criticidad y crear una matriz de priorización. Esto permite evitar el clásico error de dedicar tiempo y recursos a resolver problemas menores mientras se ignoran cuellos de botella graves. Una vez priorizados los problemas, llega el momento de la acción: planificación de mejoras estructurales, refactorización de código, optimización de infraestructura o reconfiguración de servicios externos. Aquí es crucial que el equipo de TI trabaje de manera colaborativa con otras áreas: desarrollo, QA, DevOps, incluso seguridad y proveedores de nube. Las pruebas de carga exitosas son multidisciplinarias. Si el problema es de base de datos, el equipo DBA debe involucrarse. Si el cuello de botella es la red, el área de infraestructura debe liderar. Y si el LMS es gestionado por un tercero, se debe establecer un canal formal y ágil de soporte con SLA exigente. Otra reacción fundamental es la documentación y socialización de los resultados. Un buen equipo de TI no guarda los resultados de una prueba de carga en una carpeta olvidada. Se deben generar informes ejecutivos claros, traduciendo los hallazgos técnicos a un lenguaje comprensible para gerentes, áreas usuarias y dirección. ¿Qué implican esos resultados en términos de continuidad operativa? ¿Cuál es el riesgo real si no se actúa? ¿Qué inversión se requiere para solucionar los problemas detectados? Esta documentación fortalece la toma de decisiones y facilita la aprobación de presupuestos o recursos necesarios. En paralelo, el equipo debe reforzar sus capacidades internas. Un resultado negativo puede revelar no solo problemas del sistema, sino carencias en la propia metodología del equipo. Quizás las pruebas fueron insuficientes en el pasado. Quizás no existía un entorno de staging confiable. Tal vez el LMS fue instalado sin consideraciones de escalabilidad desde el inicio. En estos casos, la reacción correcta es implementar una política más robusta de pruebas periódicas, entrenar al equipo en técnicas avanzadas de performance testing y establecer un plan de mejora continua que convierta la debilidad actual en una fortaleza futura. Además, el equipo de TI debe prever el impacto comunicacional. Si los resultados negativos son graves y requieren intervención en el sistema productivo, se debe preparar una estrategia de comunicación con usuarios internos: avisos de mantenimiento, mensajes claros sobre la naturaleza de los ajustes, tiempos estimados y garantías de mejora. Esto reduce la ansiedad, mantiene la transparencia y refuerza la confianza en el equipo técnico. En casos extremos, los resultados negativos pueden indicar la necesidad de un cambio profundo en la arquitectura del LMS. Si el sistema simplemente no está preparado para escalar, es monolítico, tiene tecnología obsoleta o depende de proveedores limitantes, entonces el equipo de TI debe elevar la discusión a nivel estratégico. Esto podría implicar migrar hacia una arquitectura basada en microservicios, mover el LMS a la nube, cambiar de proveedor o incluso rediseñar todo el entorno digital de aprendizaje. Estas decisiones no se toman a la ligera, pero una prueba de carga fallida puede ser el catalizador necesario para tomar el camino correcto. Finalmente, un equipo de TI maduro debe incorporar los resultados negativos como insumo para la mejora continua y la innovación. No se trata solo de resolver los problemas detectados, sino de fortalecer la resiliencia organizacional frente a futuras demandas. Por ejemplo, a partir de los hallazgos se pueden definir nuevos umbrales de alerta, automatizar monitoreos en tiempo real, establecer escenarios de prueba más realistas e incluso simular picos de uso por área, región o tipo de curso.

¿Qué tan frecuente se deben realizar las pruebas de carga en un LMS en producción?

Establecer la frecuencia adecuada para realizar pruebas de carga en un LMS en producción es una decisión estratégica que influye directamente en la estabilidad operativa, la capacidad de respuesta ante eventos críticos y la experiencia del usuario final. Para los líderes de tecnología, recursos humanos y formación, esta no es solo una pregunta técnica, sino una cuestión de gestión de riesgos y garantía de calidad continua. La respuesta ideal no es un número fijo, sino una frecuencia dinámica basada en contexto, uso y evolución tecnológica del entorno LMS. Sin embargo, existen criterios generales y prácticas recomendadas que permiten establecer una periodicidad razonable, flexible y adaptativa. Como regla de oro, se recomienda realizar pruebas de carga al menos una vez cada seis meses. Este es el mínimo que una organización debería considerar si el LMS es parte esencial de sus operaciones de capacitación interna o formación externa. Este tipo de prueba semestral permite establecer una línea base, comparar resultados con períodos anteriores y anticipar cuellos de botella antes de que se manifiesten en momentos de alta demanda. No obstante, este intervalo debe acortarse significativamente en ciertos escenarios específicos. Por ejemplo, antes de cualquier evento planificado de alto tráfico, como: Lanzamiento de un programa de onboarding masivo Inicio de un ciclo formativo corporativo obligatorio Implementación de una certificación externa con límite de fechas Jornadas de entrenamiento para clientes o socios estratégicos En estos casos, se deben realizar pruebas al menos cuatro semanas antes del evento, permitiendo así aplicar ajustes técnicos con tiempo suficiente. Esperar al último momento para validar la carga puede ser un error costoso, tanto en términos financieros como reputacionales. También es necesario realizar pruebas de carga cada vez que se produzcan cambios estructurales en el LMS o en su ecosistema tecnológico, tales como: Actualizaciones mayores de versión del LMS Migración de hosting o cambio de infraestructura (servidores, nube) Nuevas integraciones con plataformas externas (BI, SSO, ERPs) Incorporación de contenidos audiovisuales en gran volumen Personalización de módulos críticos del sistema En estos casos, la prueba de carga no solo sirve para validar que el sistema responde bien a la nueva carga, sino para identificar posibles efectos colaterales de los cambios. Muchas veces, pequeños ajustes en el código o en los módulos pueden desencadenar efectos dominó en el rendimiento, especialmente bajo presión. En entornos altamente regulados o con estándares de calidad exigentes (por ejemplo, instituciones educativas certificadas, empresas ISO o industrias reguladas como la farmacéutica o financiera), la prueba de carga debe formar parte de un protocolo recurrente de calidad. En estos casos, trimestralmente o incluso mensualmente, dependiendo del uso intensivo del sistema, es el estándar aceptable. Además, estas pruebas pueden ser requeridas como parte de auditorías internas o externas. Otra dimensión importante es la monitorización constante. Un LMS moderno debe contar con herramientas de observabilidad, analítica de rendimiento y detección de anomalías. Si estas herramientas detectan degradaciones en los KPIs principales (tiempos de carga, uso de CPU, tasa de errores), esto puede disparar una prueba de carga reactiva, incluso si no está en el calendario. Es decir, la prueba de carga debe ser capaz de activarse tanto por plan como por condición. Esta flexibilidad es clave en entornos complejos y cambiantes. Por último, una tendencia emergente en organizaciones avanzadas es la automatización parcial de las pruebas de carga, integrándolas en los ciclos de CI/CD (integración y entrega continua). Esto significa que, con cada nueva versión del LMS o cada nueva funcionalidad desplegada, se ejecutan automáticamente escenarios de carga que permiten validar si el sistema sigue cumpliendo con los parámetros establecidos. Este enfoque requiere una inversión inicial, pero reduce drásticamente los riesgos operativos y acelera la innovación.

¿Qué mejoras estructurales se pueden derivar de los resultados de una prueba de carga?

Las pruebas de carga en un LMS no son simplemente ejercicios técnicos: son ventanas que permiten observar el estado real de la infraestructura que sostiene el aprendizaje digital en una organización. Para un director de tecnología o un gerente de formación, los resultados de estas pruebas son el equivalente a un escáner de salud de la plataforma. Pero más allá de lo que revelan en el presente, su mayor valor reside en lo que permiten mejorar a nivel estructural. Es decir, en su capacidad de ser la base para decisiones que refuercen el sistema a largo plazo. Las mejoras estructurales que pueden derivarse de una prueba de carga son diversas y abarcan múltiples capas del ecosistema LMS, desde la arquitectura de software hasta la gobernanza de TI. Pero antes de hablar de mejoras, es importante entender qué tipo de información proporcionan estas pruebas. Una buena prueba de carga mide el comportamiento del LMS bajo condiciones de uso extremo o intensivo: miles de usuarios concurrentes, reproducción simultánea de contenidos multimedia, procesos masivos como emisión de certificados o sincronización con otros sistemas. Todo esto genera datos sobre latencia, rendimiento de bases de datos, consumo de recursos, errores HTTP, fallos de seguridad y más. A partir de esta información, la primera mejora estructural habitual es la optimización de la arquitectura de infraestructura. En muchos casos, los resultados evidencian que el LMS se encuentra instalado en un entorno que no escala adecuadamente, ya sea por hardware insuficiente, mala configuración de servidores o ausencia de mecanismos como balanceadores de carga. En estos casos, la mejora estructural pasa por migrar a una arquitectura escalable basada en contenedores (Docker/Kubernetes), utilizar instancias en la nube con autoescalado, o rediseñar la forma en que los nodos del sistema se comunican entre sí. Esta decisión no solo resuelve el problema inmediato, sino que prepara el sistema para el crecimiento futuro. Otra mejora estructural que suele derivarse es la modificación o refactorización de código del LMS o de sus plugins personalizados. Las pruebas de carga muchas veces revelan que ciertas funcionalidades, al ejecutarse en paralelo, provocan saturación del sistema, tiempos de respuesta elevados o errores de concurrencia. El equipo de desarrollo, al tener esta información, puede reescribir esas partes del código para que sean más eficientes, estén mejor indexadas o utilicen menos recursos del sistema. En este punto es donde la colaboración entre los equipos de QA, desarrollo y DevOps se vuelve esencial para traducir los resultados en cambios concretos. Asimismo, otro campo clave de mejora estructural se encuentra en la base de datos. En entornos LMS con mucha actividad, es común que se acumulen millones de registros de logs, trazabilidad de cursos, calificaciones, intentos de exámenes y otros elementos. Una prueba de carga puede revelar que las consultas a la base de datos se vuelven lentas, que hay bloqueos o que ciertos procesos generan deadlocks. En este escenario, se pueden implementar mejoras como optimización de índices, partición de tablas, archivado de registros antiguos, separación de bases de datos para lectura y escritura, o uso de motores más eficientes. Todo esto contribuye no solo a mejorar el rendimiento sino también a garantizar la estabilidad en el tiempo. Otra mejora estratégica derivada de los resultados es la incorporación de una red de distribución de contenidos (CDN). Cuando las pruebas indican que el sistema se satura por el consumo de contenido audiovisual (especialmente en video), se vuelve evidente la necesidad de servir estos contenidos desde servidores distribuidos geográficamente. Esta acción reduce significativamente el uso de ancho de banda del LMS central, acelera los tiempos de carga para usuarios remotos y mejora la experiencia general. Además, libera a la plataforma de tareas pesadas, permitiéndole enfocarse en la gestión pedagógica. Un aspecto estructural muchas veces subestimado pero clave es la revisión de la configuración de los servicios de red y seguridad. Las pruebas pueden revelar que el firewall está mal configurado, que el proxy impone latencias innecesarias o que el sistema de autenticación ralentiza el acceso de usuarios cuando hay picos de tráfico. A partir de esto, se pueden rediseñar las políticas de seguridad, segmentar redes, implementar autenticación federada (como SAML o OAuth2) o incluso adoptar soluciones de SSO que disminuyan el impacto del inicio de sesión en masa. También se derivan mejoras a nivel de prácticas operativas y de monitoreo. Si durante la prueba se detectan caídas que no fueron advertidas a tiempo, es probable que el sistema carezca de un monitoreo efectivo en tiempo real. Esto permite introducir mejoras como dashboards de rendimiento, alertas automáticas, integración con herramientas como Prometheus o Grafana, o servicios como Datadog. Estas herramientas permiten tener una visión continua del estado del LMS, incluso fuera del horario laboral. Desde el punto de vista organizacional, otra mejora estructural derivada puede ser la formalización de protocolos de gobernanza tecnológica del LMS. Muchas organizaciones no tienen procesos claros para actualizar, mantener o escalar su sistema de aprendizaje. Las pruebas de carga, al poner en evidencia vulnerabilidades o fallos, obligan a crear políticas, establecer responsables, documentar cambios y definir una hoja de ruta de mantenimiento. Este marco de gobernanza es fundamental para que el LMS sea un activo estratégico y no una fuente de problemas recurrentes. Finalmente, otra mejora crítica es el fortalecimiento de la cultura de pruebas en el ciclo de vida del LMS. Si los resultados negativos de una prueba de carga provocan solo una corrección puntual, no se ha aprovechado el verdadero potencial del ejercicio. Pero si los resultados generan cambios en la forma en que se diseñan, despliegan y validan los cambios en la plataforma, entonces se ha ganado mucho más. Se puede pasar de un modelo reactivo a un modelo preventivo y proactivo, donde la validación de rendimiento se convierte en una práctica habitual.

¿Qué tan costoso puede resultar no realizar pruebas de carga periódicas en un LMS?

Ignorar las pruebas de carga en un LMS no solo es una omisión técnica, es una decisión que puede derivar en costos invisibles que se transforman en pérdidas tangibles. Para una organización que depende del eLearning como parte central de su estrategia de capacitación, desarrollo de talento o incluso negocio, no validar regularmente el rendimiento de su LMS bajo escenarios de uso intensivo es equivalente a lanzar un producto sin hacer pruebas de calidad. Las consecuencias pueden ser severas. El costo más inmediato y evidente es el de las interrupciones del servicio. Cuando un LMS no ha sido sometido a pruebas de carga periódicas, es imposible saber si resistirá una jornada de capacitación masiva, un ciclo de evaluaciones finales o una campaña de onboarding de cientos de colaboradores. En el momento crítico, el sistema puede colapsar: los usuarios no pueden acceder, los videos no cargan, los cursos fallan, los datos se pierden. Y entonces, el costo se mide en horas de trabajo desperdiciadas, pérdida de confianza en la herramienta, saturación del equipo de soporte y la necesidad urgente de hacer reparaciones en producción, generalmente bajo presión y con recursos limitados. Pero esto es solo la punta del iceberg. Existen costos ocultos, igual o más peligrosos. Uno de ellos es el costo reputacional. Imaginemos una universidad que ofrece programas online con estudiantes internacionales. O una empresa que capacita a sus partners en línea para la certificación de sus productos. Si el LMS falla, no se trata solo de una caída técnica, sino de una pérdida de credibilidad. El usuario afectado no siempre distingue entre un proveedor externo y la marca que representa. Y en entornos B2B, esto puede costar negocios. A esto se suma el costo de oportunidad. Cuando el LMS se vuelve inestable, los equipos de TI y formación deben postergar nuevos proyectos para resolver incidentes. Se aplazan lanzamientos, se congelan migraciones, se retrasa la innovación. La empresa pierde velocidad. El talento interno se frustra. Y los líderes pierden la oportunidad de posicionar la formación como un diferencial estratégico. Otro costo significativo es el de la remediación urgente. Cuando un LMS falla en plena operación por no haber hecho pruebas de carga preventivas, muchas veces se deben contratar consultores externos, adquirir herramientas de diagnóstico o escalar infraestructura de manera acelerada (y costosa). Este tipo de inversiones reactivas siempre es más cara que una planificación anticipada. Y peor aún: muchas veces no solucionan el problema de raíz, solo “apagan el incendio”. Además, no realizar pruebas de carga periódicas expone a la organización a riesgos legales. Si el LMS es utilizado para cursos obligatorios por ley, como capacitaciones en prevención de riesgos laborales, cumplimiento normativo o certificaciones profesionales, un fallo en la plataforma puede impedir que los empleados completen el curso en el plazo requerido. Esto puede derivar en multas, sanciones o incluso litigios si hay consecuencias mayores. Desde la perspectiva del aprendizaje, también hay un alto costo. Cuando la plataforma no responde bien, el usuario pierde confianza en el sistema. Disminuye su motivación, abandona cursos, reduce su tasa de finalización. La empresa, entonces, pierde valor en su inversión en contenidos, licencias y recursos. El retorno de la inversión en formación se desploma. Y lo más grave: se genera una cultura de resistencia al aprendizaje digital, difícil de revertir a corto plazo. Por último, está el costo estratégico. Una organización que no hace pruebas de carga periódicas no puede planificar su crecimiento con seguridad. No sabe cuántos usuarios puede soportar su plataforma. No puede predecir si un nuevo curso viral provocará un colapso. No puede escalar con confianza. Y eso impide que el LMS sea una palanca de transformación. En lugar de ser un facilitador del cambio, se convierte en un cuello de botella.

¿Qué desafíos se presentan al simular escenarios realistas de carga en LMS?

Simular un escenario realista de carga en un LMS puede parecer, en teoría, un simple ejercicio técnico: generar miles de usuarios virtuales accediendo a la plataforma para medir su comportamiento. Pero en la práctica, construir una simulación que refleje fielmente el uso real de una organización implica superar múltiples desafíos, tanto técnicos como estratégicos. Para los líderes de tecnología, responsables de formación y arquitectos de soluciones eLearning, esta tarea es tan compleja como esencial, ya que de su precisión depende la toma de decisiones informadas y preventivas sobre la estabilidad y escalabilidad del sistema. El primer gran desafío es representar fielmente el comportamiento humano dentro de la plataforma. Un error común en las pruebas de carga es limitarse a simular múltiples usuarios que simplemente inician sesión o cargan la página principal. Sin embargo, el uso real de un LMS implica patrones mucho más complejos: navegación por distintos módulos, reproducción de videos, descarga de materiales, participación en foros, realización de exámenes, cargas de tareas, interacción con evaluadores, generación de reportes, entre otros. Cada acción consume recursos distintos y tiene diferentes impactos sobre el sistema. Simular esto requiere no solo herramientas sofisticadas, sino una comprensión profunda de los flujos pedagógicos y administrativos del LMS. Además, cada organización tiene patrones únicos de uso. Por ejemplo, una empresa que realiza onboarding mensual de 500 nuevos empleados puede tener picos recurrentes al inicio de cada mes, mientras que una universidad tendrá cargas altas al comenzar los semestres o durante los exámenes finales. Simular estos escenarios implica incorporar la variable tiempo y replicar las condiciones exactas de esos momentos críticos. Esto incluye también tener en cuenta la concurrencia geográfica: usuarios conectados desde distintas zonas horarias, con distintos niveles de conectividad, dispositivos y condiciones de red. El segundo desafío relevante es la construcción y mantenimiento de los scripts de prueba. Crear un test de carga realista exige el uso de herramientas como JMeter, Gatling, LoadRunner o herramientas integradas en entornos de DevOps. Estos scripts deben programarse con lógica condicional, tiempos de espera realistas, rutas de navegación distintas para cada usuario virtual y parametrización de datos. Pero incluso una vez construidos, estos scripts deben mantenerse actualizados. Cada vez que el LMS cambia su interfaz, añade un nuevo módulo o ajusta su lógica interna, los scripts deben ajustarse. De lo contrario, se corre el riesgo de ejecutar pruebas irrelevantes o incluso erróneas. Otro reto importante es replicar las condiciones del entorno productivo sin poner en riesgo la operación real. Esto implica tener un entorno de staging o preproducción que sea casi idéntico al sistema en vivo, tanto en configuración, datos, contenido, como en potencia de cómputo. Pero esto rara vez es así. Muchas organizaciones prueban en entornos reducidos que no reflejan el estrés real del sistema. Esto da como resultado pruebas engañosas: la plataforma parece responder bien, pero en producción colapsa. Y cuando se quiere probar directamente en producción, aparecen riesgos evidentes: afectar usuarios reales, interferir con cursos en curso, generar datos falsos, o incluso hacer caer el sistema en plena operación. El cuarto desafío es la interpretación correcta de los resultados de la prueba. Una simulación realista no es solo generar tráfico: es analizar profundamente los datos que produce. ¿Dónde estuvo el cuello de botella? ¿Qué parte del sistema respondió lento? ¿Se alcanzaron los límites del CPU, memoria, disco o red? ¿Qué tipo de errores surgieron? Muchas veces, los equipos técnicos obtienen miles de líneas de logs y gráficos que, si no son analizados con criterio, terminan archivados sin generar ninguna mejora concreta. Esto requiere tanto herramientas de visualización efectivas como personal capacitado en análisis de performance. Un aspecto frecuentemente subestimado es la simulación del comportamiento bajo condiciones de fallo o estrés extremo. En el mundo real, no todo usuario navega tranquilamente. Algunos usuarios abren múltiples pestañas a la vez, otros actualizan la página repetidamente si no carga, algunos abandonan el curso en medio de un video, otros generan tráfico concurrente desde dispositivos móviles. Además, pueden ocurrir fallos externos: una caída parcial del proveedor de internet, una sobrecarga en el servidor de autenticación, o una latencia en el CDN. Simular estas condiciones requiere diseñar escenarios de estrés controlado, que vayan más allá de una carga ideal y reproduzcan un entorno verdaderamente caótico. También es un reto importante obtener datos reales de uso histórico para alimentar los modelos de simulación. Pocas organizaciones hacen un monitoreo sistemático de patrones de uso en su LMS. Esto impide construir simulaciones basadas en evidencia. La solución pasa por implementar sistemas de logging, analytics y trazabilidad de usuario desde etapas tempranas. Esto permitirá alimentar las pruebas con escenarios que representen cómo se usa realmente el LMS, y no con suposiciones o estimaciones genéricas. Por último, no se puede obviar el desafío cultural: convencer a la organización de la necesidad de hacer pruebas de carga realistas y frecuentes. En muchos casos, estas pruebas son vistas como un gasto innecesario, o se las pospone porque “nunca ha fallado”. Sin embargo, los equipos maduros entienden que estas simulaciones son herramientas de prevención que permiten evitar errores catastróficos. El reto es generar conciencia en los altos mandos, para que las pruebas de carga dejen de ser excepciones y pasen a ser parte del ciclo natural de mantenimiento y evolución de la plataforma.

¿Cómo garantizar la continuidad del servicio mientras se realizan pruebas de carga?

Una de las preocupaciones más legítimas al hablar de pruebas de carga en un LMS es el riesgo de afectar el servicio en producción. Y es una inquietud válida. Nadie quiere poner en riesgo la continuidad operativa del sistema de aprendizaje, especialmente si en él se desarrollan actividades críticas para el negocio. Sin embargo, es perfectamente posible realizar pruebas de carga sin comprometer la disponibilidad del LMS. Para lograrlo, se requiere una combinación de buenas prácticas técnicas, planificación estratégica y gobernanza responsable del entorno. Lo primero es entender que las pruebas de carga no deben ejecutarse directamente sobre el entorno productivo, al menos no sin preparación. El error más común es probar “en caliente”, es decir, realizar simulaciones sin aislar adecuadamente el sistema real, sin avisar a los usuarios o sin monitorear el impacto en tiempo real. Esto puede provocar desde interrupciones leves hasta caídas completas del servicio, especialmente si el sistema ya opera en el límite de su capacidad. La práctica recomendada es contar con un entorno de staging o preproducción, idéntico al entorno real en configuración, recursos, base de datos (anónima o enmascarada), volumen de contenido y tráfico simulado. Este entorno debe mantenerse activo y actualizado. Es el espacio ideal para ejecutar pruebas de carga sin afectar al usuario final. No obstante, seamos honestos: no todas las organizaciones tienen los recursos o la madurez para mantener dos entornos paralelos de igual capacidad. En ese caso, se deben tomar otras medidas para minimizar el riesgo. Cuando es inevitable probar sobre el entorno real, lo primero es planificar cuidadosamente el momento de ejecución. Las pruebas deben realizarse fuera del horario pico, idealmente en horarios nocturnos, fines de semana o feriados. Además, deben programarse cuando no hay cursos en ejecución, evaluaciones activas o procesos de capacitación obligatorios. El equipo de TI debe establecer ventanas de mantenimiento, comunicar previamente a los usuarios y obtener aprobaciones de las áreas involucradas. Otro aspecto fundamental es el aislamiento progresivo del entorno durante la prueba. Esto se puede hacer limitando el tráfico de usuarios reales mediante redireccionamientos, restricciones temporales o incluso utilizando mecanismos de “shadow testing”, donde parte del tráfico real se duplica y se envía a una réplica del sistema para medir su comportamiento. También se puede recurrir a técnicas como “canary testing” o “blue/green deployment”, donde las pruebas se realizan sobre una versión clonada y luego se hace el switch de entorno si todo va bien. Además, es imprescindible utilizar herramientas de monitoreo en tiempo real, como Prometheus, Zabbix, Grafana, Elastic Stack o servicios en la nube como AWS CloudWatch o Azure Monitor. Estas herramientas permiten detectar en cuestión de segundos si la prueba está provocando impactos no deseados: consumo anormal de CPU, errores 500, caídas de servicio, latencias excesivas. Si algo sale mal, el equipo puede pausar la prueba inmediatamente y restaurar el sistema antes de que los usuarios lo perciban. Uno de los grandes aliados para garantizar la continuidad del servicio durante las pruebas es contar con una arquitectura LMS resiliente y escalable, que pueda absorber aumentos repentinos de carga sin colapsar. Esto incluye balanceadores de carga, instancias elásticas en la nube, caché distribuido, redundancia geográfica, uso de CDN para contenidos pesados y desacoplamiento de servicios mediante microservicios. Si el sistema está bien diseñado, podrá soportar incluso simulaciones en producción sin afectar a los usuarios reales. También es importante tener preparado un plan de contingencia o rollback. Toda prueba de carga debe contar con un protocolo que establezca qué hacer si el sistema falla. Esto incluye respaldos automáticos, reinicio de servicios, restauración de configuraciones previas y comunicación interna clara. No se trata de asumir que todo saldrá bien, sino de estar preparado para lo contrario. Por último, para garantizar la continuidad del servicio, es crucial comunicar y coordinar adecuadamente con todas las partes interesadas. El equipo de TI no puede operar solo. Debe informar al área de formación, a recursos humanos, a soporte al usuario y a los líderes de proyecto. Todos deben estar al tanto del objetivo, el alcance y la ventana de tiempo de las pruebas. Incluso en entornos corporativos, un simple banner de aviso puede evitar cientos de tickets de soporte si los usuarios saben que habrá actividades técnicas temporales.

¿Cuál es el rol de DevOps en la ejecución de pruebas de carga LMS?

El enfoque DevOps ha transformado radicalmente la forma en que las organizaciones gestionan su infraestructura tecnológica, especialmente en sistemas que requieren alta disponibilidad, escalabilidad continua y tiempo de respuesta mínimo, como lo es un LMS en ambientes corporativos o educativos. Lejos de ser un departamento o rol aislado, DevOps representa una cultura y un conjunto de prácticas colaborativas entre desarrollo, operaciones, QA y arquitectura que buscan automatizar, integrar y optimizar todo el ciclo de vida de un producto. En este contexto, el rol de DevOps en la ejecución de pruebas de carga en LMS es absolutamente crítico, porque permite que estas pruebas dejen de ser eventos puntuales y pasen a convertirse en prácticas regulares, automatizadas y estratégicas. Uno de los principales aportes de DevOps es la automatización. En entornos tradicionales, las pruebas de carga suelen ejecutarse de forma manual, cada cierto tiempo, y dependen del tiempo y disponibilidad del equipo técnico. Esto limita su frecuencia, alcance y utilidad. DevOps cambia ese paradigma al permitir que las pruebas de carga se integren en el pipeline de integración y entrega continua (CI/CD). Es decir, cada vez que se hace un cambio importante en el LMS—ya sea una nueva funcionalidad, una actualización, un parche o una integración externa—el sistema puede ejecutar automáticamente pruebas de carga para validar que el rendimiento no se ha visto afectado. Esto permite detectar y corregir problemas de performance en fases tempranas, cuando aún es barato solucionarlos. El equipo DevOps también cumple un rol fundamental en la orquestación del entorno de pruebas. Uno de los grandes desafíos en las pruebas de carga, como ya vimos anteriormente, es replicar un entorno lo más similar posible al de producción. Gracias a herramientas de infraestructura como código (Terraform, Ansible, Puppet) y contenedores (Docker, Kubernetes), DevOps puede desplegar entornos clonados en minutos, con la misma configuración, datos, seguridad y escalabilidad que el entorno real. Esto permite ejecutar pruebas en condiciones extremadamente cercanas a las reales, sin poner en riesgo el sistema productivo. Además, DevOps aporta la visibilidad en tiempo real del impacto de las pruebas. Mediante el uso de sistemas de monitoreo, logging y trazabilidad, el equipo puede visualizar, en dashboards ejecutivos y técnicos, qué ocurre en cada capa del sistema durante una prueba de carga: desde el tiempo de respuesta de la base de datos hasta la latencia en la red, el comportamiento del CPU, las métricas del CDN o la integridad de las conexiones externas. Esta visibilidad permite tomar decisiones más rápidas y fundamentadas, y evita que se pasen por alto cuellos de botella que solo aparecen bajo condiciones de estrés. Otro punto crucial es la gestión de la infraestructura elástica. Muchas plataformas LMS modernas están alojadas en la nube, ya sea pública o híbrida. DevOps permite configurar políticas automáticas de autoescalado: si una prueba de carga revela que la instancia actual del LMS se satura con 1000 usuarios concurrentes, se pueden crear reglas para que automáticamente se desplieguen nuevos nodos que absorban la demanda. Esta elasticidad no solo mejora la resiliencia del sistema, sino que también reduce costos al escalar solo cuando se necesita, una capacidad fundamental para operaciones de formación masiva, lanzamientos de cursos o certificaciones globales. El equipo DevOps también cumple un rol importante en la documentación y estandarización del proceso de pruebas de carga. A diferencia de los métodos tradicionales donde cada prueba es única y difícil de replicar, en DevOps todo se codifica: los scripts de prueba, los escenarios, las variables, los tiempos de espera, los umbrales de éxito, los tipos de carga (concurrente, progresiva, en picos), etc. Esto permite generar historiales de pruebas, comparar resultados entre versiones del sistema y construir una cultura basada en datos y no en intuiciones. A su vez, facilita el traspaso de conocimientos entre equipos, la auditoría técnica y la mejora continua. En términos de cultura organizacional, DevOps promueve una colaboración transversal que potencia el valor de las pruebas de carga. Ya no se trata de un test que hace “el equipo de sistemas” en solitario, sino de un ejercicio conjunto entre desarrollo, QA, formación, seguridad y negocio. Esta visión compartida permite que los hallazgos de las pruebas se traduzcan rápidamente en decisiones concretas: ajustar el diseño de un curso, optimizar una funcionalidad, reforzar la seguridad, o escalar la infraestructura antes de que llegue la sobrecarga real. Incluso más allá de lo técnico, DevOps agrega valor estratégico al incorporar el concepto de observabilidad continua, una práctica que va más allá del monitoreo. Las herramientas modernas utilizadas por equipos DevOps (como Grafana, ELK Stack, Prometheus, Datadog, etc.) no solo muestran métricas, sino que permiten correlacionar eventos, detectar patrones y predecir comportamientos. Esto permite anticipar fallos incluso antes de que ocurran, una capacidad que convierte a las pruebas de carga en una herramienta predictiva en lugar de reactiva.

¿Qué implicancias legales podrían derivar del fallo de un LMS no probado correctamente?

Aunque muchas veces se aborda el rendimiento de un LMS desde una perspectiva puramente técnica o funcional, sus fallos pueden tener consecuencias que van mucho más allá del ámbito tecnológico. Cuando un LMS falla, especialmente si lo hace durante procesos críticos y no ha sido adecuadamente probado mediante pruebas de carga, pueden desencadenarse implicancias legales significativas que afectan la operación, la reputación y la responsabilidad jurídica de la organización. Este es un riesgo que los directivos no pueden ignorar. El primer frente legal evidente tiene que ver con el incumplimiento de obligaciones contractuales. Muchas empresas utilizan LMS para brindar formación obligatoria, tanto interna como externa. Esto incluye entrenamientos de seguridad industrial, protección de datos, prevención de lavado de activos, cumplimiento normativo (compliance), formación técnica certificada, entre otros. Si el LMS falla y los empleados no pueden completar estos cursos en los plazos estipulados, la empresa puede estar incumpliendo obligaciones legales o contractuales. Esto no solo expone a sanciones, multas o pérdida de licencias, sino que puede invalidar procesos legales si se requiere comprobar que alguien fue efectivamente capacitado. En el sector educativo, un fallo no controlado en el LMS puede vulnerar normativas regulatorias. Por ejemplo, en universidades y centros acreditados, la trazabilidad del aprendizaje, la emisión de certificados, el cumplimiento de horas lectivas y la verificación de asistencia están regulados. Si el sistema colapsa, se pierde información o se impide el acceso a evaluaciones, la institución puede enfrentar auditorías, pérdida de acreditación o incluso demandas por parte de estudiantes. Otra implicancia legal relevante surge de los datos personales. Los LMS almacenan grandes cantidades de información sensible: nombres, correos, identificaciones, historial de formación, evaluaciones, videos de participación, etc. Si un fallo técnico provocado por una sobrecarga (que pudo haberse evitado con pruebas de carga) genera una brecha de seguridad, se activan inmediatamente normativas de protección de datos como el GDPR (en Europa), la Ley de Protección de Datos Personales (en muchos países de Latinoamérica) o regulaciones sectoriales. No hacer las pruebas adecuadas podría considerarse negligencia, lo cual agrava la responsabilidad legal y aumenta el monto de las sanciones. En muchos marcos normativos, la ley no solo exige proteger los datos, sino demostrar que se tomaron todas las medidas razonables para prevenir incidentes. A nivel corporativo, un fallo del LMS en medio de una certificación externa puede implicar la ruptura de acuerdos comerciales. Por ejemplo, una empresa que capacita y certifica a sus socios a través del LMS podría incumplir SLA (Acuerdos de Nivel de Servicio) si no garantiza la disponibilidad del sistema. Esto puede derivar en penalidades económicas, pérdida de contratos, daños reputacionales y hasta demandas por incumplimiento contractual. Tampoco se deben subestimar las implicancias laborales. En muchos países, los procesos de formación son parte de los deberes del empleador. Si el LMS falla y esto impide capacitar adecuadamente a los trabajadores en aspectos críticos como seguridad laboral, igualdad de género, ciberseguridad o salud ocupacional, la organización puede ser considerada responsable ante cualquier accidente o incidente relacionado. Incluso puede abrir la puerta a litigios por parte de los empleados, especialmente si se comprueba que la falla pudo haberse prevenido mediante controles adecuados como pruebas de carga. También hay un riesgo en el ámbito del derecho al consumidor, especialmente en organizaciones que comercializan formación online. Si un LMS colapsa y los usuarios no pueden acceder a los cursos por los que pagaron, estos tienen derecho a solicitar devoluciones, compensaciones o incluso pueden emprender acciones legales colectivas, según la jurisdicción. El riesgo aumenta si no hay términos y condiciones claros que establezcan límites de responsabilidad. Por último, aunque menos común pero cada vez más relevante, existen implicancias penales en casos extremos. Si un LMS fallido impide una capacitación crítica que, por omisión, desencadena un accidente, una brecha de seguridad masiva o un hecho con consecuencias graves, la organización puede enfrentarse a investigaciones penales por negligencia profesional. Este escenario, aunque extremo, es posible, especialmente en industrias reguladas como salud, transporte, energía o servicios financieros. 🧾 Resumen Ejecutivo En un mundo empresarial profundamente digitalizado, donde la capacitación es una piedra angular de la competitividad y la innovación, los sistemas de gestión del aprendizaje (LMS) se han convertido en infraestructuras críticas. WORKI 360, como plataforma integral de gestión del talento y el conocimiento, tiene la oportunidad de consolidarse como referente en el mercado si incorpora con rigor y visión estratégica la práctica de las pruebas de carga LMS. Este artículo ha desarrollado diez preguntas clave relacionadas con los desafíos, implicancias legales, aspectos técnicos, riesgos y oportunidades que giran en torno a la ejecución de pruebas de carga en entornos LMS. Las conclusiones extraídas son claras: no realizar estas pruebas representa un riesgo técnico, económico, legal y reputacional, mientras que su correcta implementación ofrece mejoras estructurales significativas, protección jurídica y ventaja competitiva. Entre los principales beneficios estratégicos para WORKI 360 destacan: 1. Mejor experiencia de usuario final El artículo mostró cómo el contenido en video, tan común en la formación actual, genera una carga de red y sistema enorme. Simular este uso masivo mediante pruebas de carga permite anticipar cuellos de botella, optimizar la entrega de contenidos vía CDN y garantizar que cada usuario, sin importar la ubicación, reciba una experiencia fluida, rápida y sin interrupciones. Esto potencia la retención y satisfacción del usuario, clave en cualquier estrategia de formación empresarial. 2. Infraestructura LMS escalable, resiliente y lista para el futuro Gracias al enfoque DevOps, WORKI 360 puede incorporar pruebas de carga como parte del pipeline de entrega continua. Esto no solo mejora la calidad del servicio, sino que permite una escalabilidad real y medible. Detectar puntos débiles antes de que afecten la operación es la base para construir una infraestructura LMS robusta, capaz de crecer sin perder estabilidad. 3. Reducción de riesgos legales y cumplimiento normativo garantizado Uno de los hallazgos más relevantes es el impacto legal que puede tener el fallo de un LMS: incumplimientos regulatorios, brechas de seguridad, litigios laborales o pérdida de contratos comerciales. Las pruebas de carga periódicas no son solo buenas prácticas técnicas, son una herramienta de cumplimiento preventivo. WORKI 360, al institucionalizar esta práctica, puede posicionarse como un LMS confiable y alineado con normativas internacionales como GDPR, ISO 27001 o leyes locales de protección de datos. 4. Optimización de costos operativos Contrario a lo que puede pensarse, hacer pruebas de carga no es un gasto innecesario. El artículo demuestra que no hacerlas implica costos mucho mayores: desde interrupciones del servicio hasta proyectos de remediación urgentes que cuestan hasta 10 veces más que la prevención. Con pruebas programadas e inteligentes, WORKI 360 puede optimizar sus recursos, evitar desperdicios y anticiparse a escenarios críticos. 5. Toma de decisiones basada en evidencia técnica Las pruebas de carga generan datos. Y los datos bien interpretados permiten priorizar mejoras, justificar inversiones en infraestructura, seleccionar tecnologías más adecuadas y diseñar planes de escalamiento realistas. Este enfoque analítico y predictivo posiciona a WORKI 360 como una plataforma que no improvisa, sino que construye desde la solidez técnica. 6. Reputación fortalecida ante clientes y auditores Una plataforma que puede demostrar su rendimiento bajo carga con evidencia, reportes, historiales de pruebas y un sistema de monitoreo permanente, no solo genera confianza: establece un estándar de calidad superior. WORKI 360 puede utilizar esta práctica como un elemento diferenciador en licitaciones, auditorías, procesos de venta B2B y presentaciones ante stakeholders estratégicos. 7. Mayor sinergia entre áreas técnicas y funcionales El enfoque recomendado promueve una colaboración real entre desarrollo, QA, infraestructura, formación y dirección. Las pruebas de carga no son responsabilidad exclusiva de TI, sino una práctica transversal que genera alineación estratégica entre tecnología y negocio. Esto mejora la agilidad, reduce silos internos y promueve una cultura orientada a la excelencia operativa.