Índice del contenido

¿Cómo elegir el mejor framework para el desarrollo de aplicaciones en función de objetivos de negocio y escalabilidad?

Elegir el mejor framework para desarrollar aplicaciones es una decisión estratégica que trasciende lo técnico. Para un director de tecnología o un gerente general, esta elección impacta en la velocidad de innovación, la escalabilidad de la solución, los costos de mantenimiento y la sostenibilidad operativa de toda la arquitectura digital corporativa. Veamos, con storytelling y enfoque gerencial, cómo abordar esta decisión crítica: 🔹 1. Comprender la visión y los objetivos de negocio antes de lo técnico Imagina una empresa que planea su expansión regional y requiere aplicaciones con gran capacidad de adaptación a filiales en países con regulaciones distintas. Si el framework elegido no permite escalabilidad modular, terminará convirtiéndose en un cuello de botella. Por ello, antes de evaluar React, Angular, Vue, Spring o .NET, define con claridad: ¿Cuál es el core estratégico del proyecto? ¿Se busca escalabilidad masiva o desarrollo rápido de MVPs? ¿El objetivo es integrar sistemas legados o crear un producto completamente nuevo? Este análisis debe involucrar al área de estrategia y al Product Owner. De lo contrario, la elección se basará en tendencias y no en la realidad del negocio. 🔹 2. Evaluar el ecosistema del framework en términos de talento disponible y costos Un framework con un ecosistema consolidado permite: Encontrar programadores capacitados sin inflar el presupuesto salarial. Integrarse con librerías, APIs y herramientas de testing sin reinventar la rueda. Por ejemplo, un gerente que elige un framework de nicho sin profesionales capacitados en su país, enfrentará rotación de personal, retención costosa y lentitud de ejecución. Storytelling real: En 2022, un holding financiero latinoamericano eligió un framework de moda para su nueva app B2B. A los seis meses, no encontraban programadores con dominio avanzado y el proyecto duplicó su tiempo estimado. El gerente de TI debió migrarlo a un framework popular en la región, incurriendo en costos adicionales de reprogramación. La lección: validar el talento disponible antes de elegir. 🔹 3. Analizar la escalabilidad horizontal y vertical del framework La escalabilidad debe abordarse en dos dimensiones: Escalabilidad horizontal (capacidad de servir a millones de usuarios sin reconfigurar toda la arquitectura). Escalabilidad vertical (integración con módulos futuros, nuevos servicios o microservicios). Frameworks como Spring Boot o .NET Core están diseñados para integrarse a arquitecturas empresariales modulares con microservicios, mientras frameworks frontend como React o Angular permiten desarrollo desacoplado de interfaces para múltiples aplicaciones. Si el negocio proyecta crecimiento exponencial, estos aspectos son críticos. Ningún CTO desea descubrir, cuando su aplicación alcanza 500,000 usuarios, que el framework elegido no soporta esa carga sin rediseño total. 🔹 4. Validar la madurez tecnológica y la comunidad del framework Frameworks maduros reducen riesgos de seguridad y problemas de actualización. Comunidades amplias garantizan soporte constante, librerías actualizadas y soluciones a vulnerabilidades en menor tiempo. Por ejemplo, Angular cuenta con el respaldo de Google y una comunidad global masiva; Spring Boot posee amplia documentación corporativa y .NET Core es impulsado por Microsoft, asegurando su evolución. Un framework con escasa comunidad es riesgoso, salvo para casos muy específicos de innovación. 🔹 5. Considerar la integración con sistemas legados y APIs corporativas Para empresas con ERP, CRM, plataformas financieras o de producción de datos en backend, la integración con sistemas legados es un factor no negociable. Antes de elegir un framework: Revisa su capacidad nativa para consumir APIs REST o SOAP. Evalúa si ofrece adaptadores o SDKs para tus sistemas existentes. Valida su compatibilidad con estándares corporativos de seguridad y cifrado. No es solo un tema de “funcionar técnicamente” sino de mantener la seguridad y consistencia de los procesos de negocio. 🔹 6. Estimar la curva de aprendizaje y el time-to-market Cada framework posee una curva de aprendizaje distinta. Para proyectos con alta presión de entrega: Elige frameworks con menor curva de aprendizaje si el equipo carece de experiencia previa. Prioriza frameworks con documentación oficial clara y abundante. Por ejemplo, React es ágil para desarrolladores con experiencia en JavaScript, mientras Angular requiere un aprendizaje más estructurado. Esta decisión puede acelerar o retrasar la salida al mercado hasta en un 30-40% según múltiples consultoras globales. 🔹 7. Revisar licencias y costos asociados En entornos corporativos, la gestión de licencias es estratégica: Revisa las licencias del framework para evitar pagos inesperados por uso comercial. Asegúrate de que su licencia sea compatible con la política de software corporativa. Por ejemplo, ciertas versiones de .NET requieren licencias adicionales según el tipo de despliegue. Esto puede generar costos no previstos en la planificación financiera. 🔹 8. Incluir a los stakeholders clave en la decisión Finalmente, elegir un framework no es tarea exclusiva de TI. Deben participar: Gerente de Desarrollo o CTO Arquitecto de Software Product Owner o líderes de negocio Especialistas en seguridad Así se garantiza que la decisión esté alineada a los objetivos financieros, operativos y de innovación tecnológica. 📝 Conclusión estratégica Elegir un framework no es solo un tema de tecnología, es una decisión de negocio, estrategia y sostenibilidad. Debe permitir desarrollar aplicaciones eficientes, escalables, fáciles de mantener y que maximicen la productividad de los equipos. Cada hora invertida en este análisis evita años de ineficiencia operativa.

¿Cómo ayuda la programación orientada a objetos en la escalabilidad de aplicaciones corporativas?

La programación orientada a objetos (POO) se mantiene como pilar fundamental en el desarrollo de software empresarial. Para un gerente de tecnología o director de sistemas, comprender su verdadero impacto en la escalabilidad de aplicaciones corporativas es clave para tomar decisiones acertadas sobre arquitectura, contratación y futuro tecnológico. Analicemos su aporte con visión estratégica y storytelling real de negocios: 🔹 1. Modularidad y reusabilidad para reducir costos y acelerar innovaciones La POO permite dividir la aplicación en clases, objetos y métodos reutilizables. Cada módulo representa una entidad del negocio con sus atributos y comportamientos. Esto brinda beneficios inmediatos: Reutilización de código: Al crear clases genéricas o abstractas, se evitan duplicidades que inflan el código base. Bajo costo de mantenimiento: Si un cambio afecta a varias áreas del sistema, se actualiza solo la clase madre o módulo común. Time-to-market acelerado: Nuevas funcionalidades pueden construirse a partir de clases existentes, reduciendo tiempos de desarrollo. Storytelling real: Un banco regional desarrolló su plataforma de créditos sobre un modelo orientado a objetos donde cada tipo de crédito heredaba propiedades de una clase genérica “Crédito”. Cuando decidieron lanzar un nuevo producto crediticio digital, el desarrollo tomó solo 25% del tiempo estimado, pues reutilizaron el modelo base. 🔹 2. Escalabilidad horizontal mediante instanciación de objetos independientes La POO permite crear múltiples instancias de un objeto en memoria sin interferencia directa entre ellas. Esto habilita: Aplicaciones capaces de atender solicitudes concurrentes de forma aislada, aumentando su escalabilidad horizontal. Creación de microservicios orientados a objetos, cada uno con sus propias entidades y lógica de negocio, distribuidos en múltiples servidores. Para empresas que requieren expandir la capacidad de su aplicación a millones de usuarios simultáneos, esta propiedad técnica se traduce en rendimiento eficiente y bajo riesgo de saturación. 🔹 3. Abstracción para gestionar la complejidad del negocio Las aplicaciones corporativas suelen manejar procesos complejos (financieros, operativos, productivos). La POO ofrece un enfoque abstracto que permite modelar el negocio en código de forma entendible: Clases como “Empleado”, “Factura”, “Cliente” reflejan entidades reales. Métodos como “calcularSueldo()” o “generarReporte()” representan acciones del negocio. Esta correspondencia facilita el entendimiento entre programadores y stakeholders, reduciendo errores de interpretación, un punto crítico en proyectos de alto impacto financiero. 🔹 4. Herencia para expansión sin reprogramar toda la arquitectura La herencia es una de las características más potentes de la POO: Permite crear nuevas clases que heredan atributos y métodos de clases preexistentes. Los cambios o mejoras en la clase base se replican automáticamente en sus hijas, siempre que no se sobrescriban métodos clave. Esto habilita la expansión de aplicaciones sin necesidad de reprogramar módulos completos, una ventaja para empresas que evolucionan constantemente sus productos y servicios. 🔹 5. Polimorfismo para diseñar aplicaciones flexibles y adaptables El polimorfismo posibilita que diferentes clases compartan un método con el mismo nombre, pero con comportamientos distintos. Desde un enfoque gerencial, esto implica: Construcción de sistemas altamente flexibles, capaces de adaptarse a nuevas necesidades sin reestructuración total. Simplificación del mantenimiento, pues el código se organiza en métodos genéricos adaptables según contexto. Por ejemplo, un método “procesarPago()” puede comportarse distinto si se trata de tarjeta de crédito, débito o transferencia, sin necesidad de crear funciones duplicadas dispersas. 🔹 6. Encapsulamiento como garantía de seguridad y control de integridad El encapsulamiento protege los datos internos de un objeto al restringir su acceso directo. Sus ventajas estratégicas son: Prevención de modificaciones no autorizadas o erróneas. Mantenimiento de la integridad de datos clave del negocio. Reducción de errores críticos que podrían afectar operaciones financieras, productivas o logísticas. En aplicaciones corporativas donde un fallo en la lógica puede significar millones en pérdidas, el encapsulamiento ofrece una capa adicional de seguridad y gobernanza. 🔹 7. Mejora en la escalabilidad organizacional y de talento Además de lo técnico, la POO impacta en la escalabilidad organizacional: Equipos nuevos pueden integrarse fácilmente a proyectos POO, pues su estructura modular y orientada al negocio facilita el onboarding. La contratación de programadores se simplifica, ya que la POO es un estándar global, reduciendo la dependencia de expertos en frameworks específicos. Esto se traduce en continuidad operativa y menor rotación de talento, garantizando que los proyectos no se estanquen ante salidas de personal clave. 🔹 8. Facilita la implementación de microservicios y arquitecturas modernas La orientación a objetos es un fundamento técnico de microservicios, serverless y arquitecturas modulares. Cada microservicio puede diseñarse como un conjunto de clases y objetos independientes, logrando: Despliegue autónomo. Escalabilidad selectiva de servicios específicos. Mayor resiliencia, pues un fallo en un microservicio no colapsa toda la aplicación. Para empresas con estrategias de transformación digital y cloud-native, la POO es indispensable. 🔹 9. Reducción de deuda técnica y costos futuros Una aplicación POO bien diseñada evita: Refactorizaciones costosas. Ciclos de testing interminables. Reprogramación total al escalar nuevos servicios. Esto reduce la deuda técnica y los costos futuros, alineando el desarrollo con la sostenibilidad financiera y operativa del negocio. 📝 Conclusión estratégica La programación orientada a objetos no es solo un paradigma técnico, es una filosofía de diseño escalable y sostenible. Permite a las empresas responder ágilmente al cambio, garantizar la estabilidad operativa y facilitar la innovación constante. Para el gerente de tecnología, implementarla estratégicamente es decidir sobre la agilidad y competitividad futura de la organización.

¿Qué beneficios aporta la integración de IA generativa en el desarrollo de aplicaciones corporativas?

La integración de inteligencia artificial generativa (IA generativa) en el desarrollo de aplicaciones corporativas representa un cambio estratégico profundo para la competitividad y productividad organizacional. Su impacto no solo es técnico, sino operativo, cultural y financiero. A continuación, analizamos sus beneficios con storytelling real y enfoque para directores de tecnología, recursos humanos y gerentes generales: 🔹 1. Aceleración radical en el ciclo de desarrollo La IA generativa es capaz de producir código base, estructuras de funciones, interfaces y propuestas de arquitectura en segundos o minutos, tareas que a un programador le tomarían horas o días. Ejemplo real: En 2023, una multinacional de consumo masivo implementó IA generativa en su equipo de desarrollo backend. Lograron acelerar el diseño de APIs en un 40%, liberando horas de trabajo para optimizaciones críticas que antes quedaban postergadas. Este beneficio se traduce en: Time-to-market reducido, clave en sectores con alta competencia digital. Liberación de programadores para tareas de innovación y diseño arquitectónico estratégico. 🔹 2. Mayor calidad y consistencia en el código generado Las herramientas de IA generativa producen código basado en prácticas globales de programación, estándares de sintaxis y seguridad, lo que minimiza errores y problemas de mantenimiento futuro. Esto es clave para gerentes que buscan: Estandarizar desarrollos en múltiples equipos y países. Garantizar consistencia ante rotación de personal técnico. La IA no sustituye la revisión humana, pero reduce errores básicos y acelera la fase de testing, optimizando costos operativos. 🔹 3. Potenciación de la creatividad y resolución de problemas complejos Al delegar tareas repetitivas a la IA generativa, los programadores y arquitectos de software pueden enfocarse en: Diseño de soluciones innovadoras. Mejora de la experiencia de usuario. Optimización de algoritmos de negocio. Storytelling real: Un equipo de desarrollo fintech utilizó IA generativa para construir las funciones básicas de su app de pagos. El tiempo ahorrado fue reinvertido en diseñar un algoritmo antifraude exclusivo que elevó la percepción de seguridad de sus usuarios, logrando un NPS (Net Promoter Score) 25% superior al año anterior. 🔹 4. Democratización del desarrollo y reducción de brechas técnicas Las herramientas de IA generativa permiten que programadores con menor experiencia completen tareas que antes requerían perfiles senior. Esto habilita: Ampliar la base de talento aprovechable en la organización. Reducir costos salariales en tareas operativas básicas. Acelerar el aprendizaje del personal menos experimentado, al interactuar con la IA y entender su lógica generada. En tiempos de escasez de talento TI, este beneficio estratégico es crucial para la continuidad operativa y reducción de rotación. 🔹 5. Optimización de procesos de testing y calidad La IA generativa no solo crea código, sino que puede generar casos de prueba, scripts de testing automatizado y escenarios de prueba de carga o seguridad. Esto implica: Liberación de recursos humanos para pruebas exploratorias avanzadas. Reducción de tiempos en la etapa de aseguramiento de calidad. Mayor cobertura de pruebas, minimizando fallos post-lanzamiento que pueden impactar la reputación corporativa. 🔹 6. Personalización masiva y adaptación a cada unidad de negocio La IA generativa permite crear: Interfaces personalizadas por filial, región o segmento de cliente. Microservicios diseñados para resolver procesos específicos de cada área. Este beneficio incrementa la satisfacción interna (clientes corporativos) y externa (usuarios finales), elevando la productividad y eficiencia operativa. 🔹 7. Innovación acelerada en experiencia de usuario (UX/UI) La IA generativa no solo genera código backend, sino también interfaces gráficas completas, maquetas y prototipos interactivos. Para los gerentes de producto y directores de marketing, esto significa: Reducción en el tiempo de validación de nuevas ideas. Mayor alineación entre los equipos de tecnología y negocio. Pruebas de usabilidad inmediatas para medir reacción y conversión. 🔹 8. Reducción de costos operativos y financieros La integración de IA generativa disminuye: Horas de programación manual en módulos repetitivos. Necesidad de plantillas externas o recursos de programación tercerizados para tareas básicas. Esto reduce costos directos del área TI y permite reinvertir en innovación y proyectos estratégicos de transformación digital. 🔹 9. Fortalecimiento de la cultura de innovación y talento interno Integrar IA generativa en la empresa: Impulsa la cultura de innovación y aprendizaje continuo. Genera atracción de talento joven interesado en trabajar con herramientas de vanguardia. Motiva a los equipos al permitirles enfocarse en desafíos de alto impacto en lugar de tareas repetitivas. 🔹 10. Preparación para modelos operativos futuros basados en IA Finalmente, las organizaciones que integran IA generativa en el desarrollo de aplicaciones: Se familiarizan con modelos operativos basados en IA para otras áreas (finanzas, logística, ventas). Desarrollan competencias estratégicas en gobierno y ética de la IA. Construyen una ventaja competitiva sostenible frente a sus competidores. 📝 Conclusión estratégica La IA generativa en desarrollo de aplicaciones no es solo un acelerador tecnológico, sino un impulsor de productividad, innovación y diferenciación corporativa. Su integración debe planificarse estratégicamente, incluyendo capacitación de talento, gobernanza de datos, definición de procesos y medición de su impacto financiero. Para los directores de tecnología y gerentes generales, representa la oportunidad de redefinir los límites de lo posible en su industria.

¿Cómo garantizar la compatibilidad de aplicaciones nuevas con sistemas legados mediante programación adecuada?

Garantizar la compatibilidad de nuevas aplicaciones con sistemas legados es un desafío estratégico en toda empresa que busca innovación sin interrumpir operaciones críticas. Para un director de tecnología o gerente general, este aspecto no solo implica una solución técnica, sino la continuidad de procesos de negocio, mitigación de riesgos operativos y eficiencia financiera. A continuación, exploramos cómo lograrlo con un enfoque de programación adecuada y visión gerencial: 🔹 1. Realizar un diagnóstico exhaustivo de los sistemas legados Antes de diseñar o programar cualquier aplicación nueva, se debe realizar un análisis profundo de los sistemas legados involucrados: Tecnologías utilizadas y su versión actual. Limitaciones de rendimiento, seguridad y escalabilidad. Tipos de base de datos, estructuras de datos y APIs disponibles (o su ausencia). Storytelling real: Una aseguradora regional inició un proyecto de CRM sin diagnosticar su sistema de pólizas legado, construido en COBOL. Tras dos meses de avance, descubrieron que no podían conectarse a la base de datos principal sin un costoso desarrollo intermedio. El proyecto se retrasó 8 meses, afectando su presupuesto anual. 🔹 2. Diseñar la arquitectura de la nueva aplicación considerando integración desde el inicio Uno de los errores más comunes es crear la nueva aplicación como un proyecto aislado y recién al final “pensar en integrarla”. El enfoque correcto implica: Definir la integración como requisito esencial desde el diseño. Incluir en el backlog técnico la programación de APIs, adaptadores o middleware para comunicación con sistemas legados. Este enfoque asegura que las decisiones de tecnología, frameworks y bases de datos se tomen considerando la compatibilidad necesaria. 🔹 3. Utilizar APIs y microservicios como puente entre sistemas Cuando los sistemas legados no cuentan con APIs, se puede: Crear APIs Wrapper, es decir, microservicios que se comunican con el sistema legado y exponen su funcionalidad mediante API REST o SOAP. Implementar middleware de integración, que gestione protocolos, formatos de datos y seguridad. Este modelo desacopla la nueva aplicación del sistema legado, facilitando el mantenimiento futuro y la migración progresiva de funcionalidades. 🔹 4. Adoptar técnicas de refactorización o reingeniería progresiva Si bien no siempre es posible reescribir un sistema legado completo, se puede planificar su refactorización modular: Identificar módulos críticos que deban modernizarse para garantizar compatibilidad. Reescribir gradualmente cada módulo usando programación orientada a objetos o microservicios. Priorizar módulos con mayor interacción con la nueva aplicación. Este enfoque permite innovar sin interrumpir operaciones y distribuir el presupuesto en etapas viables. 🔹 5. Emplear estándares de comunicación y formatos de datos compatibles La programación de aplicaciones nuevas debe considerar: Uso de estándares de datos como JSON, XML, CSV o protocolos SOAP/REST. Compatibilidad de codificación de caracteres, evitando problemas en integraciones multinacionales (UTF-8, Latin-1, etc.). Estándares de cifrado y autenticación requeridos por el sistema legado (por ejemplo, OAuth 2.0, SAML, certificados SSL). Ignorar estos aspectos puede generar errores de comunicación, datos corruptos o vulnerabilidades de seguridad. 🔹 6. Implementar pruebas de integración desde las fases iniciales Una estrategia efectiva es planificar pruebas de integración tempranas: Diseñar casos de prueba de compatibilidad antes de finalizar el desarrollo de la nueva aplicación. Ejecutar pruebas automáticas en ambientes controlados para validar conexión, intercambio de datos y seguridad. Identificar rápidamente problemas de formato, latencia o incompatibilidad para resolverlos antes de etapas finales. Este enfoque reduce el riesgo de sorpresas costosas en fases de despliegue. 🔹 7. Diseñar la nueva aplicación con principios de bajo acoplamiento La programación orientada a objetos, microservicios y arquitecturas basadas en eventos permiten diseñar aplicaciones nuevas con bajo acoplamiento y alta cohesión. Esto implica: Las funcionalidades de la nueva aplicación pueden evolucionar o escalar sin depender de cambios constantes en el sistema legado. Se reduce el riesgo de impactos negativos ante actualizaciones futuras del sistema legado. 🔹 8. Utilizar adaptadores y patrones de diseño orientados a integración Existen patrones de diseño en programación especialmente útiles para compatibilidad con sistemas legados: Adapter Pattern (Patrón de Adaptador): Permite transformar la interfaz de un sistema legado para que sea utilizable por la nueva aplicación. Facade Pattern (Patrón de Fachada): Ofrece una interfaz unificada y simplificada para un subsistema complejo. Bridge Pattern (Patrón de Puente): Desacopla la abstracción de su implementación para permitir cambios independientes. El uso de estos patrones facilita la integración y asegura un código mantenible y escalable. 🔹 9. Capacitación del equipo de desarrollo en sistemas legados Un riesgo crítico es que los programadores actuales desconozcan el lenguaje o la arquitectura del sistema legado. Es esencial: Capacitar al equipo en los fundamentos técnicos del sistema legado. Documentar exhaustivamente las estructuras, procesos y limitaciones de los sistemas existentes. Esto evita errores por desconocimiento y permite anticipar limitaciones técnicas durante la programación de la nueva aplicación. 🔹 10. Planificar estrategias de migración o sustitución gradual Finalmente, cada integración debe evaluarse como una oportunidad para planificar la migración de sistemas legados obsoletos: Diseña roadmaps de migración por etapas. Define procesos de doble escritura o sincronización temporal si es necesario. Identifica procesos críticos donde la migración debe minimizar el downtime. La integración no debe ser un fin en sí mismo, sino un paso estratégico hacia la modernización tecnológica completa. 📝 Conclusión estratégica Garantizar la compatibilidad de aplicaciones nuevas con sistemas legados requiere más que programación; exige una estrategia integral de arquitectura, negocio y talento. Para el gerente de tecnología, significa liderar proyectos que aseguren continuidad operativa, minimicen riesgos y permitan innovar sin sacrificar estabilidad. Con un enfoque de programación adecuado, cada integración se convierte en un peldaño hacia la transformación digital sostenible.

¿Cómo optimizar tiempos de desarrollo sin sacrificar calidad en programación de aplicaciones?

Optimizar los tiempos de desarrollo sin sacrificar calidad es un desafío estratégico que determina la competitividad y rentabilidad de cualquier organización. Para un gerente general, un CTO o un director de innovación, esta pregunta implica equilibrar velocidad, calidad, talento y estrategia de negocio. Veamos cómo lograrlo con enfoque gerencial, ejemplos reales y storytelling persuasivo: 🔹 1. Adoptar metodologías ágiles con disciplina y claridad estratégica Scrum, Kanban y metodologías ágiles son más que herramientas de moda. Su verdadero potencial emerge cuando se aplican con disciplina: Sprints bien definidos, con alcance realista y objetivos claros priorizados por valor al negocio. Daily meetings breves para eliminar bloqueos y alinear esfuerzos. Retrospectivas disciplinadas para mejorar procesos en cada ciclo. Storytelling real: Una empresa de logística en México redujo su tiempo de desarrollo en un 35% al aplicar Scrum disciplinado, con Product Owners capacitados en priorización estratégica. Antes, utilizaban Scrum solo como “reuniones diarias” sin priorización real, resultando en retrasos continuos. 🔹 2. Diseñar un Product Backlog orientado a valor y no a volumen Muchas empresas sobrecargan el backlog con funcionalidades no críticas. La optimización comienza con preguntas estratégicas: ¿Esta funcionalidad genera un impacto directo en clientes o procesos críticos? ¿Podemos lanzarla en una versión posterior sin afectar la experiencia de usuario? Un backlog minimalista pero orientado a valor permite lanzar productos funcionales más rápido y mejorar posteriormente basados en feedback real. 🔹 3. Fomentar la cultura DevOps para eliminar silos entre desarrollo y operaciones Implementar DevOps implica: Integración continua (CI) y despliegue continuo (CD), automatizando pruebas, builds y despliegues. Mayor colaboración entre desarrolladores, testers y personal de operaciones. Esto reduce tiempos muertos entre etapas, acelera la entrega y permite detectar errores tempranamente. Ejemplo real: Un retail regional implementó pipelines de CI/CD con AWS CodePipeline y Jenkins, reduciendo su tiempo de despliegue de 3 días a 45 minutos, sin sacrificar calidad gracias a pruebas automatizadas en cada commit. 🔹 4. Utilizar frameworks y librerías consolidadas Reinventar la rueda consume tiempo y recursos. La programación de aplicaciones debe aprovechar: Frameworks maduros y ampliamente utilizados, con gran soporte y comunidad activa. Librerías probadas para funcionalidades comunes (autenticación, interfaces, conectividad). Esto reduce errores, garantiza actualizaciones de seguridad y acorta los ciclos de programación. 🔹 5. Automatizar pruebas para reducir tiempos de validación La automatización de pruebas (unitarias, integración, funcionales) permite: Detectar fallos en etapas tempranas. Ejecutar pruebas completas en minutos, que manualmente tomarían horas. Liberar a testers para pruebas exploratorias de alto valor. Las empresas líderes implementan suites de testing automatizadas como parte del pipeline CI/CD para lograr entregas ágiles y seguras. 🔹 6. Aplicar el principio MVP (Producto Mínimo Viable) con visión estratégica Un MVP bien diseñado permite: Lanzar productos funcionales en menor tiempo. Obtener retroalimentación real de usuarios antes de invertir en funcionalidades no validadas. Reducir retrabajo y desarrollo de características sin valor tangible. Storytelling real: Una fintech peruana lanzó su app de pagos con funcionalidades mínimas validadas por sus primeros 500 usuarios en 4 semanas. Luego escaló nuevas funcionalidades basadas en datos reales, logrando un crecimiento sostenido sin sobrecargar tiempos ni presupuesto inicial. 🔹 7. Optimizar la arquitectura y la calidad técnica desde el inicio La presión de tiempo no justifica malas prácticas de programación. Por el contrario, una arquitectura sólida garantiza rapidez futura: Diseña estructuras modulares y desacopladas. Aplica principios SOLID y clean code. Define patrones de diseño y estándares de codificación compartidos por todo el equipo. Esto reduce deuda técnica y permite escalar nuevas funcionalidades rápidamente sin reprogramar todo el sistema. 🔹 8. Capacitar continuamente al equipo en tecnologías, frameworks y patrones La actualización constante del equipo técnico se traduce en: Menores tiempos de investigación durante el desarrollo. Mayor eficiencia al usar frameworks o librerías recientes. Menor rotación de personal, ya que los programadores se sienten motivados y valorados. Invertir en talento es acelerar proyectos con calidad. 🔹 9. Fomentar la revisión de código estructurada y colaborativa Code reviews bien implementadas: Elevan la calidad del código. Reducen errores críticos. Fortalecen la transferencia de conocimiento y nivelan competencias dentro del equipo. Para los gerentes de tecnología, este proceso se traduce en menos bugs en producción, menor gasto en mantenimiento y mayor confianza del negocio. 🔹 10. Monitorear y medir los KPIs de desarrollo Finalmente, no se puede mejorar lo que no se mide. Define KPIs como: Lead Time: tiempo desde el inicio de la programación hasta el despliegue. Cycle Time: tiempo que tarda una tarea individual en completarse. Velocidad del equipo: cantidad de puntos de historia completados por sprint. Tasa de fallos en producción: indicador clave de calidad. Monitorearlos en dashboards compartidos fomenta la mejora continua, eleva la transparencia y alinea al equipo con objetivos estratégicos. 📝 Conclusión estratégica Optimizar tiempos de desarrollo sin sacrificar calidad no es una cuestión de “trabajar más rápido”, sino de trabajar de forma más inteligente y estratégica. Involucra metodologías ágiles bien aplicadas, herramientas automatizadas, talento capacitado y liderazgo que prioriza el valor de negocio sobre el volumen de funcionalidades. Para un gerente general o CTO, esta disciplina es el camino directo a la innovación sostenible y la ventaja competitiva.

¿Cómo integrar Machine Learning en aplicaciones existentes sin rehacer toda su programación?

Integrar Machine Learning (ML) en aplicaciones existentes sin reprogramarlas completamente es un reto estratégico que muchas organizaciones enfrentan en su camino hacia la transformación digital. Para un gerente general, CTO o director de innovación, este desafío representa el equilibrio entre modernización tecnológica, optimización de recursos y generación de valor tangible al negocio. A continuación, exploramos cómo lograrlo con enfoque práctico, narrativo y estratégico: 🔹 1. Comprender el problema de negocio y la necesidad de ML Antes de plantear cualquier integración, define: ¿Cuál es el problema de negocio que se busca resolver? ¿Qué proceso puede ser optimizado con ML? ¿Cuál será su impacto en eficiencia, costos, satisfacción del cliente o ingresos? Storytelling real: Una aseguradora regional deseaba predecir la probabilidad de siniestros para mejorar su rentabilidad en pólizas. Sin embargo, su sistema de suscripción estaba en Java y reprogramarlo completamente era inviable. Identificaron el proceso exacto que requería ML y lo aislaron para integrarlo mediante APIs. 🔹 2. Diseñar modelos ML como servicios independientes (MLaaS) Una práctica efectiva es implementar el modelo de Machine Learning como un servicio independiente o microservicio que: Exista fuera de la aplicación principal. Sea accesible mediante APIs REST. Se mantenga en un servidor, contenedor o plataforma cloud especializada en ML (por ejemplo, AWS SageMaker, Azure ML, GCP AI Platform). Esto evita modificar la arquitectura de la aplicación original y permite escalar el modelo ML de forma independiente según demanda. 🔹 3. Construir pipelines de inferencia desacoplados de la aplicación base En lugar de integrar el modelo ML directamente en el backend o frontend de la aplicación: Diseña pipelines de inferencia donde la aplicación envía datos al servicio ML y recibe la respuesta procesada. Utiliza colas de mensajes (RabbitMQ, Kafka) para procesamientos asíncronos cuando la predicción no sea crítica en tiempo real. Esto minimiza el impacto en la programación existente y reduce riesgos operativos. 🔹 4. Utilizar APIs de ML preconstruidas para casos comunes Si el caso de uso es estándar (por ejemplo, reconocimiento de imágenes, análisis de sentimiento, clasificación de texto), aprovecha APIs de ML ya disponibles en la nube: AWS Rekognition, Comprehend, Lex Azure Cognitive Services Google Cloud Vision, Natural Language AI Estas APIs se integran mediante simples llamadas HTTP desde la aplicación, sin requerir reprogramación interna compleja. 🔹 5. Implementar SDKs o librerías ligeras si el lenguaje lo permite Cuando el lenguaje de programación de la aplicación es compatible (Python, Java, .NET), se pueden implementar SDKs que: Conecten con modelos ML almacenados en la nube o local. Realicen la inferencia directamente en el servidor de la aplicación. Sin embargo, esta opción requiere validar la capacidad de procesamiento de los servidores actuales para no afectar el rendimiento general. 🔹 6. Aprovechar contenedores y Kubernetes para despliegue modular Containerizar modelos ML con Docker y orquestarlos con Kubernetes facilita: Despliegue independiente de la aplicación principal. Escalabilidad automática según la demanda de predicciones. Actualizaciones y entrenamiento continuo sin afectar la operación del software base. Este enfoque se alinea con estrategias de microservicios y arquitecturas cloud-native. 🔹 7. Diseñar la integración con estándares de comunicación robustos Para garantizar compatibilidad y mantenimiento sencillo: Utiliza JSON o Protobuf como formatos de intercambio de datos. Define endpoints REST claros, documentados y versionados. Implementa autenticación y cifrado en todas las llamadas al servicio ML. Esto asegura la integridad y seguridad de la información, aspecto crítico en aplicaciones financieras, sanitarias o de datos sensibles. 🔹 8. Planificar la gestión de datos y su gobernanza Integrar ML no es solo cuestión de código, sino de datos: Define cómo se capturarán y limpiarán los datos para el modelo. Asegura el cumplimiento de políticas de privacidad (GDPR, Ley de Protección de Datos, HIPAA). Establece procesos de actualización y reentrenamiento de modelos con datos frescos. 🔹 9. Implementar monitoreo constante de los modelos ML Una vez integrado el modelo, monitoriza: Accuracy y performance en producción. Latencia de respuesta para asegurar que no degrade la experiencia de usuario. Deriva de datos (data drift) que pueda degradar su calidad predictiva. Existen herramientas como Prometheus + Grafana, SageMaker Model Monitor o Azure Monitor para realizar este seguimiento estratégico. 🔹 10. Capacitar al equipo de desarrollo y stakeholders en ML operacional Finalmente, para que la integración sea sostenible y rentable: Capacita a programadores en conceptos básicos de ML y MLOps. Entrena a stakeholders para interpretar resultados, limitaciones y posibles sesgos. Define un plan de gobernanza y ética en el uso de ML, alineado a la estrategia de la empresa. Storytelling real: Una cadena de supermercados integró un modelo de recomendación de productos en su app sin reprogramarla, exponiéndolo como microservicio en AWS. Su equipo fue capacitado en MLOps, logrando un incremento del 22% en ventas de productos sugeridos y una adopción fluida sin interrupción de su operación digital. 📝 Conclusión estratégica Integrar Machine Learning en aplicaciones existentes es una decisión de alto impacto que no requiere rehacer todo el sistema si se aplica estratégicamente. Se trata de modularizar, desacoplar, usar APIs y contenedores, y gobernar los datos con disciplina, generando beneficios reales sin arriesgar la estabilidad operativa. Para un gerente de tecnología o director general, esta integración inteligente es un paso firme hacia la innovación competitiva y sostenible.

¿Qué impacto tienen los containers en el desarrollo y despliegue de aplicaciones?

El uso de containers (contenedores) en el desarrollo y despliegue de aplicaciones ha transformado la forma en que las organizaciones crean, prueban, entregan y escalan software. Para un gerente general, CTO o director de innovación, comprender su impacto es clave para garantizar eficiencia, rapidez en el time-to-market y optimización de costos operativos. A continuación, analizamos su impacto con storytelling y un enfoque gerencial estratégico: 🔹 1. Portabilidad total del software en cualquier entorno Los containers encapsulan la aplicación junto con sus dependencias, librerías y configuraciones necesarias, creando un paquete portátil que se ejecuta de forma idéntica en: Entornos de desarrollo local Servidores on-premise Plataformas cloud (AWS, Azure, GCP) Storytelling real: Un banco regional desarrollaba microservicios Java que funcionaban en QA pero fallaban en producción por diferencias en configuraciones de servidores. Tras implementar containers con Docker, eliminaron esos problemas, reduciendo en un 60% los errores de despliegue. 🔹 2. Reducción drástica de errores por inconsistencias de entorno El clásico problema “en mi máquina funciona” desaparece. Al utilizar containers: Todo el stack (SO, librerías, dependencias) se define y empaqueta. No hay dependencia del sistema operativo o configuración de servidores externos. Los despliegues se vuelven confiables, replicables y predecibles. Esto minimiza riesgos en ambientes productivos y aumenta la estabilidad operativa, un beneficio clave para sectores financieros, salud o logística. 🔹 3. Mayor eficiencia en el uso de recursos de infraestructura A diferencia de las máquinas virtuales (VM), los containers: No requieren un sistema operativo completo por cada instancia. Comparten el kernel del host, siendo más livianos y rápidos. Pueden iniciarse en segundos, en lugar de minutos como las VMs. Esto permite a los directores de TI optimizar costos de infraestructura, ejecutar más instancias en menor hardware y escalar bajo demanda. 🔹 4. Facilitan la implementación de arquitecturas de microservicios Los containers son el complemento natural de los microservicios, ya que: Cada microservicio puede ejecutarse como un container independiente. Se facilita el despliegue autónomo, escalado y actualización sin afectar otros servicios. Permiten usar distintos stacks tecnológicos dentro de un mismo sistema (por ejemplo, Node.js para un servicio, Python para otro). Este modelo potencia la flexibilidad arquitectónica, clave para empresas que buscan innovar rápidamente. 🔹 5. Aceleran el ciclo de desarrollo y despliegue continuo (CI/CD) La combinación de containers y pipelines de CI/CD permite: Automatizar pruebas, builds y despliegues de forma segura y rápida. Realizar rollbacks inmediatos ante errores en producción. Entregar nuevas funcionalidades con mayor frecuencia y menor riesgo. Storytelling real: Un ecommerce regional implementó containers con Kubernetes y pipelines CI/CD, pasando de un despliegue mensual a 20 despliegues por semana sin afectar la estabilidad de su plataforma. 🔹 6. Mejoran la escalabilidad y resiliencia de las aplicaciones Con orquestadores como Kubernetes, los containers: Se replican automáticamente para manejar incrementos de tráfico. Se redistribuyen en nodos saludables ante fallas de hardware. Permiten balanceo de carga dinámico y escalamiento horizontal bajo demanda. Esto asegura la continuidad operativa y la calidad del servicio al usuario, incluso en picos de alta demanda. 🔹 7. Facilitan la adopción de DevOps y cultura ágil La contenedorización promueve prácticas DevOps, ya que: Desarrolladores y operaciones trabajan sobre la misma imagen de container. El versionamiento de containers garantiza trazabilidad y control. La entrega continua se convierte en un proceso confiable y automatizado. Este cambio cultural se traduce en mayor productividad y alineación con los objetivos estratégicos de innovación. 🔹 8. Incrementan la seguridad mediante aislamiento Cada container está aislado del host y de otros containers. Esto: Limita el impacto de vulnerabilidades a un solo container. Permite aplicar políticas de seguridad específicas por microservicio. Facilita auditorías y gestión de cumplimiento normativo (por ejemplo, PCI DSS, HIPAA). 🔹 9. Optimizan los costos operativos y de licenciamiento Gracias a su bajo consumo de recursos y escalabilidad bajo demanda: Se reduce la necesidad de servidores físicos o virtuales sobredimensionados. Se optimizan costos de licencias asociadas a sistemas operativos o hipervisores. Se paga solo por la capacidad utilizada en entornos cloud. Este ahorro puede reinvertirse en innovación o en la mejora de la experiencia de usuario. 🔹 10. Preparan a la organización para estrategias cloud-native y multi-cloud Finalmente, los containers son la base de arquitecturas modernas como: Cloud-native: aplicaciones diseñadas para operar en la nube de forma óptima. Multi-cloud: despliegues en múltiples proveedores para evitar dependencia de un solo vendor. Edge computing: despliegue de microservicios en dispositivos edge mediante contenedores livianos. Para un gerente general, esta capacidad significa mayor resiliencia operativa, flexibilidad contractual con proveedores y expansión estratégica sin limitaciones tecnológicas. 📝 Conclusión estratégica Los containers han revolucionado el desarrollo y despliegue de aplicaciones, convirtiéndose en una ventaja competitiva para las empresas que los adoptan. Su impacto se traduce en rapidez, escalabilidad, eficiencia, seguridad y reducción de costos operativos. Integrarlos en la estrategia tecnológica es un paso clave para garantizar la sostenibilidad e innovación en un mercado cada vez más digitalizado.

¿Cómo asegurar el mantenimiento eficiente de aplicaciones programadas internamente?

El mantenimiento eficiente de aplicaciones programadas internamente es un factor crítico para la continuidad operativa, la innovación sostenible y la optimización de costos en toda empresa. Para un gerente general, CTO o director de sistemas, este desafío implica equilibrar tecnología, talento y procesos con visión estratégica. Veamos cómo lograrlo con storytelling real y recomendaciones prácticas: 🔹 1. Diseñar aplicaciones con arquitectura limpia y modular desde el inicio El mantenimiento eficiente comienza desde la concepción de la aplicación: Aplicar principios SOLID y clean code. Diseñar la arquitectura de manera modular, permitiendo cambios en un módulo sin afectar el resto del sistema. Separar capas de presentación, lógica de negocio y acceso a datos, evitando acoplamientos innecesarios. Storytelling real: Una cadena farmacéutica desarrolló su ERP internamente. Su arquitectura monolítica dificultaba agregar nuevas funcionalidades, requiriendo pruebas completas ante cada cambio. Tras migrarlo gradualmente a microservicios, su mantenimiento se redujo un 45% en tiempo y un 30% en costo. 🔹 2. Documentar exhaustivamente el código y los procesos de negocio Un código no documentado es una bomba de tiempo para la operación: Documenta clases, métodos y estructuras de datos. Registra diagramas de flujo de procesos críticos, reglas de negocio y excepciones. Utiliza herramientas de documentación automática (Swagger para APIs, Javadoc, Sphinx) para mantener actualizado el conocimiento técnico. Esto garantiza que nuevas incorporaciones al equipo puedan realizar mantenimiento o evolutivos sin dependencia exclusiva de los programadores originales. 🔹 3. Establecer un plan de mantenimiento preventivo y correctivo Define un plan estratégico con: Mantenimiento preventivo: actualizaciones de seguridad, optimización de base de datos, refactorización de código para eliminar obsolescencia. Mantenimiento correctivo: resolución de bugs detectados por usuarios o monitoreo. Mantenimiento adaptativo: ajustes ante cambios normativos o integración con nuevos sistemas. Un mantenimiento planificado reduce costos emergentes, asegura la estabilidad y prolonga la vida útil de la aplicación. 🔹 4. Implementar control de versiones y gestión de configuración La gestión de versiones con herramientas como Git es indispensable: Permite rastrear cambios, identificar responsables y revertir errores. Facilita la colaboración simultánea de varios programadores sin conflictos. Ofrece respaldo ante fallos en nuevas versiones, garantizando continuidad de la operación. 🔹 5. Automatizar pruebas para prevenir errores en producción Implementa pruebas automatizadas (unitarias, de integración y funcionales) que se ejecuten con cada cambio en el código: Detectan errores antes de desplegar a producción. Reducen la dependencia de testing manual, liberando tiempo de los QA para pruebas exploratorias. Garantizan que nuevas actualizaciones no afecten funcionalidades existentes. 🔹 6. Monitorear constantemente el rendimiento y la experiencia del usuario El mantenimiento eficiente requiere visibilidad constante. Implementa: Monitoreo de performance (CPU, memoria, tiempos de respuesta). Alertas de errores y caídas en tiempo real. Herramientas APM (Application Performance Monitoring) como New Relic, Datadog o AppDynamics. Storytelling real: Un marketplace de moda detectó con New Relic que un servicio de búsqueda tardaba 8 segundos. Tras optimizar su consulta SQL y ajustar la lógica de negocio, la latencia bajó a 500ms, aumentando la tasa de conversión en un 12%. 🔹 7. Capacitar y actualizar continuamente al equipo de desarrollo El mantenimiento eficiente depende del conocimiento actualizado: Programa capacitaciones periódicas en tecnologías utilizadas. Incentiva la certificación en frameworks o lenguajes críticos para la empresa. Fomenta la rotación interna en distintos módulos para reducir la dependencia de programadores clave. Esto mitiga el riesgo de rotación de talento y garantiza sostenibilidad operativa. 🔹 8. Gestionar la deuda técnica como parte de la estrategia Toda aplicación acumula deuda técnica con el tiempo. Gestionarla implica: Identificar y priorizar tareas de refactorización en cada sprint. No postergar indefinidamente ajustes necesarios en la arquitectura o el código. Balancear las prioridades de negocio con la salud técnica de la aplicación. Un sistema con alta deuda técnica se vuelve inmantenible, incrementando los costos futuros y reduciendo la capacidad de innovación. 🔹 9. Implementar políticas claras de control de cambios y despliegues Define procesos y flujos de aprobación para: Controlar quién realiza cambios y cómo se documentan. Revisar código antes de integrarlo a ramas productivas. Realizar despliegues en ambientes de staging antes de producción. Esto reduce errores críticos, tiempos de indisponibilidad y costos de recuperación ante fallas. 🔹 10. Planificar la evolución tecnológica y migraciones futuras Finalmente, el mantenimiento eficiente contempla el futuro: Evalúa la obsolescencia de frameworks y librerías utilizadas. Planifica migraciones tecnológicas antes de que el soporte finalice. Diseña roadmaps de modernización progresiva (por ejemplo, migrar módulos a microservicios, refactorizar código legacy). Esto asegura la continuidad del negocio y mantiene a la empresa competitiva en el mercado digital. 📝 Conclusión estratégica Asegurar el mantenimiento eficiente de aplicaciones programadas internamente no es un proceso aislado, sino una estrategia integral que combina arquitectura limpia, documentación exhaustiva, talento capacitado, automatización y visión de evolución tecnológica. Para un gerente general o CTO, invertir en estos pilares es garantizar continuidad operativa, eficiencia financiera y la capacidad de innovar constantemente sin fricciones ni riesgos críticos.

¿Cómo desarrollar aplicaciones cumpliendo normativas internacionales de privacidad y protección de datos?

Desarrollar aplicaciones cumpliendo normativas internacionales de privacidad y protección de datos es hoy un imperativo estratégico y legal. Para un gerente general, CTO o director de cumplimiento, esta responsabilidad implica mitigar riesgos financieros y reputacionales, asegurar continuidad operativa y proteger la confianza de clientes y usuarios. A continuación, se detalla cómo lograrlo con enfoque práctico, estratégico y storytelling real de empresas: 🔹 1. Comprender las normativas aplicables al negocio y su alcance territorial Cada aplicación debe desarrollarse alineada a las regulaciones donde opera la organización o sus usuarios: GDPR (Reglamento General de Protección de Datos de la UE): aplica a empresas con usuarios en la UE, incluso si no tienen sede allí. CCPA (Ley de Privacidad del Consumidor de California): para empresas con usuarios en California. LGPD (Brasil), Ley de Protección de Datos Personales (Perú), Ley Federal de Protección de Datos (México) y otras. Storytelling real: Un ecommerce latinoamericano lanzó su app sin cumplir GDPR para sus compradores en España. Fue multado con €250,000 y debió rediseñar su flujo de consentimiento, además de enfrentar pérdida de reputación en la región. 🔹 2. Diseñar la aplicación aplicando el principio de Privacy by Design Privacy by Design implica integrar la privacidad en cada etapa del desarrollo de software: Minimizar la recolección de datos (solo los estrictamente necesarios). Implementar configuraciones de privacidad como predeterminadas. Diseñar procesos claros para consentimiento y retiro del mismo. Esto garantiza que la privacidad no sea un añadido posterior, sino un principio base del producto digital. 🔹 3. Implementar mecanismos de consentimiento informado y granular Las normativas exigen que el usuario: Sea informado sobre qué datos se recopilan, para qué y por cuánto tiempo. Pueda consentir de forma explícita, libre y específica cada uso de sus datos. Tenga la opción de retirar su consentimiento en cualquier momento. En la práctica: Diseña pantallas claras de consentimiento. Evita casillas premarcadas o consentimientos globales ambiguos. 🔹 4. Garantizar los derechos ARCO y su cumplimiento técnico Los usuarios tienen derecho a: Acceso: conocer qué datos suyos se almacenan. Rectificación: corregir datos inexactos. Cancelación: eliminar datos que no deseen mantener en la plataforma. Oposición: oponerse al uso de sus datos para fines específicos. Desde programación, esto implica: Diseñar APIs y procesos que permitan ejecutar estos derechos. Integrar workflows automatizados que reduzcan tiempos de respuesta a solicitudes. 🔹 5. Aplicar el principio de minimización y limitación de almacenamiento La aplicación debe programarse para: Almacenar solo los datos necesarios para la funcionalidad o el servicio. Eliminar o anonimizar datos una vez finalizado el propósito que justificó su recolección. Configurar políticas automáticas de retención y eliminación en bases de datos. 🔹 6. Implementar medidas de seguridad organizativas y técnicas robustas Las normativas exigen proteger los datos personales contra: Accesos no autorizados. Procesamientos indebidos. Pérdida o destrucción accidental. En programación y arquitectura de software, esto significa: Encriptación de datos en tránsito (SSL/TLS) y en reposo. Uso de hash seguro para contraseñas (bcrypt, Argon2). Control de acceso basado en roles (RBAC) y políticas de privilegio mínimo. 🔹 7. Diseñar procesos para reportar brechas de seguridad En caso de violaciones de seguridad (data breaches), las normativas exigen: Notificar a autoridades y usuarios en tiempos que varían de 72 horas (GDPR) a plazos definidos por cada país. Documentar la brecha, su causa, impacto y acciones correctivas. Desde programación, se debe: Monitorear accesos y actividades sospechosas. Generar logs seguros y trazables. Integrar procesos de alerta automática en casos de incidentes críticos. 🔹 8. Realizar evaluaciones de impacto en privacidad (DPIA) cuando aplique Si la aplicación procesa datos sensibles o a gran escala, la normativa exige realizar un DPIA que analice: Los riesgos potenciales para los derechos y libertades de los usuarios. Las medidas técnicas y organizativas para mitigarlos. Este proceso se realiza en conjunto con el área de cumplimiento y debe quedar documentado como parte de la gobernanza de datos corporativa. 🔹 9. Capacitar a los programadores y equipos de producto en privacidad y protección de datos El cumplimiento no es solo de TI, sino cultural y estratégico: Capacita al equipo en las normativas que impactan al negocio. Realiza sesiones de diseño con expertos legales y de privacidad desde la fase de discovery. Define estándares de codificación segura alineados con las normativas aplicables. 🔹 10. Monitorear y actualizar la aplicación continuamente ante cambios normativos Las leyes evolucionan. Un desarrollo compliant hoy puede quedar obsoleto mañana. Para garantizar cumplimiento: Realiza auditorías internas y externas periódicas. Mantente actualizado sobre nuevas normativas (por ejemplo, AI Act en UE, leyes de privacidad en países de LATAM en 2025). Ajusta flujos de recolección, procesamiento y eliminación de datos según sea requerido. Storytelling real: Una empresa de telemedicina reprogramó su app para cumplir HIPAA y GDPR antes de su expansión internacional. Este enfoque proactivo generó confianza en inversores y redujo sus riesgos legales al ingresar al mercado europeo. 📝 Conclusión estratégica Desarrollar aplicaciones cumpliendo normativas internacionales de privacidad y protección de datos es una ventaja competitiva, no solo un requisito legal. Demuestra compromiso ético, protege la confianza de usuarios, evita multas millonarias y fortalece la reputación corporativa. Para un gerente general, CTO o director de cumplimiento, integrar estas prácticas desde la concepción del producto es garantía de sostenibilidad y liderazgo en un mercado global cada vez más regulado y consciente de la privacidad.

¿Qué influencia tiene la programación concurrente en la eficiencia de aplicaciones corporativas?

La programación concurrente es un paradigma esencial para el desarrollo de aplicaciones corporativas eficientes, escalables y competitivas en un mercado digital que exige velocidad y procesamiento intensivo. Para un gerente general, CTO o director de innovación, su dominio representa una ventaja estratégica que impacta directamente la calidad del servicio, la experiencia del usuario y los costos operativos. A continuación, exploramos su influencia con enfoque práctico y storytelling gerencial:

🔹 1. Definición estratégica: ¿qué es la programación concurrente?

La programación concurrente permite que una aplicación ejecute múltiples tareas al mismo tiempo (o aparente hacerlo), utilizando:

Hilos (threads) múltiples.

Procesos independientes.

Eventos asíncronos y callbacks.

Esto habilita que el software aproveche mejor los recursos del sistema, aumentando su rendimiento y capacidad de respuesta.

🔹 2. Mejora en la eficiencia y rendimiento de las aplicaciones

Las aplicaciones corporativas suelen realizar múltiples tareas simultáneamente, como:

Procesar transacciones financieras.

Consultar bases de datos remotas.

Generar reportes masivos.

Atender miles de solicitudes concurrentes de usuarios.

La programación concurrente permite que estas tareas se realicen sin bloquear la ejecución general, optimizando el tiempo de CPU y memoria disponible.

Storytelling real: Un ecommerce implementó programación concurrente en su motor de búsqueda, permitiendo procesar consultas de catálogo y recomendaciones simultáneamente. La latencia se redujo de 2.3 segundos a 450 ms, incrementando la tasa de conversión en un 18%.

🔹 3. Incremento en la capacidad de procesamiento de grandes volúmenes de datos

En entornos de big data o analytics, la programación concurrente permite:

Procesar múltiples lotes de datos en paralelo.

Realizar análisis y generación de insights más rápido.

Reducir el tiempo de ejecución de reportes críticos de horas a minutos.

Para los gerentes, esto significa decisiones más rápidas, basadas en datos actualizados y relevantes en tiempo real.

🔹 4. Mejora de la experiencia del usuario final

En aplicaciones con interfaces gráficas o móviles, la programación concurrente evita que:

La interfaz se congele mientras se procesan tareas pesadas.

Las acciones del usuario se bloqueen mientras se espera respuesta de servidores.

Esto mejora la percepción de fluidez, profesionalismo y calidad de la aplicación, factores críticos para retención de clientes.

🔹 5. Facilitación de arquitecturas modernas y microservicios

La programación concurrente es un habilitador técnico de:

Microservicios que procesan múltiples solicitudes simultáneas.

Arquitecturas basadas en eventos y mensajería asincrónica (Kafka, RabbitMQ).

Despliegues escalables en contenedores y orquestadores como Kubernetes.

🔹 6. Reducción de costos operativos en infraestructura

Al permitir mayor procesamiento en menos tiempo y con menor uso de hardware:

Se optimiza la utilización de servidores locales o cloud.

Se reduce la necesidad de escalar hardware para atender picos de demanda.

Se aprovechan los núcleos múltiples de CPUs modernas de manera más eficiente.

Este ahorro puede reinvertirse en innovación o expansión de negocio.

🔹 7. Desafíos estratégicos de la programación concurrente

A pesar de sus ventajas, su implementación requiere planificación:

Condiciones de carrera (race conditions): errores que ocurren cuando varios hilos acceden a datos compartidos sin sincronización adecuada.

Deadlocks (bloqueos mutuos): cuando dos o más procesos se esperan mutuamente indefinidamente.

Complejidad en el diseño y debugging: la concurrencia eleva la complejidad del sistema y requiere programadores capacitados.

🔹 8. Lenguajes y frameworks que potencian la programación concurrente

Para aplicaciones corporativas, destacan:

Java: con sus threads, ejecutores y frameworks como Spring WebFlux para programación reactiva.

C#: con async/await y TPL (Task Parallel Library).

Python: con threading, multiprocessing y asyncio para tareas asíncronas.

Go: diseñado con concurrencia como filosofía base gracias a sus goroutines.

Node.js: modelo de event loop asíncrono no bloqueante ideal para aplicaciones I/O intensivas.

🔹 9. Aplicaciones corporativas que más se benefician de la concurrencia

Sistemas bancarios de procesamiento de transacciones.

Plataformas de ecommerce con catálogos extensos y tráfico masivo.

Apps de logística que consultan múltiples APIs simultáneamente.

Softwares de analítica avanzada y procesamiento de big data.

🔹 10. Estrategia gerencial para implementar programación concurrente eficientemente

Para maximizar su impacto y minimizar riesgos:

Capacita a los programadores en patrones de concurrencia y sincronización segura.

Diseña la arquitectura considerando el modelo de ejecución concurrente desde el inicio.

Utiliza herramientas de profiling y debugging especializadas en concurrencia.

Realiza pruebas de estrés para identificar cuellos de botella y race conditions.

Establece KPIs de performance y eficiencia antes y después de su implementación.

Storytelling real: Un operador logístico integró programación concurrente en su motor de ruteo, procesando 150,000 pedidos diarios en 30 minutos en lugar de 3 horas. Esto optimizó su SLA de entregas y mejoró la satisfacción de grandes retailers aliados, asegurando su renovación de contrato anual.

📝 Conclusión estratégica

La programación concurrente transforma la eficiencia operativa de aplicaciones corporativas, permitiendo mayor velocidad, escalabilidad y mejor experiencia de usuario, al tiempo que reduce costos de infraestructura. Para un gerente general o CTO, su adopción planificada es un paso decisivo para competir con rapidez y calidad en un mercado cada vez más exigente y digitalizado.

🧾 Resumen Ejecutivo

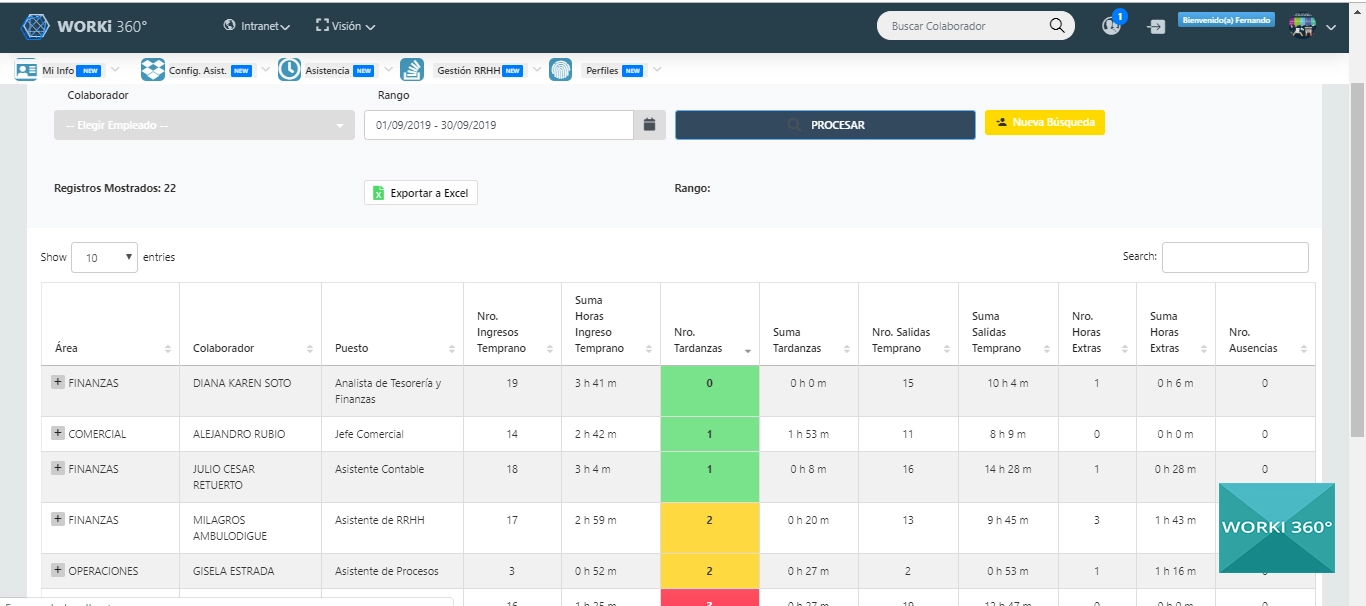

El presente artículo analizó en profundidad 10 aspectos críticos del software de programación de aplicaciones, con enfoque en su impacto estratégico, operacional y financiero, alineados al posicionamiento de WORKI 360 como plataforma de desarrollo organizacional, transformación digital y optimización de procesos.

Elección de frameworks adecuados: Se concluyó que la elección de frameworks debe estar alineada a los objetivos de negocio, considerando escalabilidad, talento disponible, comunidad y costos de licenciamiento, para evitar retrabajo y garantizar sostenibilidad de los proyectos.

Programación orientada a objetos y escalabilidad: Este paradigma permite modularidad, reusabilidad, herencia y polimorfismo, asegurando aplicaciones flexibles y mantenibles, reduciendo tiempos y costos de evolutivos futuros, clave para empresas en crecimiento continuo.

Integración de IA generativa: La IA generativa acelera el ciclo de desarrollo, potencia la creatividad de los equipos y reduce costos operativos, generando soluciones innovadoras y time-to-market más rápidos, consolidando la competitividad de la empresa.

Compatibilidad con sistemas legados: Garantizar integración con sistemas existentes mediante APIs, microservicios y patrones de diseño como adapter o facade, asegura continuidad operativa, estabilidad y reduce riesgos de implementación, habilitando la modernización progresiva.

Optimización de tiempos sin sacrificar calidad: La combinación de metodologías ágiles, DevOps, automatización de testing y planificación estratégica del backlog permite entregas rápidas y robustas, alineadas al valor de negocio.

Integración de Machine Learning sin reprogramar aplicaciones: Desplegar modelos como microservicios o MLaaS facilita su adopción sin alterar arquitecturas existentes, generando predicciones y automatización inteligentes con mínimo impacto operativo.

Impacto de los containers: Los containers revolucionan el desarrollo y despliegue de aplicaciones al aportar portabilidad, escalabilidad, reducción de costos y facilitación de arquitecturas de microservicios y estrategias cloud-native, asegurando flexibilidad y resiliencia.

Mantenimiento eficiente de aplicaciones internas: Un mantenimiento estratégico requiere arquitectura modular, documentación exhaustiva, automatización de pruebas, gestión de deuda técnica y capacitación constante del talento, garantizando sostenibilidad y reducción de costos.

Cumplimiento de normativas de privacidad y protección de datos: La integración de Privacy by Design, seguridad robusta, mecanismos de consentimiento y gobernanza de datos asegura el cumplimiento de GDPR, CCPA, LGPD y otras, protegiendo la reputación y evitando multas millonarias.

Programación concurrente y eficiencia operativa: Permite procesar múltiples tareas simultáneamente, optimizando recursos de infraestructura, mejorando tiempos de respuesta y habilitando arquitecturas escalables, clave en fintech, retail, logística y corporativos de alto tráfico.

✅ 🔷 Beneficio para WORKI 360

La comprensión y aplicación de estos enfoques posiciona a WORKI 360 como un aliado estratégico de empresas que buscan:

Maximizar la productividad y calidad de sus equipos de desarrollo.

Garantizar cumplimiento normativo y seguridad en sus aplicaciones.

Innovar con tecnologías de vanguardia como IA generativa, ML, containers y programación concurrente.

Reducir costos operativos y acelerar el time-to-market de sus soluciones digitales.

Así, WORKI 360 se consolida como un facilitador de transformación digital y competitividad sostenible en organizaciones de cualquier sector.